Olivier Talagrand, Jean Pailleux, Yves Dandonneau et le Club des Argonautes

Résumé en langage courant

Depuis plusieurs décennies, la qualité des prévisions météorologiques ne cesse de s’améliorer progressivement. À quoi cette amélioration est-elle due ? Quelles sont les limites actuelles ? À quoi ces limites sont-elles dues, et peut-on encore les reculer ? À plus longue échéance, est-il possible de prévoir les étés humides et les hivers doux ? Et qu’en est-il du climat dans 30, 50 ou 100 ans, objet désormais de débats et de préoccupations intenses ? Ce sont là quelques-unes des questions auxquelles cette note est destinée à fournir des éléments de réponse, tout en dressant un bref bilan des connaissances actuelles.

Les prévisions au jour le jour sont actuellement utiles jusqu’à une huitaine de jours, contre cinq jours il y a une trentaine d’années. Les prévisions météorologiques s’appuient nécessairement sur la connaissance des conditions de départ, qui s’est considérablement améliorée avec le développement des réseaux d’observations, satellites notamment. L’augmentation de la puissance de calcul a aussi permis de calculer l’évolution de l’atmosphère et de l’océan sur des grilles plus fines, plus proches de la taille des phénomènes, et d’introduire dans ces calculs davantage de processus. Toutefois, ces améliorations butent sur un constat : des variations infimes des conditions initiales conduisent à des prévisions très différentes, ce qu’on exprime souvent par : «le battement d’aile d’un papillon peut déclencher un cyclone au loin dix jours plus tard». L’atmosphère présente des instabilités, dont l’évolution est très difficile à prévoir. Malgré ces limites, la prévision de l’évolution du climat global à long terme est possible, car elle dépend davantage de l’évolution des flux d’énergie que des conditions initiales. Ainsi peut-on modéliser la réponse du climat de la Terre à l’augmentation de la teneur en gaz carbonique de l’atmosphère. Enfin, il existe dans le climat actuel des modes de variabilité, comme El Niño, ou l’oscillation nord atlantique, auxquels sont attachés des types de temps, permettant de proposer des prévisions saisonnières.

Sommaire

1. La prévision météorologique aujourd'hui

2. La sensibilité aux conditions initiales

3. La prévisibilité climatique

4. La prévisibilité mensuelle et saisonnière

5. Conclusion

1 - La prévision météorologique aujourd’hui

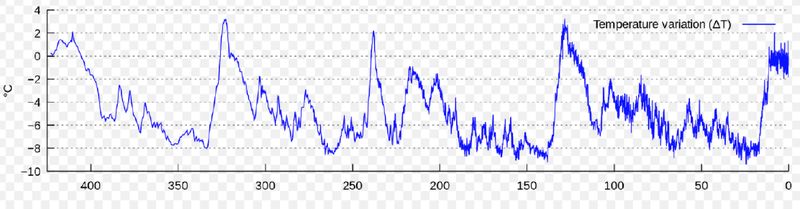

La Figure 1, qui est une version actualisée d’une figure incluse dans une FAQ antérieure (Que sont les modèles numériques de circulation de l’atmosphère et de l’océan? Comment sont-ils construits et utilisés ?), présente l’évolution de la qualité des prévisions produites depuis 1981 par le Centre européen pour les prévisions météorologiques à moyen terme (CEPMMT).

Ces prévisions sont issues d’un modèle numérique qui, mis en route à partir des conditions observées un jour donné, calcule de proche en proche l’évolution de l’écoulement atmosphérique sur les jours suivants. Le diagnostic présenté porte sur le géopotentiel (altitude) de la surface isobare 500 hPa, qui sépare l’atmosphère en deux couches de masses à peu près égales. Cette quantité, et ses variations spatiales, constituent une représentation relativement simple, et utile, de l’écoulement atmosphérique à grande échelle.

La quantité portée sur l’axe vertical de la Figure est (en termes un peu simplifiés) le coefficient de corrélation statistique entre les géopotentiels prévu et observé à un instant donné. Ce coefficient prendrait la valeur 1 pour une prévision parfaite, et la valeur 0 pour une prévision choisie au hasard dans l’ensemble des états possibles. Plus il est élevé, et plus la prévision du modèle est bonne. Les différentes courbes de la figure présentent à partir du haut l’évolution de la corrélation à 3, 5, 7 et 10 jours d’échéance. Pour chacune de ces échéances, deux courbes, séparées par une bande de couleur, montrent la corrélation sur les hémisphères boréal (courbe du haut) et austral (courbe du bas) respectivement.

Figure 1. Variations depuis 1981 de la qualité des prévisions du géopotentiel à 500 hPa effectuées par le CEPMMT (ECMWF en anglais) (voir explications dans le texte ; noter que l’échelle verticale est dilatée dans la partie supérieure de la Figure) (source : ECMWF).

On voit que la qualité des prévisions s’est lentement mais régulièrement améliorée, dans les deux hémisphères, à toutes les échéances présentées. Cette amélioration est due à l’augmentation de la quantité et de la qualité des observations, ainsi qu’à celle de la qualité du modèle numérique utilisé. L’amélioration du modèle est elle-même due en grande partie à l’augmentation de la puissance des moyens de calcul.

Si donc la prévision météorologique est difficile, il est clair qu’elle peut être améliorée. Mais quelles sont au départ les difficultés ? Pourquoi peut-on prévoir les éclipses plusieurs siècles à l’avance, mais ne peut-on pas prévoir précisément la pluie quelques jours à l’avance ? La complexité du système atmosphérique, où interagissent en permanence absorption et émission de rayonnement, changements de phase de l‘eau et échanges de chaleur associés, échanges d’eau et d’énergie avec le milieu sous-jacent, ainsi que d’innombrables autres processus, y est certainement pour quelque chose. Et l’amélioration de la qualité des prévisions visible sur la Figure 1 est précisément due, en partie, à l’introduction progressive dans les modèles numériques d’une quantité croissante de ces nombreux processus.

2 - La sensibilité aux conditions initiales

Mais il y a beaucoup plus fondamental, comme l’a montré un travail célèbre effectué en 1963, au début de l’ère du calcul électronique scientifique, par le météorologiste et mathématicien états-unien E. N. Lorenz. Celui-ci (comme déjà raconté dans la note Théologie et atmosphère) avait développé un modèle numérique de petite dimension (3 en l’occurrence, alors que la dimension de certains des modèles actuels de prévision météorologique dépasse le milliard), qui donnait une représentation idéalisée du phénomène de convection thermique se produisant dans une couche fluide chauffée par sa face inférieure. Effectuant un nouveau calcul à partir de résultats intermédiaires qu’il avait conservés en mémoire, il constata que ce nouveau calcul produisait des résultats tout à fait différents de ceux du calcul d’origine. Il crut d’abord à une erreur de codage, qu’il ne put trouver, et finit par comprendre que le problème venait de ce que les résultats intermédiaires à partir desquels il avait refait son calcul avaient une précision moins grande que celle du calcul d’origine. Retirer les dernières décimales des résultats intermédiaires (ou plus précisément, dans le cas présent, leurs derniers chiffres binaires) avait totalement transformé les résultats de la prévision. Partant d’une observation fortuite (on parle de plus en plus, suivant l’anglais, de sérendipité), et poursuivant sa réflexion, E. N. Lorenz avait mis en évidence la sensibilité des prévisions aux conditions initiales. Sensibilité décrite par l’image du désormais célèbre effet papillon. Un papillon bat des ailes. La perturbation qu’il crée dans l’air ambiant s’amplifie et gagne progressivement des échelles spatiales de plus en plus grandes, avec la conséquence qu’un cyclone apparaît une dizaine de jours plus tard là où rien ne se serait passé si le papillon n’avait pas battu des ailes.

La sensibilité aux conditions initiales n’était d’ailleurs pas une notion pleinement nouvelle. Le mathématicien Henri Poincaré avait écrit en 1908, dans son livre Science et Méthode, précisément à propos de la météorologie, les lignes suivantes :

"Pourquoi les météorologistes ont-ils tant de peine à prédire le temps avec quelque certitude ? Pourquoi les chutes de pluie, les tempêtes elles-mêmes nous semblent-elles arriver au hasard, de sorte que bien des gens trouvent tout naturel de prier pour avoir la pluie ou le beau temps, alors qu’ils jugeraient ridicule de demander une éclipse par une prière ? Nous voyons que les grandes perturbations se produisent généralement dans les régions où l’atmosphère est en équilibre instable. Les météorologistes voient bien que cet équilibre est instable, qu’un cyclone va naître quelque part ; mais où, ils sont hors d’état de le dire ; un dixième de degré en plus ou en moins en un point quelconque, le cyclone éclate ici et non pas là, et il étend ses ravages sur des contrées qu’il aurait épargnées. Si on avait connu ce dixième de degré, on aurait pu le savoir d’avance, mais les observations n’étaient ni assez serrées, ni assez précises, et c’est pour cela que tout semble dû à l’intervention du hasard."

Mais il s’agissait de la part d’Henri Poincaré d’une intuition, fondée sur sa grande expérience scientifique, plutôt que d’une pleine découverte. Lorenz, lui, avait mis en évidence la sensibilité aux conditions initiales de façon pleinement objective.

Passer d’un système idéalisé à trois paramètres, simulant la convection thermique, à l’atmosphère dans sa totalité constituait certes un pas audacieux, qu’E. N. Lorenz franchit néanmoins. Il alla même plus loin. Augmenter la résolution spatiale des conditions initiales diminue l’erreur initiale de la prévision. Mais, sur la base de considérations quant à la vitesse à laquelle une perturbation de petite échelle spatiale se propage progressivement vers des échelles plus grandes, Lorenz conclut que le taux de croissance de l’erreur augmenterait du même coup, et suffisamment rapidement pour qu’il y ait une limite ultime à la prévision. Il estima cette limite à une quinzaine de jours.

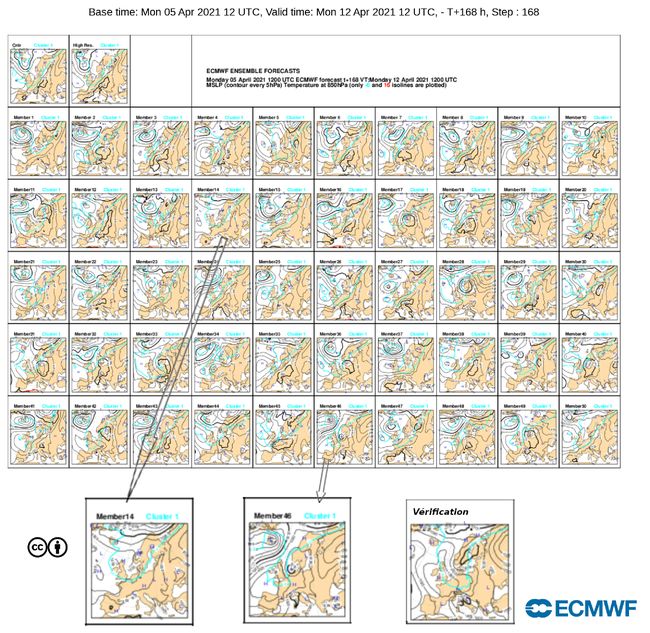

Cette conclusion a été largement confirmée, directement ou indirectement, par de nombreux travaux ultérieurs. La Figure 2 présente le résultat d’une prévision d’ensemble récemment effectuée au CEPMMT (voir encart). On y voit dans la partie supérieure le résultat de 52 prévisions numériques effectuées, pour la même date, à échéance de 7 jours. La quantité représentée est le champ de pression au niveau de la mer sur l‘Europe occidentale (le modèle utilisé est, lui, global). À la résolution de la figure, les différences entre les conditions initiales de ces différentes prévisions seraient invisibles à l’œil.

Figure 2. Prévision d’ensemble produite par le CEPMMT (ECMWF en anglais), à échéance de 7 jours, pour le 12 Avril 2021. Le champ représenté est la pression au niveau de la mer sur l’Europe. La partie supérieure de la figure présente 52 prévisions effectuées à partir de conditions initiales différentes et de petites perturbations dans la ‘physique’ du modèle de prévision. Les trois cartes du bas présentent, à gauche, deux des prévisions de l’ensemble, agrandies pour améliorer leur lisibilité et, à droite, la "vérification’ observée" à l’échéance de la prévision (source : ECMWF).

Mais on voit que les champs montrés sur la figure, même si beaucoup d’entre eux ont une structure similaire, avec une zone de hautes pressions dans la région considérée, présentent néanmoins des différences marquées. Les éléments 14 et 46 (agrandis dans la partie inférieure de la figure) sont par exemple tout à fait différents, particulièrement dans les latitudes élevées. Ces deux éléments sont eux-mêmes très différents de la "vérification observée" à l’échéance de la prévision, représentée en bas à droite de la figure. La sensibilité aux conditions initiales est présente, sinon dans l’atmosphère elle-même (l’expérience directe serait difficile à effectuer …), du moins dans les modèles numériques, qui constituent, de loin, le meilleur outil dont nous disposons pour la prévision météorologique.

Les prévisions d’ensemble

Le document présenté en figure 2 (appelé souvent document «timbres poste» ) est un outil de base utilisé par les prévisionnistes pour évaluer d’un simple coup d’œil l’incertitude associée à une prévision numérique d’un événement météorologique particulier sur un domaine donné. Associé à d’autres documents plus synthétiques issus de la même prévision d’ensemble, (et avec la carte de vérification en moins!), il permet d’effectuer des prévisions probabilistes, comme d’estimer la probabilité d’un événement extrême. Les documents du CEPMMT sont accessibles en temps réel sur le lien suivant (en choisissant dans le menu de la colonne de gauche «Medium» pour « Range » et «Combined» pour «Product type») : Charts catalogue

Depuis le début des années 1990, la prévision d’ensemble est utilisée quotidiennement dans beaucoup de centres météorologiques. Le site web «meteociel» rassemble une vaste collection de documents provenant de différents modèles opérationnels et de différents systèmes de prévision d’ensemble, permettant de suivre en temps réel la prévision du temps en mode déterministe ou en mode probabiliste.

Ainsi, le menu de la colonne de gauche permet de visualiser les deux principaux modèles opérationnels aujourd’hui à Météo-France, «Arpège» et «Arome», ainsi que les systèmes de prévision d’ensemble associés. Ces derniers sont répertoriés dans le menu météociel sous les noms «PEARP» et «PE-AROME».

L'expérience montre que, si la dispersion des prévisions d’ensemble varie d'une situation à l'autre, elle est fiable, en ce sens que l'erreur de la prévision centrale est statistiquement petite quand la dispersion est petite, et grande quand la dispersion est grande.

Une étude systématique a récemment été effectuée sur deux parmi les meilleurs modèles numériques actuels de prévision météorologique (Zhang et al., 2019). La prévisibilité de chacun des modèles a été évaluée par comparaison de prévisions effectuées par le même modèle à partir de conditions initiales très voisines, à des résolutions spatiales différentes. La qualité des prévisions de l’écoulement des latitudes moyennes ne s’améliore plus au-delà d’une quinzaine de jours, quelle que soit la résolution spatiale utilisée. Comme anticipé par Lorenz, augmenter la résolution spatiale des conditions initiales conduit à des gains de plus en plus faibles, et finalement à une saturation, la croissance des erreurs augmentant à mesure que l’échelle spatiale diminue.

On peut constater que cette limite d’une quinzaine de jours se situe encore bien au-delà de l’échéance visible sur la Figure 1. Celle-ci suggère que des progrès significatifs sont encore possibles (mais probablement au coût élevé requis par une augmentation significative des moyens d’observations et de calcul).

Le travail de Lorenz de 1963, même s’il ne constituait pas une découverte totalement nouvelle, eut un immense impact qui s’étendit bien au-delà des sciences de l’atmosphère, et fut à l’origine du développement, théorique, numérique et expérimental, de ce que l’on appelle la théorie du chaos déterministe. Ce développement doit évidemment beaucoup à la disponibilité de moyens de calcul puissants. On sait maintenant que la sensibilité aux conditions initiales et la prévisibilité finie sont en fait omniprésentes dans le monde physique. On s’est par exemple ainsi rendu compte que la prévisibilité des mouvements des planètes, longtemps considérée comme l’archétype même du succès de la prévision déterministe, était aussi limitée, mais à des échéances de dizaines ou centaines de millions d’années, bien plus longues que celle de l’histoire des sociétés humaines (cette prévisibilité finie des mouvements des planètes avait d’ailleurs été pressentie, elle aussi, par H. Poincaré dans son livre Science et Méthode ; voir la note Théologie et atmosphère citée plus haut). Le travail de Lorenz a clairement montré que déterminisme mathématique n’implique pas nécessairement prévisibilité de fait.

Par quels mécanismes une petite erreur initiale s’amplifie-t-elle jusqu’à contaminer l’écoulement atmosphérique dans son entier ? Les mouvements de l’atmosphère (ainsi que ceux de l’océan) résultent d’instabilités, causées elles-mêmes par l’échauffement différentiel entre différentes parties du fluide. Dans le cas de l’atmosphère, une instabilité locale, mais importante, est l’instabilité convective, qui résulte de l’absorption du rayonnement solaire par le milieu sous-jacent (continent ou océan), et de l’échauffement qui en résulte. Des mouvements ascendants rapides apparaissent dans l’atmosphère, qui transportent de la chaleur vers le haut, et sont compensés par des mouvements de subsidence d’extension horizontale plus grande. Les mouvements ascendants sont à l’origine des formations nuageuses que sont les cumulus, et des orages qui les accompagnent. Peu affectés en général par la rotation terrestre, ils s’étendent sur des échelles horizontales de quelques kilomètres ou dizaines de kilomètres, et des échelles temporelles de quelques heures. L’instabilité convective est l’un des processus par lequel une erreur très localisée se propage à des échelles plus grandes.

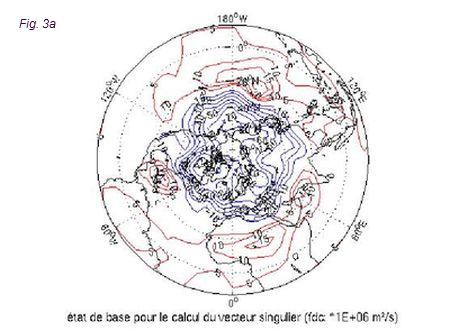

Un autre processus important est l’instabilité barocline, qui résulte, elle, du gradient de température entre les hautes et les basses latitudes. Fortement influencée par la rotation terrestre, elle est à l’origine des zones de hautes et de basses pressions qui dominent la météorologie des latitudes moyennes. Les mouvements associés ont des échelles spatiales typiques de quelques milliers de kilomètres, et des échelles temporelles de quelques jours. Ils transportent globalement de l’énergie depuis les basses latitudes vers les latitudes plus élevées. La figure 3 présente un exemple idéalisé d’instabilité barocline. Pour un état de l’atmosphère donné, représenté sur la figure 3a (le champ représenté est, comme pour la figure 1, le géopotentiel de la surface isobare 500 hPa), on a déterminé, à l’aide d’un modèle numérique de l’écoulement, la perturbation qui croîtrait le plus rapidement sur une période de 36 heures (le mode singulier dominant). Cette perturbation virtuelle, localisée à l’endroit le plus instable de l’écoulement pour l’état considéré, est représentée sur la figure 3b. Et ce qu’elle devient au bout de 36 heures est représenté sur la figure 3c. Son extension spatiale s’est étendue. Mais surtout son amplitude a augmenté, avec un taux d’amplification globale de 5,4. C’est l’amplification permanente de petites incertitudes de ce genre, plus petites que la précision des observations de départ, qui conduit à la dégradation rapide des prévisions météorologiques. Ce sont d’ailleurs ces instabilités, beaucoup plus que les imperfections propres des modèles numériques en tant que tels, qui sont là importantes. Comme le montre le travail de Zhang et al., un modèle parfait, en ce sens qu’il rendrait exactement compte des lois physiques qui régissent l’écoulement, conduirait aux mêmes résultats.

Figure 3. Un exemple de croissance de l’erreur sous l‘effet de l’instabilité barocline. a. Géopotentiel à 500hPa de la situation considérée. b. Structure de la perturbation initiale s’amplifiant le plus rapidement sur 36h. c. Évolution correspondante au bout de 36h (courtoisie L. Descamps, Météo-France)

Pour autant, si les deux processus d’instabilité décrits ci-dessus contribuent de façon significative à l’amplification d’une petite erreur initiale locale, toutes les prévisions ne se dégradent pas à la même vitesse. Certaines situations sont plus prévisibles que d’autres, et c’est bien pour cela que les grands services météorologiques produisent des prévisions d’ensemble, du type de celle qui a été présentée sur la Figure 2, afin de prévoir l’’erreur du jour’. La vaste question de la prévisibilité des différentes situations atmosphériques, et de l’échéance à laquelle différents phénomènes (tornades, cyclones tropicaux, tempêtes associées à des dépressions, …) peuvent être prévus, est de la plus grande importance pour la météorologie quotidienne. Elle mériterait des développements détaillés qui pourraient faire l'objet d'un nouvel article. et n’est pas discutée dans la présente note.

Indépendamment de l’incertitude présente dans les conditions initiales d’une prévision, les modèles, on l’a dit, ne sont pas parfaits, et ne peuvent jamais être des simulateurs exacts de l’atmosphère. Et les erreurs de modélisation, même si elles ne sont pas principalement responsables de la croissance rapide initiale des erreurs de prévision, ont aussi leur impact. Les modèles s’améliorent progressivement par l’augmentation de leur résolution spatiale et du nombre de processus physiques qu’ils sont capables de simuler. Mais il reste des limitations. On en trouve beaucoup, par exemple, dans le cycle de l’eau et les multiples effets qui lui sont associés : échanges d’énergie dus aux changements de phases, effets radiatifs des multiples types de nuages, échange d’eau avec le milieu sous-jacent, etc. Il y aura toujours de telles limitations, qui s’ajouteront à l’instabilité fondamentale de l’écoulement atmosphérique.

Le lecteur désireux d’en savoir plus sur les performances actuelles des prévisions météorologiques pourra trouver des informations sur les sites du CEPMMT (forecast) ou de Météo-France (modèles de prévision).

3. La prévisibilité climatique

S’il existe une limite ultime d’une quinzaine de jours, comment peut-on prétendre prévoir le climat plusieurs décennies à l’avance, comme il est fait par exemple dans les rapports successifs du Groupe d'experts intergouvernemental sur l'évolution du climat (GIEC) ? C’est là une objection qui a effectivement été opposée aux travaux du GIEC. On peut simplement remarquer que le cycle des saisons est prévisible bien au-delà d’une quinzaine de jours. Et cette remarque fournit elle-même la réponse : le cycle des saisons est déterminé par la quantité d’énergie reçue du Soleil, et non par l’état actuel de l’atmosphère.

C’est là toute la différence entre météorologie et climat, déjà discutée dans une autre FAQ du site des Argonautes (Quelle est la différence entre «météorologie» et «climatologie»). Cette différence peut être expliquée, de façon certes simplifiée mais non fondamentalement erronée, sur une phénomène aussi banal que l’ébullition d’une casserole d’eau. L’ébullition produit un ensemble turbulent de bulles qui grossissent et éclatent, au-dessus desquelles se forment des volutes de gouttelettes d’eau. L’évolution des bulles et des volutes individuelles est imprévisible et impossible à contrôler. Mais le taux global d’évaporation est, lui, prévisible et contrôlable si l’on peut agir précisément sur la quantité de chaleur transmise à la masse d’eau, et sur la température et la ventilation de l’air environnant. Dans cette comparaison simple, les bulles et les volutes d’eau constituent la ‘météorologie’, tandis que le taux d’évaporation qui en résulte constitue le ‘climat’.

Ce qui détermine le climat de la Terre, ce sont fondamentalement les flux d’énergie entre les différentes composantes du système terrestre (atmosphère, océans, cryosphère et compartiments internes à ces composantes) : absorption de l’énergie reçue du Soleil, puis transport et échange de cette énergie entre les différentes composantes du système, et réémission finale vers l’espace extérieur.

Les flux instantanés dépendent de l’état présent du système, mais leurs valeurs statistiques à long terme sont déterminées par tout un ensemble d’éléments, tels que la composition de l’atmosphère et de l’océan, la position des montagnes et des continents, les propriétés du sol, la quantité d’eau disponible, et beaucoup d’autres encore. C’est ainsi que l’on peut affirmer que l’augmentation du contenu de l’atmosphère en CO2, en augmentant l’absorption par l’atmosphère du rayonnement infrarouge émis par le sol et les couches inférieures, conduit à un échauffement global de l’atmosphère et des océans. Ce ne sont pas les mêmes causes qui déterminent le temps qu’il fera dans une semaine, et ce que sera le climat, moyenné sur dix ou vingt ans, dans cinquante ou cent ans de maintenant.

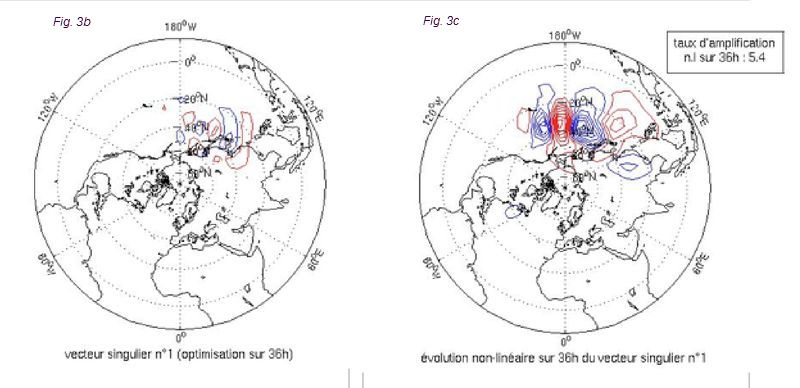

Peut-on alors prévoir, par exemple, l’occurrence d’un nouvel âge glaciaire ? La figure 4 montre les variations de la température de l’atmosphère sur les 400 000 dernières années, obtenues à partir d’un carottage effectué dans la calotte antarctique. On y voit des oscillations plus ou moins régulières, mais particulièrement un cycle d’environ 100 000 ans, qui est en accord avec la théorie astronomique des variations des climats (voir la FAQ Quelle est la cause de l'alternance de périodes chaudes et de glaciations sur Terre lors du dernier million d'années ?).

Nous sortons actuellement d’une phase chaude, et l’on peut donc s’attendre, après le réchauffement actuel dû aux activités humaines, à un nouvel âge glaciaire dans 80 à 100 000 ans de maintenant. Dans notre compréhension actuelle, les âges glaciaires commencent quand les paramètres orbitaux de la Terre favorisent un enneigement hivernal abondant dans l’hémisphère nord, suivi d’un été relativement frais. L’effet d’albédo de la neige favorise le maintien de celle-ci pendant l’été, et l’amplification de l’enneigement. Si donc les conditions d’apparition d’un âge glaciaire semblent assez prévisibles, la chute de neige particulière, ou la séquence de chutes, qui l’enclenchera est évidemment, elle, imprévisible.

Figure 4. Variations de la température de l’atmosphère sur les 400 000 dernières années, telles que déduites du carottage Vostok en Antarctique (figure extraite de Petit et al., 1999). Échelle horizontale : date dans le passé, en milliers d’années (le présent est à l’extrémité droite de l’axe).

Pour la prévision météorologique, une connaissance précise de l’état initial est indispensable. Pour la prévision du climat, une telle connaissance n’est pas nécessaire, au moins dans notre compréhension actuelle : ce sont les flux d’énergie, définis par l’insolation et les échanges internes au système climatique, qui importent.

4. La prévisibilité mensuelle et saisonnière

Si le cycle des saisons est évidemment prévisible, il n’en reste pas moins que les saisons varient d’une année à l’autre. Il y a des hivers rudes et des hivers doux, des étés pluvieux et des étés caniculaires. Quelle est l'origine de ces variations et, surtout, sont-elles prévisibles ? Plusieurs oscillations, plus ou moins régulières, ont été mises en évidence sur des échelles temporelles allant de quelques mois à quelques années. La plus connue de ces oscillations est probablement le phénomène El Niño. Tous les trois à cinq ans environ, vers la fin du mois de décembre, le courant froid (courant de Humboldt) qui remonte habituellement du Sud au large des côtes du Pérou est remplacé par des eaux chaudes habituellement situées plus à l’Ouest. Ce phénomène est dû à un affaiblissement des alizés, qui soufflent vers l’Ouest. Il est associé à un basculement de la pression atmosphérique sur l’Océan Pacifique Équatorial (baisse de pression à l’Est et augmentation à l’Ouest), qu’on appelle l’Oscillation Australe. Le phénomène El Niño, dont les effets se font ressentir sur un an ou plus, modifie significativement la météorologie locale, et particulièrement les précipitations. Mais, au-delà, il a un impact sur les deux continents américains, l’Asie, l’Océan Atlantique et même l’Europe.

D’autres oscillations plus ou moins régulières sont observées à différentes échelles de temps et d’espace. L’oscillation de Madden-Julian module la pluviosité des océans tropicaux sur des périodes de 40 à 50 jours. L’oscillation Nord-Atlantique, sur des temps typiques d’une dizaine d’années, modifie la position et la trajectoire des dépressions et des anticyclones de l’Océan Atlantique. Des ‘régimes de temps’ lui sont plus ou moins corrélés, qui possèdent statistiquement des durées de vie et des transitions mutuelles préférentielles. C’est un de ces régimes de temps, associé à la présence d’un anticyclone sur l’Europe du Nord, qui produit par exemple les vagues de froid intenses qui frappent quelquefois en hiver l’Europe occidentale.

Toutes ces oscillations résultent d’interactions, pour la plupart encore mal comprises, entre l’océan et l’atmosphère. Ces interactions induisent des modes de variabilité qui n’existeraient pas si l’atmosphère ou l’océan étaient seuls. C’est le cas en particulier du phénomène El Niño.

Ces oscillations diverses ne sont guère prévisibles à l’avance. Mais, une fois établies, elles possèdent un certain de degré de prévisibilité statistique quant à leur évolution et à leur durée. Et certaines situations permettent plus qu’une prévision purement statistique : on a pu montrer par exemple, a posteriori, que la canicule qui a frappé l’Europe Occidentale, et particulièrement la France, au mois d’août 2003 était due en partie à un déficit de pluviométrie du printemps précédent, qui avait rendu le sol particulièrement sec. Il y a là un élément de prévisibilité potentielle.

Les ressources de la modélisation numérique ont bien entendu été mises en œuvre pour les échéances mensuelles et saisonnières. Des modèles couplant océan et atmosphère sont intégrés sur ces échéances. La définition des conditions initiales des prévisions est ici encore importante. Ces modèles possèdent une prévisibilité faible, mais réelle. Cette prévisibilité est le plus visible sur des prévisions d’ensemble, dont les moyennes contiennent un signal statistique identifiable, par exemple sur la température ou la pluviosité des mois à venir. Les prévisions d’ensemble mensuelles et saisonnières effectuées par le CEPMMT peuvent être examinées en temps réel grâce à différents produits disponibles sur le web suivant (choisir le type de produits dans le menu de la colonne de gauche) : ECMWF-open charts

Mais il n’en reste pas moins que les processus physiques qui déterminent les fluctuations atmosphériques sur des échelles mensuelles, saisonnières ou annuelles restent très mal connus, et que la prévision de ces fluctuations reste la ‘zone grise’ de la prévision.

5. Conclusion

La prévisibilité de l’atmosphère et de l’océan est fondamentalement une question d’échelles spatiales et temporelles. Sans simplification excessive, on peut dire que plus l’échelle spatiale est grande, plus la prévisibilité temporelle est élevée. Mais les processus physiques qui déterminent la prévisibilité et ses limites varient avec les échelles considérées. Pour la météorologie ordinaire, où l’on peut considérer que l’atmosphère est un fluide homogène dans le temps et dans l’espace, c’est la croissance chaotique d’incertitudes initiales de petite échelle spatiale qui limite la prévisibilité. Si l’atmosphère était un fluide homogène situé au-dessus d’un milieu homogène, sans fluctuations des flux d’énergie qu’il reçoit, sa prévisibilité resterait entièrement limitée aux quinze jours que l’on a dit. Le cas d’un océan isolé serait probablement le même, avec des échelles temporelles pouvant atteindre, pour la circulation profonde, des valeurs séculaires. Mais l’atmosphère et l’océan, et le système climatique dans son ensemble, ne sont homogènes ni dans l’espace ni dans le temps. En plus du cycle saisonnier, évident, des phénomènes physiques spécifiques sont présents aux différentes échelles, et leur ajoutent une certaine prévisibilité : interactions (mal comprises, mais présentes) entre l’océan et l’atmosphère aux échelles mensuelles, saisonnières et interannuelles, variations aux échelles millénaires, encore plus mal comprises (mais clairement visibles sur la Figure 4 où elles se superposent au cycle dominant de 100 000 ans), variations des paramètres orbitaux de la Terre aux échelles climatiques. À plus longue échéance encore, ce sont la tectonique et la position des continents qui importent.

Le problème de la prévisibilité de l’atmosphère et de l’océan, on le voit, est partiellement résolu, mais partiellement seulement. Et il est d’autant plus important de s’employer à le résoudre au mieux que l’on sait désormais qu’il a des implications majeures pour le devenir des sociétés humaines.

Références

Petit, J.-R., J. Jouzel, D. Raynaud, N. I. Barkov, J.-M. Barnola, I. Basile, M. L. Bender, J. A. Chappellaz, J. C. Davis, G. Delaygue, M. Delmotte, V. Kotlyakov, M. R. Legrand, V. Ya. Lipenkov, C. Lorius, L. Pepin, C. Ritz, E. S. Saltzman et M. Stiévenard, 1999, Climate and atmospheric history of the past 420,000 years from the Vostok ice core, Antarctica. Nature, 399(6735), 429-436, 399(6735), 429-436, 399(6735), 429-436,

Zhang, F., Y. Q. Sun, L. Magnusson, R. Buizza, S.-J. Lin, J.-H. Chen, et K. Emanuel, 2019: What is the predictability limit of midlatitude weather? J. Atmos. Sci., 76, 1077–1091, 76, 1077–1091.