De nouveaux outils bouleversent le paysage scientifique

Jacques Merle, Bruno Voituriez, Yves Dandonneau, Club des Argonautes - Septembre 2013

Les technologies d’observation de la Terre firent des progrès spectaculaires au cours de la deuxième moitié du XXème siècle.

Les sciences de la Terre étaient encore jeunes et reposaient à la fois sur des observations relevant des sciences dites naturelles, proches de la géographie, et sur des conceptualisations théoriques issues de la physique.

C’est le propre des «géophysiques» de s’appuyer sur cette dualité «géo» et «physique» avec cependant une limitation fondamentale par rapport à la physique : l’impossibilité de mener des expériences réelles sur le milieu naturel pour tester des hypothèses ou vérifier expérimentalement la validité de concepts théoriques comme on peut le faire en laboratoire..

D’où l’importance, on le verra plus loin, des simulations numériques par les calculateurs électroniques pour réaliser des expériences virtuelles.

Ce sont donc les ordinateurs, introduits dans les laboratoires à partir des années 1960, qui contribuèrent rapidement à rattacher la question climatique à la physique et à la géophysique.

Parallèlement les observations ont également changé de nature avec les satellites d’observation de la Terre assurant une couverture globale et continue dans l’espace et le temps de l’observation de nombreux paramètres météorologiques et climatiques. Les avancées de la connaissance dans les sciences de la Terre ont donc été tributaires avant tout des progrès de l’instrumentation pour le calcul et de l’observation.

C’est particulièrement vrai en ce qui concerne le comportement dynamique des deux milieux fluides, l’atmosphère et l’océan, qui enveloppent la sphère terrestre.

Pour l’atmosphère les progrès vinrent principalement des capacités nouvelles de la modélisation numérique et des observations à partir des plateformes spatiales alors que les moyens d’observations traditionnels in situ ne firent pas l’objet de révolutions technologiques majeures.

Pour l’océan, le choc technologique fut encore plus marqué tant le retard était grand à la fois dans les techniques d’observations de ce milieu difficile d’accès et dans les concepts fondamentaux qui gouvernaient sa dynamique.

Pour prendre un exemple, on peut remarquer que jusque dans les années 1960, les marins et les océanographes faisaient encore le point sur leurs navires en visant les étoiles avec un sextant, un instrument mis au point au 18éme siècle et assez semblable à l’astrolabe qu’utilisaient les premiers explorateurs fondateurs de l’océanographie, partis du Portugal ou d’Espagne cinq siècles plus tôt pour offrir à leur roi de nouvelles terres à coloniser, en vérifiant en passant que la Terre était bien ronde !

Aujourd’hui on localise très précisément un navire avec un système GPS qui fait appel à une noria de satellites gravitant autour de la Terre. En 50 ans on a changé de monde. On imagine aisément que des évolutions technologiques aussi rapides aient pu avoir un impact décisif sur l’avancée des connaissances de la Terre.

On traitera séparément les deux domaines ayant le plus bénéficié de ces avancées technologiques : la modélisation et les observations spatiales pour l’atmosphère et l’océan, les deux milieux les plus déterminants dans le changement climatique en cours.

1 - La modélisation

Les sciences de l’atmosphère et de l’océan furent à l’avant-garde de ce qui a été appelé la «modélisation numérique» et ont servi de banc d’essais aux premiers développements de l’informatique.

C’est une page de l’histoire du XXème siècle qui s’est écrite autour des premières tentatives d’utilisation de ces machines à calculer, applications directes de l’électronique et de son industrie naissante. Les calculateurs électroniques firent leur apparition opérationnelle et pratique dans les laboratoires et les centres de recherche au début des années 1960. Mais avant cela, la préhistoire de la modélisation numérique s’est déroulée aux Etats Unis autour d’une machine électronique unique, l’ENIAC.

1-1 Tout commence à Princeton à partir d’une étrange machine, l’ENIAC (Electronic Numerical Integrator Analyser and Computer)

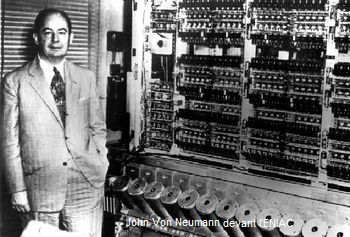

Le plus célèbre et le premier des calculateurs électroniques, l’ENIAC, sorte de prototype d’ordinateur antédiluvien fonctionnant avec des lampes, croisa, à la fin des années 1940, le parcourt d’un mathématicien génial, John Von Neumann, qui était accueilli à Princeton à l’«Institut for Advanced Study – IAS», où travaillaient, entre autres, Albert Einstein et le mathématicien Kurt Gödel.

Le plus célèbre et le premier des calculateurs électroniques, l’ENIAC, sorte de prototype d’ordinateur antédiluvien fonctionnant avec des lampes, croisa, à la fin des années 1940, le parcourt d’un mathématicien génial, John Von Neumann, qui était accueilli à Princeton à l’«Institut for Advanced Study – IAS», où travaillaient, entre autres, Albert Einstein et le mathématicien Kurt Gödel.

L’ENIAC, assemblage d’une «quincaillerie» faite de plusieurs dizaines d’armoires bourrées de circuits électroniques et de lampes, avait été construit et installé par les militaires américains au sein de l’Université de Pennsylvanie avant d’être transféré, prêt à l’emploi dès 1947, à Aberdeen, Maryland, dans un laboratoire militaire de recherche balistique. J.V.Neumann, proche des militaires – Il était un des scientifiques clé du projet Manhattan à Los Alamos - suivait attentivement la construction et l’évolution de cette machine dans l’espoir de l’utiliser pour résoudre numériquement les équations gouvernant le fluide atmosphérique afin de pouvoir ainsi prévoir le temps automatiquement.

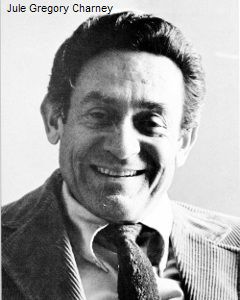

Pour aller dans le sens de ce rêve, il avait créé au sein de l’IAS un «Meteorology Group» qui devint en 1946 un «Meteorological Research Project» financé par la défense au sein de l’IAS. Dans ce contexte il organisa, en 1946 une «Conference on Meteorology» qui fut un événement dans le milieu des sciences de l’atmosphère et séduisit un jeune physicien devenu météorologue, Jule Charney, également passionné par les possibilités de cette machine. Neumann intégra Charney dans son groupe qui rejoignit ainsi l’IAS.

Pour aller dans le sens de ce rêve, il avait créé au sein de l’IAS un «Meteorology Group» qui devint en 1946 un «Meteorological Research Project» financé par la défense au sein de l’IAS. Dans ce contexte il organisa, en 1946 une «Conference on Meteorology» qui fut un événement dans le milieu des sciences de l’atmosphère et séduisit un jeune physicien devenu météorologue, Jule Charney, également passionné par les possibilités de cette machine. Neumann intégra Charney dans son groupe qui rejoignit ainsi l’IAS.

Charney à son tour attira un jeune doctorant en mathématique, Joseph Smagorinsky et l’invita aussi à le rejoindre dans cet institut pour tenter, avec cette machine, de résoudre numériquement les équations simplifiées de la circulation atmosphérique, qu’il avait mises au point lui même. Rien ne garantissait que ce soit possible, mais sous le leadership de Neumann, le groupe avec Charney et Smagorinsky se donna l’objectif de résoudre numériquement ces équations et de simuler l’atmosphère de façon suffisamment réaliste pour envisager de prévoir son évolution, substituant ainsi à la prévision météorologique empirique ce qu’ils appelèrent la «Numerical Weather Prediction», la prévision numérique.

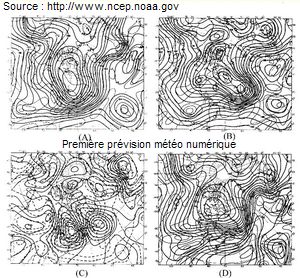

Beaucoup de travail fut nécessaire et les équations de Charney durent être sauvagement simplifiées, mais les résultats furent à la hauteur des espoirs suscités. Le groupe de l’IAS constitué autour de Neumann, Charney et Smagorinsky, renforcé par d’autres collaborateurs de l’IAS, décida de se déplacer en mission à Aberdeen auprès de l’ENIAC, munis des autorisations de l’armée, pour enfin implanter le programme de Charney sur le calculateur. Ils partirent en mars 1950 et, après quelques jours de préparation et la perforation de milliers de cartes, ils lancèrent enfin le programme qui tourna pendant ... 33 jours, 24 heures sur 24 seulement interrompu par le remplacement des inévitables lampes grillées... Mais ils arrivèrent à simuler une évolution (prévision) de 24 heures de l’état de l’atmosphère dont ils étaient partis. Le résultat était donc concluant. Il était démontré qu’il était pratiquement possible de simuler et de prévoir l’évolution du temps en utilisant une machine, un calculateur électronique. C’était un événement considérable qui prit une dimension historique sur laquelle se construisit la modélisation numérique aux États Unis et dans le monde avec l’essor d’un institut spécialisé de la NOAA, le «Geophysical Fluid Dynamic Laboratory – GFDL» dont l’origine et le développement mérite d’être conté.

Beaucoup de travail fut nécessaire et les équations de Charney durent être sauvagement simplifiées, mais les résultats furent à la hauteur des espoirs suscités. Le groupe de l’IAS constitué autour de Neumann, Charney et Smagorinsky, renforcé par d’autres collaborateurs de l’IAS, décida de se déplacer en mission à Aberdeen auprès de l’ENIAC, munis des autorisations de l’armée, pour enfin implanter le programme de Charney sur le calculateur. Ils partirent en mars 1950 et, après quelques jours de préparation et la perforation de milliers de cartes, ils lancèrent enfin le programme qui tourna pendant ... 33 jours, 24 heures sur 24 seulement interrompu par le remplacement des inévitables lampes grillées... Mais ils arrivèrent à simuler une évolution (prévision) de 24 heures de l’état de l’atmosphère dont ils étaient partis. Le résultat était donc concluant. Il était démontré qu’il était pratiquement possible de simuler et de prévoir l’évolution du temps en utilisant une machine, un calculateur électronique. C’était un événement considérable qui prit une dimension historique sur laquelle se construisit la modélisation numérique aux États Unis et dans le monde avec l’essor d’un institut spécialisé de la NOAA, le «Geophysical Fluid Dynamic Laboratory – GFDL» dont l’origine et le développement mérite d’être conté.

Encouragé par le retentissement de ce premier succès avec l’ENIAC, le service national de météorologie américain, le «US Weather Bureau», invita Joseph Smagorinsky, en 1953, à le rejoindre pour lui confier la tâche de créer une unité spéciale en son sein, le «Joint Numerical Weather Prediction Unit», dédié au développement de la prévision numérique. Après des expériences plus ou moins réussies et réalistes de modèles régionaux, le groupe s’attaqua à la réalisation d’un modèle global de circulation de l’atmosphère, appelé «Global Circulation Model - GCM». Le premier GCM connu date de 1955, très simplifié et ne comportant que deux couches sur la verticale, la paternité en revient à Norman Phillips, un météorologue qui avait aussi rejoint le groupe de Smagorinsky. Fort de ce succès, Smagorinsky créa une section particulière du «US weather Bureau», la «General Circulation Research Section» originellement située au Maryland dont il devint naturellement le directeur.

Encouragé par le retentissement de ce premier succès avec l’ENIAC, le service national de météorologie américain, le «US Weather Bureau», invita Joseph Smagorinsky, en 1953, à le rejoindre pour lui confier la tâche de créer une unité spéciale en son sein, le «Joint Numerical Weather Prediction Unit», dédié au développement de la prévision numérique. Après des expériences plus ou moins réussies et réalistes de modèles régionaux, le groupe s’attaqua à la réalisation d’un modèle global de circulation de l’atmosphère, appelé «Global Circulation Model - GCM». Le premier GCM connu date de 1955, très simplifié et ne comportant que deux couches sur la verticale, la paternité en revient à Norman Phillips, un météorologue qui avait aussi rejoint le groupe de Smagorinsky. Fort de ce succès, Smagorinsky créa une section particulière du «US weather Bureau», la «General Circulation Research Section» originellement située au Maryland dont il devint naturellement le directeur.

Cette section rejoignit Washington, changea de nom deux fois pour s’appeler successivement «General Circulation Research Laboratory» en 1959 et enfin en 1963 «Geophysical Fluid Dynamic Laboratory – GFDL», avant de rejoindre de nouveau l’Université de Princeton en 1968, toujours avec Smagorinsky comme directeur. Le GFDL était définitivement fixé à Princeton, et allait devenir, après son rattachement à la récente NOAA, le temple de la modélisation des fluides géophysiques sous la conduite de son directeur avisé, Joseph Smagorinsky qui, entre autres qualités, savait détecter les talents ; il recruta en 1959 un jeune japonais de l’Université de Tokyo, Syukuro Manabe, pour prendre en charge la modélisation climatique et un peu plus tard, en 1961, un océanographe venant de Woods Hole, Kurk Brian, pour la modélisation de l’océan. Ils devinrent l’un et l’autre les figures de proue mondialement reconnues de la modélisation de l’atmosphère, de l’océan et du climat.

1-2 Les avancées décisives des pionniers de la modélisation au GFDL

Avec ce noyau de jeunes scientifiques de grands talents, le GFDL était lancé et allait devenir un institut de recherche prestigieux dédié à l’étude des fluides géophysiques, l’atmosphère et l’océan.

Il devint rapidement la référence mondialement reconnue de la modélisation numérique. Et après que l’ancêtre des calculateurs, l’ENIAC, ait été rangé dans un musée, le GFDL, grâce à ses résultats et à l’habileté de son directeur, réussit à demeurer à la pointe de la technologie du calcul électronique et à toujours posséder les ordinateurs les plus puissants au monde issus des avancées de l’industrie des semi-conducteurs.

Comment imaginer rencontre plus étonnante et cependant fructueuse que celle de cette nouvelle technologie révolutionnaire et d’un objectif initialement aussi inaccessible :

celui de comprendre et de simuler la dynamique des fluides entourant la planète pour prévoir leur évolution et ultérieurement leurs interactions dans la dynamique du climat ?

Le défi était immense, mais le talent et la chance étaient là et les promesses furent tenues ; c’est au GFDL que la modélisation de l’atmosphère, puis de l’océan, et ensuite de leur couplage, put être réalisée en premières mondiales, stimulant à sa suite d’autres institutions de par le monde.

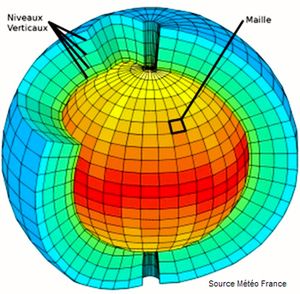

La première étape de cette avancée commença en 1963 avec la modélisation de la circulation générale de l’atmosphère et la prévision numérique du temps qui firent des progrès décisifs avec un modèle hémisphérique de 9 couches sur la verticale. On avait fait un premier pas qui permit de franchir une nouvelle étape et de s’attaquer à la modélisation du climat. On a vu que cet objectif avait été confié à Manabe par Smagorinsky. Mais pour modéliser le climat, il fallait passer par la modélisation de l’océan et c’était l’océanographe Kirk Bryan qui en était chargé.

La première étape de cette avancée commença en 1963 avec la modélisation de la circulation générale de l’atmosphère et la prévision numérique du temps qui firent des progrès décisifs avec un modèle hémisphérique de 9 couches sur la verticale. On avait fait un premier pas qui permit de franchir une nouvelle étape et de s’attaquer à la modélisation du climat. On a vu que cet objectif avait été confié à Manabe par Smagorinsky. Mais pour modéliser le climat, il fallait passer par la modélisation de l’océan et c’était l’océanographe Kirk Bryan qui en était chargé.

Kirk Bryan, le premier océanographe du GFDL, recruta un informaticien de grand talent, Michael Cox, et ensemble ils tentèrent de développer ce que les spécialistes appellent un «code», c'est-à-dire un programme susceptible de résoudre numériquement des équations, en l’occurrence celles décrivant les mouvements du fluide géophysique qu’est l’océan mondial, collé à une sphère tournante, la Terre, et bordé par des frontières continentales.

Ils réussirent assez rapidement des avancées et en 1967 ils publièrent le premier modèle tri-dimentionnel de l’océan forcé par des vents et des flux thermodynamiques moyens, appelés encore «climatologiques» pour indiquer qu’ils résultaient de la moyenne des champs de vent et des flux thermodynamiques observés au cours d’une période (en général 30 ans) définissant le climat.

Ces «forçages» atmosphériques n’étaient pas encore réalistes car ils ne prenaient pas en compte la réalité des vents et des flux observés à l’interface ; mais malgré cela, la qualité de la simulation reproduisant les grands traits de la circulation océanique était telle que le schéma informatique du modèle devint une référence.

À partir de ce moment il fut largement disséminé et universellement utilisé sous l’appellation de «Bryan-Cox code» par de nombreux groupes de recherche appartenant à des instituts impliqués dans la modélisation de l’océan et du climat.

Plus tard, Bryan travailla évidement avec Manabe et ils réussirent, en 1969, à coupler un modèle de circulation générale atmosphérique (GCM) avec le modèle d’océan Bryan-Cox simplifié sans représentation de la géographie des bassins océaniques. Ce fut une grande première, il fallut plus de 1 000 heures de calcul pour stabiliser le modèle et obtenir une simulation couvrant un siècle ce qui constituait la première modélisation «prognostique», c’est-à-dire permettant une prévision, du climat. Cependant le modèle représentait encore imparfaitement la réalité car la circulation au fond de l’océan n’était toujours pas stabilisée et l’équilibre climatique atteint encore mal défini.

Malgré ces imperfections cette étape de la modélisation fut considérée comme un succès retentissant qui marquera l’histoire car, pour la première fois, il était démontré qu’il était possible de simuler un équilibre climatique en couplant des modèles d’atmosphère et d’océan.

C’est en 1975 que Manabe et Bryan réalisent une simulation couplée océan-atmosphère prenant en compte cette fois la géographie des océans, certes encore grossièrement représentée. Le supercalculateur du GFDL de l’époque, toujours parmi les plus puissants et les plus rapides au monde, «moulina» sans arrêts pendant 50 jours pour simuler trois siècles d’interactions entre l’atmosphère et l’océan sans pour autant atteindre un équilibre climatique satisfaisant, la circulation océanique restant encore partiellement irréaliste. Ces semi-échecs étaient imputés à la partie océanique du modèle et à la difficulté de représenter le milieu océanique avec ses différentes échelles de variabilité que l’on commençait seulement à découvrir.

Une autre difficulté majeure de la représentation du milieu océanique venait de sa très faible couverture en observations de qualité atteignant le fond, similaires et symétriques des observations météorologiques, beaucoup plus nombreuses, grâce aux radiosondages d’altitude.

Ces modèles couplés océan-atmosphère, aussi imparfaits fussent-ils, ouvraient cependant une voie nouvelle et bientôt incontournable pour la recherche climatique en offrant des outils qui suppléaient l’impossibilité de réaliser des expériences dans le domaine géophysique comme on peut le faire dans un laboratoire.

Plusieurs équipes, laboratoires, instituts de recherche se lancèrent dans la modélisation climatique non seulement aux Etats Unis mais dans le monde entier. Beaucoup importèrent les modèles du GFDL ou en dérivèrent des clones, plus ou moins indépendamment. C’est ce que firent les météorologues du MIT, notamment Edward Lorenz proche de Jule Charney. Celui-ci, après ses travaux pionniers autour de l’ENIAC avec Smagorinsky et Von Neumann, était retourné au département de météorologie du MIT. Lorenz cherchait à résoudre numériquement, dans une perspective climatique, les équations représentatives de la dynamique de l’atmosphère mises au point justement par Charney. C’est alors qu’en 1961 un hasard heureux le conduisit à un résultat inattendu qui fit du bruit ; comme il s’en produit quelquefois en science, c’était une découverte surprenante qui s’est imposée d’elle même et est devenue d’autant plus révolutionnaire qu’elle était peu prévisible à cette époque et qu’elle n’était pas apparemment contenue dans des résultats antérieurs.

1-3 La découverte du chaos amène une question inquiétante : Le climat est-il instable ?

On était en 1961 au MIT et Lorenz tentait de résoudre numériquement un système d’équations assez simple pour simuler un équilibre climatique exigeant cependant un long temps de calcul sur l’ordinateur dont il disposait. La petite histoire raconte qu’un jour il décida d’arrêter le calcul de l’ordinateur le temps d’aller prendre un café et nota son résultat transitoire sur un bout de papier pour le reprendre quelques minutes plus tard à partir de ces chiffres. Mais il négligea la cinquième décimale pensant que cette précision était inutile pour arriver au résultat. Le café terminé, relançant sa machine à partir de ces chiffres tronqués il pensait retrouver les caractéristiques de l’état climatique qu’il avait déjà obtenu antérieurement et qu’il étudiait. Son étonnement fut proche de la stupéfaction lorsqu’il constata que le modèle ne convergeait plus vers l’équilibre antérieur mais vers un autre état climatique totalement différent. Répétant cette expérience plusieurs fois il dut admettre que son système d’équations conduisait non pas à une solution unique mais à plusieurs solutions correspondant à autant d’équilibres climatiques possibles. Il constata également qu’il était impossible de prédire à l’avance vers quel état la simulation allait converger quelle que soit la précision des chiffres de départ, appelés les «conditions initiales».

On était en 1961 au MIT et Lorenz tentait de résoudre numériquement un système d’équations assez simple pour simuler un équilibre climatique exigeant cependant un long temps de calcul sur l’ordinateur dont il disposait. La petite histoire raconte qu’un jour il décida d’arrêter le calcul de l’ordinateur le temps d’aller prendre un café et nota son résultat transitoire sur un bout de papier pour le reprendre quelques minutes plus tard à partir de ces chiffres. Mais il négligea la cinquième décimale pensant que cette précision était inutile pour arriver au résultat. Le café terminé, relançant sa machine à partir de ces chiffres tronqués il pensait retrouver les caractéristiques de l’état climatique qu’il avait déjà obtenu antérieurement et qu’il étudiait. Son étonnement fut proche de la stupéfaction lorsqu’il constata que le modèle ne convergeait plus vers l’équilibre antérieur mais vers un autre état climatique totalement différent. Répétant cette expérience plusieurs fois il dut admettre que son système d’équations conduisait non pas à une solution unique mais à plusieurs solutions correspondant à autant d’équilibres climatiques possibles. Il constata également qu’il était impossible de prédire à l’avance vers quel état la simulation allait converger quelle que soit la précision des chiffres de départ, appelés les «conditions initiales».

Lorenz venait de découvrir le chaos en physique et l’impossibilité dans certaines circonstances de déterminer vers quel équilibre, appelé «attracteur», un système physique interactif non linéaire allait converger à partir de «conditions initiales» connues même avec une grande précision. On peut dire redécouvrir car un mathématicien français Henry Poincaré avait déjà suggéré que des systèmes d’équation même très simples pouvaient donner lieu à plusieurs solutions sans qu’il soit possible de déterminer à l’avance vers quelle solution le calcul conduirait. Mais Poincaré n’avait pas d’ordinateur pour vérifier ce qu’il avançait

Pour rendre compte de ce phénomène, Lorenz employa une image restée célèbre dans les media :

«Le battement d’aile d’un papillon au dessus de la forêt brésilienne peut-il déclencher une tornade au Texas ?»

C’est ce qui fut appelé «l’effet papillon» et resta attaché à son nom.

Mais cette découverte soulevait une question fondamentale pour le climat. Celui-ci, bien qu’étant par définition une moyenne de situations météorologiques sur une période assez longue et donc de ce fait à l’abri des fluctuations erratiques du temps, était-il cependant également chaotique ? La question fut longtemps débattue comme en 1985 au cours d’une conférence restée célèbre au NCAR à Boulder au Colorado intitulée : «Cause of climate changes», au cours de laquelle Lorenz conclut sa présentation par une phrase inquiétante :

« …il n’est pas possible d’affirmer que le climat est, ou n’est pas, déterministe et l’on ne saura jamais répondre à cette question ».

Cette affirmation empreinte de pessimisme jeta un grand trouble parmi les participants, météorologues et climatologues, qui durent admettre que, contrairement aux idées antérieures qui conduisaient à imaginer les changements climatiques comme des processus graduels et d’évolution très lente, le climat pouvait être fondamentalement instable et basculer très rapidement d’un état à un autre. Des géologues, comme Broeker, Ewing et d’autres, en avaient eu l’intuition ; ils rappelèrent alors qu’il y a 11 000 ans un basculement climatique brutal engendrant un refroidissement de 5 à 10° C s’était manifesté en moins d’un siècle, le fameux «Younger Drias».

1-4 Une variété de modèles pour comprendre

Mais à coté de ces «grands modèles» qualifiés quelquefois de «modèles aux équations primitives», prenant en compte toute la physique et donc les équations complètes des phénomènes simulés, utilisés principalement pour reproduire la réalité et prévoir son évolution et pour cela appelés quelquefois «modèles prognostiques», des modèles plus simples furent conçus par différents groupes de recherche qui visaient seulement la compréhension de phénomènes particuliers ; ils étaient alors souvent appelés «modèles diagnostiques».

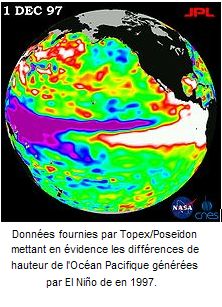

Ce fut le cas, par exemple, pour l’étude du phénomène El Niňo, et d’une façon générale pour comprendre la réponse saisonnière et interannuelle des océans équatoriaux soumis à l’action mécanique des vents alizés, qui posait problème. La structure en deux couches de ces océans intertropicaux - une couche superficielle homogène et chaude surmontant des eaux froides séparées par une transition thermique rapide appelée la thermocline - a encouragé certains théoriciens à concevoir des modèles très simples à deux couches pour simuler les perturbations de la profondeur de cette thermocline et comprendre les mécanismes expliquant les mouvements horizontaux de la couche superficielle chaude, entrainant des transports de chaleur caractéristiques d’El Niňo.

Ces transports affectaient les bassins équatoriaux dans le sens zonal. Dans le Pacifique ils s’étendaient d’un bord à l’autre de ce vaste océan sur près de 20 000 kilomètres de distance et s’accompagnaient de perturbations climatiques générées par des phénomènes d’interactions intenses entre l’océan et l’atmosphère embrassant toute la région.

Le premier de ces modèles à deux couches, qui nécessitait seulement des ressources informatiques très limitées, fut conçu en 1974 par des jeunes chercheurs américains, Jay Mac Creary, Tonny Busalachi, autour de James O’Brien. Un tel modèle simple permit de comprendre que des coups de vent brutaux affectant les alizés, pouvaient générer des ondes océaniques piégées à l’équateur, appelées «ondes de Kelvin», qui perturbaient la thermocline, cette transition rapide entre les eaux chaudes superficielles et les eaux froides sous-jacentes.

Ce mécanisme pouvait expliquer le déferlement d’eaux chaudes jusqu’au bord est de l’océan Pacifique, caractéristique du phénomène El Niňo. En France de tels modèles furent aussi développés sur l’Atlantique intertropical notamment par Pascale Delecluse et Sabine Arnault dans le cadre des programmes : FOCAL et SEQUAL soutenus par une coopération franco-américaine. Par la suite des modèles plus complexes furent aussi développés par Mark Cane et Stephan Zebiak, couplant de façon simplifiée l’océan et l’atmosphère, mais prenant en compte la température. Ils permirent, avec un succès mitigé, une prévision partielle des phénomènes El Niňo et de son opposé froid La Niňa. Mais cette prévision ne dépassait pas les quelques mois qui précèdent le développement d’une de ces phases, El Niňo ou La Niňa, lorsqu’elle est amorcée, suggérant ainsi la nature peut être chaotique du phénomène et les limitations théoriques de sa simulation et de sa prévision.

En 1971, le GFDL s’était renforcé par le recrutement d’un océanographe tropicaliste, George Philander. Encouragé par le succès des modèles linéaires simples à deux couches dans les tropiques, Philander utilisa les modèles océaniques complets du GFDL notamment les versions Bryan-Cox, encore appelés OGCM pour «Oceanic General Circulation Model», pour apporter des réponses plus précises aux questions posées par les interactions océan-atmosphère aux basses latitudes. Il montra, entre autre, que les ajustements de l’océan intertropical dépendaient de la fréquence du forçage du vent auquel il était soumis et aussi de l’étendue en longitude du bassin océanique.

En 1971, le GFDL s’était renforcé par le recrutement d’un océanographe tropicaliste, George Philander. Encouragé par le succès des modèles linéaires simples à deux couches dans les tropiques, Philander utilisa les modèles océaniques complets du GFDL notamment les versions Bryan-Cox, encore appelés OGCM pour «Oceanic General Circulation Model», pour apporter des réponses plus précises aux questions posées par les interactions océan-atmosphère aux basses latitudes. Il montra, entre autre, que les ajustements de l’océan intertropical dépendaient de la fréquence du forçage du vent auquel il était soumis et aussi de l’étendue en longitude du bassin océanique.

De façon simplifiée, les modèles linéaires avaient montré que lorsqu’un vent varie brutalement et présente ainsi un caractère impulsionnel, il génère des ondes piégées à l’équateur, susceptibles de déclencher des «actions à distance». On a vu plus haut que de telles ondes (appelées ondes de Kelvin) affectent le Pacifique équatorial oriental qui se réchauffe durant un El Niňo. Les modèles montraient que ces ondes avaient pu être générées par un coup de vent trois mois plus tôt à 10 000 kilomètres de là dans le Pacifique occidental. Ces ondes parcourent l’océan à une vitesse constante et le temps nécessaire à leur propagation pour traverser un océan dépend évidement de sa taille en longitude. Le «petit» océan Atlantique sera traversé en un mois, le «grand» océan Pacifique en trois mois. Philander montra que ce scénario n’expliquait pas tout et que lorsque le vent varie graduellement, l’océan s’ajuste également graduellement à son action et il n’y a pas génération d’ondes. Il s’ensuivit une querelle scientifique entre les tenants du «tout ondulatoire» pour expliquer la dynamique équatoriale, qualifiés de «naïfs» par des «sceptiques» qui prônaient l’étude de la réponse global de l’océan équatorial au forçage global, local et à distance, du vent. C’est ce qui motiva les programmes FOCAL et SEQUAL.

Par la suite, Philander utilisa le modèle océanique du GFDL pour de multiples expériences qui l’amenèrent à comprendre de nombreux aspects de la dynamique océanique des basses latitudes et de ses interactions avec l’atmosphère. En fait il utilisa en «mode diagnostique», c'est-à-dire pour comprendre des mécanismes et faire des expériences, un «modèle prognostique» sophistiqué et réaliste, susceptible de bien représenter «la réalité» de l’océan pour pouvoir en faire une prévision, ce que les ordinateurs très puissants et les moyens en programmation incomparables du GFDL lui permettaient. Le modèle multicouches du GFDL fut relayé par ceux des britanniques du Hadley Center, des allemands du Max Plank Institut de Hambourg, et des français du LODYC à l’université Paris VI. C’est ainsi que la dynamique des océans équatoriaux et leur relation avec le climat firent des progrès considérables au cours de cette décennie des années 1980.

La modélisation et les simulations de la dynamique des enveloppes fluides, atmosphère et océans, à partir des avancées technologiques majeures que constituaient les calculateurs électroniques, venaient de bouleverser les fondements même de la connaissance du climat que les scientifiques des années 1960 avaient pu construire à travers les seules observations dont ils disposaient à cette époque et en avançant, encore prudemment, quelques théories, comme la théorie astronomique, pour expliquer certaines variations climatiques.

Les modèles allaient envahir toutes les sciences de la Terre, contribuant à agréger les pièces du puzzle climatique. Les deux sphères fluides furent rassemblées dans des modèles couplés océan-atmosphère, auxquels s’accrochèrent bientôt la chimie et le milieu vivant dans des modèles qui devinrent bientôt bio-géo-physico-chimiques dont on reparlera plus loin.

2 - Les observations spatiales

Après la deuxième guerre mondiale, la guerre froide qu’elle engendra fut le moteur de la conquête spatiale qui prit son essor dans le cadre scientifique de l’Année Géophysique Internationale en 1957-58. On a déjà mentionné les motivations géostratégiques de ce premier grand programme scientifique international dédié à l’étude de la Terre qui marqua, à partir de la fin des années 1950, les débuts d’une compétition acharnée dans le domaine spatial entre l’URSS et les États Unis qui bénéficia à la science. Et peut-être, prétendent certains, évita le déclenchement d’une nouvelle «guerre chaude».

En octobre 1957 les premiers Bip-Bip de «Spoutnik-1» se firent entendre de la Terre entière, suivis quelques mois plus tard, en janvier 1958, par le premier satellite américain «Explorer».

Après bien des péripéties, heureuses et malheureuses - on compta plusieurs dizaines de morts parmi les astronautes et les ingénieurs des deux camps - tendant à démontrer la capacité de l’homme à s’extraire de sa condition terrienne, on pensa à regarder la Terre «d’en haut».

À partir des années 1970, pour s’ouvrir plus largement les voies de la conquête de l’espace, les agences spatiales et les instituts de recherche scientifiques s’associèrent pour s’intéresser enfin à la Terre elle-même, motivation première de l’Année Géophysique Internationale qui revenait à l’ordre du jour 15 ans plus tard et marquait les vrais débuts de l’aventure scientifique de l’observation spatiale.

2-1 Les débuts de l’observation spatiale de la Terre : la radiométrie

En fait, très vite, dès 1958 et la fin de l’Année Géophysique Internationale, une organisation internationale, le COSPAR «Committee on Space Research», avait été créé par l’ICSU, avec pour objectif principal de promouvoir et de coordonner la recherche internationale sur l’espace et à partir de l’espace. Cette construction hâtive d’une instance internationale dédiée à l’usage scientifique de l’exploration spatiale traduisait bien les espoirs que la communauté scientifique internationale portait à cette nouvelle façon d’observer le Terre «d’en haut» avant même que des projets avec des instruments d’observations concrets aient déjà matérialisé ce rêve.

Le premier satellite d’observation de la Terre, «TIROS 1», arriva deux années après l’Année Géophysique Internationale ; il fut lancé par les États Unis en avril 1960.

Le premier satellite d’observation de la Terre, «TIROS 1», arriva deux années après l’Année Géophysique Internationale ; il fut lancé par les États Unis en avril 1960.

Doté d’une caméra de télévision en noir et blanc, il envoyait sur Terre des images de la couverture nuageuse pour aider les météorologues à suivre l’évolution des systèmes nuageux, facilitant ainsi la prévision météorologique.

La série des «Tiros» fut progressivement améliorée dans les années 1960 par l’ajout de radiomètres dans le domaine de fréquences du rayonnement infrarouge de la Terre permettant ainsi une première estimation de la température au niveau du sol, notamment de la température de surface des océans.

Après les «Tiros», à partir des années 1970, une nouvelle génération de satellites d’observation de la Terre fut lancée, les «Landsat», visant à cartographier avec précision la surface terrestre, en particulier les zones peu accessibles et très mal connues comme les régions polaires. Puis vinrent aux USA, les satellites spécifiquement météorologiques à partir de 1970 : la série des «NOAA» devenus par la suite «POES – Polar Operational Environmental Satellite» ; et à partir de 1975 celle des «GOES - Geostationary Operational Environmental Satellite» ; le premier de la série des «METEOSAT» européens fut lancé par l’ESA (Agence Spatiale Européenne ) en 1977. Au-delà de leur intérêt pour la prévision météorologique et la cartographie, ces premiers satellites, armés de radiomètres braqués sur la Terre, apportèrent un premier paramètre ayant un lien direct avec le climat, il s’agit de l’extension de la couverture de glace. En effet l’albedo de la glace, réfléchissant 90% de l’énergie solaire incidente, permet de la distinguer facilement des sols nus et de l’océan liquide où, au contraire, 70% de cette énergie est absorbée.

Plus tard, à partir de 1984, ces radiomètres furent utilisés, dans le cadre d’un programme appelé «Earth Radiation Budget Experiment – ERBE », pour mesurer avec précision le flux radiatif solaire incident arrivant au sommet de l’atmosphère. Cette cartographie du flux radiatif solaire fut essentielle pour établir le bilan radiatif de la Terre et son suivi dans les différents compartiments du système climatique particulièrement ses deux enveloppes fluides, l’atmosphère et l’océan.

Plus tard, à partir de 1984, ces radiomètres furent utilisés, dans le cadre d’un programme appelé «Earth Radiation Budget Experiment – ERBE », pour mesurer avec précision le flux radiatif solaire incident arrivant au sommet de l’atmosphère. Cette cartographie du flux radiatif solaire fut essentielle pour établir le bilan radiatif de la Terre et son suivi dans les différents compartiments du système climatique particulièrement ses deux enveloppes fluides, l’atmosphère et l’océan.

Parallèlement à cette exploration du bilan radiatif de la Terre à sa surface et au sommet de son atmosphère, les géodésiens s’intéressaient aussi à la sphère terrestre. «Savoir où l’on est» restait leur principale préoccupation. Les marins étaient évidemment les premiers à partager ce souci, las depuis des siècles de s’en remettre à la position du Soleil et des étoiles ce qui les contraignait à des observations parfois acrobatiques et à des calculs fastidieux sur les passerelles instables de leurs navires.

La marine américaine développa un premier système de positionnement appelé «transit» qu’elle déclassifia au début des années 1970 pour le rendre accessible à l’ensemble des navigateurs civils. Ce système fut remplacé par le fameux GPS «Global Positioning System», toujours sous la responsabilité des militaires américains et au début à leur usage exclusif ; puis il fut progressivement et partiellement déclassifiés au fil du temps. Plus tard, dans les années 2000, les Européens décidèrent de mettre sur pied leur propre système de positionnement, appelé Galileo, toujours en cours de réalisation en 2012. On en reparlera.

2-2 Un tournant dans l’observation de la Terre : la conférence de Williamstown en 1969

Ces débuts prometteurs de l’observation de la Terre depuis l’espace conduisirent la communauté scientifique et les agences spatiales des pays impliqués, principalement les Etats-Unis, l’URSS, la France, l’Europe et le Japon, à réfléchir ensemble sur l’usage scientifique qui pouvait être fait des techniques d’observation de la Terre depuis l’espace.

Une conférence, à l’initiative de la NASA, se tint sur ce sujet à Williamstown dans le Massachussetts en août 1969. Quatre français y participèrent dont François Barlier. C’était peu de temps après que les États-Unis aient reprit le leadership de la conquête spatiale avec les premiers pas de Neil Armstrong sur la Lune.

Cette conférence marqua un tournant important pour les agences spatiales en direction d’une utilisation de l’espace pour mieux connaitre la Terre et les océans. Dorénavant, parallèlement à la conquête et à l’étude des objets extraterrestres : Lune, planètes, système solaire… qui se poursuivra dans un esprit de féroce compétition Est-Ouest auprès de l’opinion publique mondiale, une part importante des ressources sera allouée à l’observation de la Terre ; mission probablement moins prestigieuse auprès du public mais peut-être plus directement utile à l’humanité actuelle.

Le titre du rapport de conclusion de la conférence est significatif à cet égard : «The terrestrial environnement : solid earth and oceans physics application of space and astronomical techniques». Ce document dresse un panorama complet des usages scientifiques possibles de l’observation spatiale, et il contient en germe les prochaines missions d’observation de la Terre et des océans qui devaient être orientées vers :

«L’étude des contributions possibles de mesures précises de position, de vitesse et d’accélération depuis l’espace à la solution de problèmes de géophysique et d’océanographie».

Cette formulation annonce l’utilisation des radars actifs embarqués, les altimètres, qui inaugureront une nouvelle ère de l’observation de l’océan pour répondre à la grande question qui s’est de plus en plus imposée à partir des années 1970 :

Quel est le rôle de l’océan dans le climat, sa variabilité et son changement à long terme ?

2-3 L’altimétrie, une révolution dans l’observation de l’océan

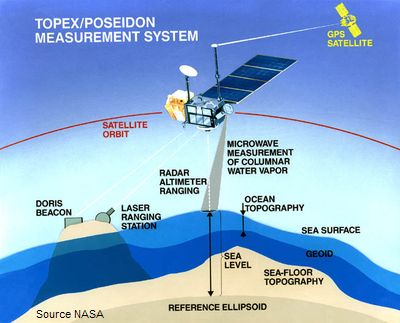

Un programme spatial expérimental, appelé SEASAT, dédié à l’observation de l’océan fut lancé par la NASA en 1978. Il eut une vie courte : 3 mois seulement, mais il démontra l’étendue des possibilités qu’offrait la technologie spatiale à l’observation d’un milieu aussi difficile d’accès que l’océan. Au-delà des mesures des propriétés usuelles de sa surface, telles que sa température ou sa couleur, à l’aide de radiomètres passifs calés sur plusieurs fréquences de la partie visible et infrarouge du spectre électromagnétique émis, SEASAT emmenait aussi des instruments, dits actifs, qui sont des radars émetteurs et récepteurs dans le domaine des mictro-ondes.

On en distingue deux catégories : les «diffusiomètres» et les «altimètres».

-

Les diffusiomètres permettent d’estimer la vitesse et la direction du vent en captant l’intensité du signal rétrodiffusé qui dépend de l’amplitude des micro-ondulations générées par le vent à la surface de l’océan.

-

Les altimètres, pointés à la verticale du satellite, mesurent la distance entre celui-ci et la surface de l’océan.

L’altimètre de SEASAT, encore peu précis dans l’absolu (quelques dizaines de centimètres) démontra cependant le potentiel d’une mesure précise de l’altitude de la surface de l’océan permettant d’accéder, au-delà de sa surface, à une information intégrant l’état de ses couches profondes. Les observations altimétriques de SEASAT, aussi rudimentaires fussent-elles, démontrèrent l’extraordinaire potentiel de cet instrument et l’étendue de ses applications possibles à de nombreux paramètres océaniques en relation avec le climat tels que son niveau moyen, dont on peut mesurer l’élévation de quelques millimètres par an, et sa dynamique à toutes profondeurs (champ de courants). SEASAT fut le banc d’essais des programmes altimétriques qui suivirent et dont le plus emblématique est le programme franco-américain TOPEX/POSEÏDON.

Ce satellite TOPEX/POSEÏDON résultat d’une coopération réussie entre les USA et la France a été lancé en 1992. Cette coopération fut exemplaire tant par ses performances techniques et scientifiques que par les liens qu’elle contribua à tisser entre deux agences spatiales, la NASA et le CNES, et deux communautés scientifiques, américaine et européenne à dominante française. Mais les projets initiaux, TOPEX pour les États-Unis et POSEÏDON pour la France, avant de converger, eurent une vie propre et connurent des difficultés pour exister individuellement dans chacun de leur pays. C’est ce qui les conduisit à s’associer pour se légitimer et se renforcer mutuellement auprès de leurs bailleurs financiers respectifs et aussi, évidement, pour partager et réduire les coûts. Ces difficultés, finalement surmontées, sont caractéristiques des étapes de la mise sur pied de grands projets multinationaux impliquant des communautés scientifiques et des agences nationales de haut niveau comme le sont le CNES en France et la NASA aux USA. C’est pourquoi, eu égard à l’énorme impact que ces projets eurent sur la communauté scientifique mondiale engagée dans l’étude du climat, il peut être intéressant d’évoquer plus en détail les péripéties de cette coopération et ses résultats.

Ce satellite TOPEX/POSEÏDON résultat d’une coopération réussie entre les USA et la France a été lancé en 1992. Cette coopération fut exemplaire tant par ses performances techniques et scientifiques que par les liens qu’elle contribua à tisser entre deux agences spatiales, la NASA et le CNES, et deux communautés scientifiques, américaine et européenne à dominante française. Mais les projets initiaux, TOPEX pour les États-Unis et POSEÏDON pour la France, avant de converger, eurent une vie propre et connurent des difficultés pour exister individuellement dans chacun de leur pays. C’est ce qui les conduisit à s’associer pour se légitimer et se renforcer mutuellement auprès de leurs bailleurs financiers respectifs et aussi, évidement, pour partager et réduire les coûts. Ces difficultés, finalement surmontées, sont caractéristiques des étapes de la mise sur pied de grands projets multinationaux impliquant des communautés scientifiques et des agences nationales de haut niveau comme le sont le CNES en France et la NASA aux USA. C’est pourquoi, eu égard à l’énorme impact que ces projets eurent sur la communauté scientifique mondiale engagée dans l’étude du climat, il peut être intéressant d’évoquer plus en détail les péripéties de cette coopération et ses résultats.

La mission POSEÏDON a été proposée au CNES pour la première fois en 1981 lors d’un de ses colloques de prospective, par deux de ses ingénieurs dont «le marin» Michel Lefebvre alors directeur d’un groupement mixte d’une dizaine de laboratoires : Le «Groupement de Recherche en Géodésie Spatiale – GRGS. Elle fut sélectionnée comme prioritaire, mais, premier avatar, le projet spatial européen concurrent : ERS 1 ruina presque complètement la justification d’un projet altimétrique auprès du gouvernement français de l’époque.

Du côté américain, TOPEX fut également proposé à la NASA par des scientifiques, en 1981 à la suite de l’échec d’un projet appelé NOSS, dont l’US Navy ne voulait pas. Mais la NASA resta longtemps silencieuse sur ce projet TOPEX dont le sigle même irritait par sa similitude avec un produit publicitaire vanté sur les écrans de TV américains !

Pour le versant positif on s’en remettait à l’opiniâtreté de quelques océanographes, peu nombreux, qui des deux côtés de l’Atlantique se penchèrent sur les données altimétriques de SEASAT et de GEOSAT, un satellite de la Navy destiné à cartographier le géoïde. Ces océanographes furent rapidement convaincus de l’énorme potentiel de cette nouvelle façon d’observer l’océan depuis l’espace. Ils étaient représentés par de brillantes personnalités scientifiques qui, avec Michel Lefebvre, étaient en situation de soutenir les deux projets des deux cotés de l’Atlantique car ils étaient les mieux placés pour démontrer, aux niveaux de décision des gouvernements, l’intérêt de s’engager dans les investissements nécessaires au développement de cette nouvelle technologie d’observation de la Terre et des mers. Il s’agissait de Carl Wunsch, professeur au MIT, une des personnalités les plus en vue de l’océanographie américaine et, du coté français, de Jean-François Minster, océanographe géochimiste, ancien directeur du Legos à Toulouse et par la suite président directeur général de l’Ifremer

En France le projet était particulièrement sensible car il touchait à des intérêts stratégiques et technologiques, notamment en ce qui concerne les forces navales, et coûtait très cher, près de deux milliards de francs !

Rapidement, un projet commun avec les États-Unis fut envisagé : des entretiens informels entre scientifiques se tinrent dès 1983 et conduisirent à un premier contact, cette même année, entre les responsables du CNES et de la NASA. La perspective d’un projet commun fut rapidement envisagée pour réduire la facture à présenter aux gouvernements des deux pays. Le but devint de lancer la plateforme satellitaire américaine, équipée de son altimètre associé à l’altimètre français, avec une fusée Ariane et d’améliorer le positionnement du satellite, qui doit être très précis, à l’aide d’un nouveau système de positionnement développé en France par le CNES et l’IGN et appelé DORIS. Ce projet commun fut cependant difficile à faire aboutir, et les premières réunions entre Français et Américains en 1983 furent délicates. Le système de positionnement DORIS proposé par les Français n’existait pas encore concrètement et était seulement à l’état de projet dans les cartons du CNES. De ce fait il était difficilement crédible pour les Américains, d’autant qu’ils disposaient eux-mêmes d’un système de positionnement, TRANSIT, qui avait fait ses preuves. En dépit de ces difficultés, un accord de coopération entre le CNES et la NASA fut conclu sous la pression des scientifiques. Mais cela ne signifiait pas pour autant un engagement contractuel définitif. Le projet d’accord devait passer devant les gouvernements des deux pays pour être ratifié et financé.

Rien n’était encore définitivement gagné. Du coté français des événements nouveaux survinrent qui jouèrent dans des sens opposés, défavorables et favorables. Le projet de satellite européen, ERS 1, toujours en vie, se voyait renforcé sous l’impulsion de certains océanographes allemands et britanniques qui proposaient qu’il embarque un altimètre compact et un système de positionnement précis tel que DORIS. Ces équipements nouveaux sur ERS 1 affaiblissaient le projet franco-américain qui pouvait, en première analyse, apparaître comme un «doublon» de ERS 1. Il fallut convaincre le gouvernement français que si ERS1 pouvait satisfaire des objectifs pré-opérationnels et commerciaux européens, la faible précision de son altimètre ne pouvait satisfaire les intérêts de la recherche française, associée, mais aussi en compétition, avec la recherche américaine.

Le second événement, favorable celui-là aux défenseurs de Topex-Poséïdon, vint de l’intérêt que le ministère de la Défense porta au projet, poussé par la Marine Nationale qui était convaincue que des observations altimétriques précises pouvaient aider à la détection des sous-marins. En 1986, le ministère de la Défense décida donc de contribuer au financement du projet, ce qui suffit à convaincre le Premier ministre de l’époque de donner son accord au projet franco-américain. De leur coté, les Américains, bien que confrontés eux-mêmes à des difficultés importantes à la suite de l’explosion tragique de la navette Challenger en 1986, acceptèrent le projet commun. Ainsi, finalement, cette coopération franco-américaine autour de ce projet fut scellée par un accord entre les gouvernements d’une part et les agences spatiales de l’autre, qui fut signé le 23 mars 1987.

2-4 Les conquêtes de l’observation spatiale de la Terre

Trois catégories de variables sont à prendre en compte dans l’observation de la Terre depuis l’espace :

-

les orbites du satellite,

-

les capteurs embarqués,

-

les paramètres géophysiques visés.

Les lois de la mécanique céleste restreignent les points d’observations possibles de la Terre à partir d’une plateforme satellisée autour d’elle. Des compromis sont à trouver dans l’échantillonnage spatio-temporel de la surface terrestre.

Deux choix sont possibles :

-

Des orbites dites «géostationnaires», ou en point fixe, qui doivent être circulaires dans un plan équatorial et qui sont contraintes d’être à une altitude haute de 36 000 kilomètres. Elles permettent une observation permanente d’une zone cependant réduite à un cône de vision embrassant une seule région de la sphère terrestre et donc un seul satellite ne suffit pas à voir toute la Terre. Les météorologues ont été les premiers utilisateurs de ces satellites géostationnaires.

-

Des orbites dites «à défilement», beaucoup plus basses que l’orbite géostationnaire : de 500 à 1 000 kilomètres d’altitude seulement, et qui tournent autour de la Terre dans des plans proches de la perpendiculaire à l’équateur. Les trajectoires se décalent régulièrement et repassent sur leurs traces après un tour complet de la Terre répétant les observations d’un lieu donné à cadence régulière. Mais généralement les zones couvertes n’atteignent pas les régions proches des pôles. Dans certains cas un réglage particulier conduit à ce que le plan de l’orbite croise une latitude donnée à la même heure du jour. On a alors affaire à une orbite dite «héliosynchrone», très pratique, car elle garantit une variation minimale des conditions d’observation du fait que la position du Soleil reste invariante à chaque passage du satellite en un point donné. Les orbites à défilement sont les plus communes dans l’artillerie spatiale et sont susceptibles de porter des instruments divers pour une grande variété de paramètres géophysiques.

La panoplie des paramètres géophysiques offerts par l’observation spatiale de la Terre s’est accrue presque exponentiellement depuis les premiers radiomètres embarqués sur des plateformes spatiales au début des années 1960 avec la série des TIROS sous le contrôle des militaires américains. Le premier satellite civil, LANDSAT 1, lancé par la NASA en 1972, était équipé d’un radiomètre avec la mission de cartographier des régions encore difficilement accessibles de la planète, ainsi que de suivre la frontière entre les glaces polaires, l’océan et les continents voisins.

Puis l’usage des radiomètres s’étendit à la mesure de la température de surface des océans et des continents dans les fréquences infrarouges caractéristiques du rayonnement propre de la Terre. Ces radiomètres équipaient les premiers satellites météorologiques géostationnaires (voir plus haut), les GOES américains, METEOSAT européens, ainsi que ceux du Japon, de l’Inde, de la Russie et de la Chine.

Ces satellites météorologiques ont été à l’origine de progrès sans précédent dans l’acquisition des données météorologiques usuelles, continues dans l’espace et le temps, telles que la nébulosité et les systèmes nuageux, la température de surface, l’étendue des zones englacées … etc ; cette vision «d’en haut» de l’atmosphère a conduit à des prévisions météorologiques de plus en plus performantes. La radiométrie fut aussi utilisée dans les fréquences de la partie visible du spectre pour estimer la couleur de l’océan qui dépend de son contenu en substances diverses absorbant la lumière : chlorophylle, apports terrigènes,…etc. Le premier instrument «couleur de la mer» (Coastal Zone Color Scanner - CZCS) fut embarqué sur la plateforme NIMBUS 7 de la NASA en 1979.

A coté des radiomètres, capteurs passifs, les instruments les plus utilisés furent les diffusiomètres et les altimètres, radars actifs émetteurs-récepteurs dans la gamme des micro-ondes du spectre électromagnétique.

Les diffusiomètres sont utilisés pour mesurer la vitesse et la direction du vent à la surface des océans en captant le signal rétrodiffusé vers le satellite qui dépend de l’amplitude et de la direction des vagues capillaires générées par le frottement du vent à la surface de la mer.

Le premier diffusiomètre a été embarqué sur le satellite SEASAT en 1978. On a vu que cette plateforme était aussi équipée d’un altimètre, un radar également émetteur-récepteur pointé à la verticale du satellite pour mesurer la distance entre celui-ci et la surface de la mer. L’altimètre de SEASAT n’était pas très précis et il fonctionna seulement pendant 3 mois, il permit cependant de démontrer toute l’étendue des potentialités de cette nouvelle technologie d’observation de l’océan qui justifia ultérieurement le projet franco-américain TOPEX/POSEÏDON présenté précédemment.

L’altitude absolue de la surface de l’océan, lorsqu’elle est connue avec une grande précision (de l’ordre de quelques centimètres) est riche d’information, non seulement sur la surface de l’océan mais aussi sur ses couches profondes. En effet cette «hauteur dynamique» de la surface de la mer, comme elle est appelée, reflète la densité moyenne de toute la colonne liquide en un point donné. Avec un altimètre on a ainsi accès, de la même façon que pour l’atmosphère avec la cartographie des zones de hautes et de basses pressions, à la topographie de la surface de l’océan, faite aussi de bosses et de creux qui traduisent des variations et donc des gradients de pression à l’intérieur du fluide. La connaissance de ces gradients de pression rend possible le calcul des courants à toutes les profondeurs comme le font tous les jours les météorologues pour calculer le vent dans l’atmosphère à partir de la cartographie des champs de pression atmosphérique.

L’altitude absolue de la surface de l’océan, lorsqu’elle est connue avec une grande précision (de l’ordre de quelques centimètres) est riche d’information, non seulement sur la surface de l’océan mais aussi sur ses couches profondes. En effet cette «hauteur dynamique» de la surface de la mer, comme elle est appelée, reflète la densité moyenne de toute la colonne liquide en un point donné. Avec un altimètre on a ainsi accès, de la même façon que pour l’atmosphère avec la cartographie des zones de hautes et de basses pressions, à la topographie de la surface de l’océan, faite aussi de bosses et de creux qui traduisent des variations et donc des gradients de pression à l’intérieur du fluide. La connaissance de ces gradients de pression rend possible le calcul des courants à toutes les profondeurs comme le font tous les jours les météorologues pour calculer le vent dans l’atmosphère à partir de la cartographie des champs de pression atmosphérique.

Mais d’autres paramètres géophysiques furent aussi touchés par les observations spatiales et, sans entrer dans le détail, le catalogue actuel de ces conquêtes est étonnant et couvre tous les milieux qui constituent le système climatique : atmosphère, hydrosphère, cryosphère, lithosphère et biosphère.

Pour l’atmosphère, l’observation spatiale contribue à la détermination sur la verticale de :

-

sa température,

-

sa composition en vapeur d’eau, en ozone, en aérosols,

-

son bilan radiatif,

-

sa teneur en dioxyde de carbone et en méthane.

Pour l’océan les satellites sont utilisés pour déterminer :

-

sa température de surface,

-

sa couleur,

-

son niveau moyen,

-

les marées en plein océan,

-

le vent en surface,

-

l’état de la mer,

-

les précipitations et l’évaporation,

-

la salinité de surface,

-

les courants à toutes profondeurs à condition d’avoir des mesures de référence in situ.

Pour l’hydrosphère continentale, il est possible de mesurer :

-

l’étendue des lacs, rivières et fleuves,

-

leur altitude,

-

leur volume

-

et leur mouvement.

Pour la cryosphère :

-

l’étendue et l’épaisseur des glaces de mer,

-

la topographie de la surface

-

et le volume des glaciers continentaux.

Pour la lithosphère et la biosphère :

-

la concentration de l’océan en phytoplancton,

-

l’humidité des sols,

-

la couverture végétale et forestière ainsi que son état hygrométrique,

-

l’évapotranspiration….

D’autres paramètres, encore, ont aussi bénéficié de l’observation spatiale comme :

-

les variations de la vitesse de rotation de la Terre et donc la durée du jour,

-

le champ de gravité de la Terre

-

ou encore l’origine de l’énergie manquante dans le bilan énergétique de l’océan, attribuée au potentiel de marée dont on avait jusqu’alors sous-estimé le rôle dans les processus de mélanges verticaux au sein de la masse océanique.

Les moyens satellitaires ont aussi permis de résoudre une des grandes difficultés de l’observation des océans : celle de ses couches profondes. Pour sonder l’atmosphère on dispose avec les continents et les îles de bases stables. Rien de tel pour l’océan que l’on ne put longtemps explorer qu’à partir de navires soumis à tous les caprices de l’océan et qui ne pouvaient couvrir que des zones restreintes sur des périodes de temps limitées. Il était impossible dans ces conditions de disposer de réseaux pérennes d’observation des couches profondes.

Les systèmes satellitaires de localisation et de transmission de données comme le système Argos embarqué sur les satellites NOAA ont radicalement changé la situation.

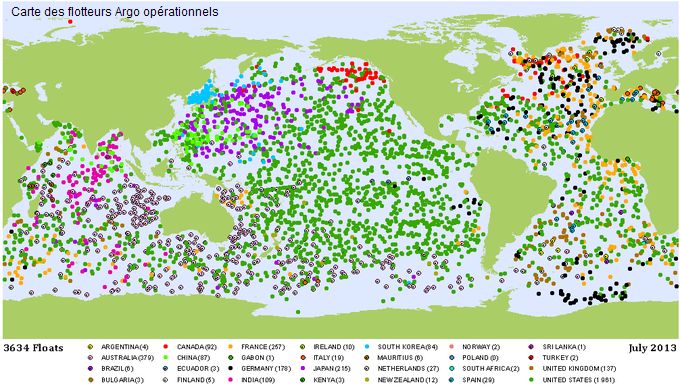

Le programme Argo lancé en 2000 a permis de déployer dans tout l’océan des flotteurs dérivant en profondeur et munis de capteurs. Tous les dix jours ils remontent en surface en mesurant sur la colonne d’eau de 2000 mètres à la surface la température et la salinité. Une fois en surface ils sont localisés et transmettent les données recueillies par satellite. En 2013 il y a plus de 3500 flotteurs Argo (120 000 sondages par an) opérationnels dans tout l’océan qui est maintenant à égalité avec l’atmosphère. En combinant modèles océaniques données satellitaires et mesures in situ on résout l’océan que l’on peut maintenant prédire opérationnellement à échéance de trois semaines.

3- Les modèles et l’observation spatiale resserrent les pièces du puzzle climatique

On perçoit donc le bouleversement considérable que la modélisation numérique et l’observation spatiale ont apporté, à partir des années 1960, aux sciences du climat, principalement pour les deux enveloppes fluides qui entourent la planète, l’atmosphère et l’océan.

Les simulations numériques des ordinateurs ont permis de s’abstraire d’une difficulté majeure inhérente à la géophysique, l’impossibilité de réaliser des expériences dans la réalité comme on le fait en physique dans les laboratoires. La puissance rapidement croissante de ces machines a permis d’atteindre un réalisme suffisamment significatif des phénomènes en jeux pour que ces représentations permettent de faire des expériences virtuelles pour mieux comprendre certains mécanismes.

Par ailleurs, ces modèles numériques, au-delà de l’image de la réalité plus complète qu’ils proposent d’un élément essentiel du système climatique, et que les observations seules ne peuvent donner, ont permis de simuler les interactions complexes de plusieurs milieux par ce que l’on appelle des «modèles couplés» qui associent l’évolution des actions et rétroactions des différents milieux constituant le système climatique. À ce titre ces modèles couplés apparaissent comme des outils intégrateurs indispensables pour pouvoir rendre compte de l’énorme complexité de la dynamique du climat. C’est ce qui fait qu’ils peuvent être vus comme une sorte de «ciment» assemblant plusieurs pièces du puzzle climatique, rapprochant et intégrant les concepts et les données de plusieurs disciplines des sciences de l’environnement. Ainsi on est passé, comme on l’a vu, de modèles purement atmosphériques et océaniques à des modèles couplés océan-atmosphère. Puis plus récemment en y ajoutant progressivement les autres milieux constitutifs du système climatique : la glace, les surfaces continentales, le milieu vivant, à des constructions de plus en plus complexes et à des objets à la dénomination exotique comme des modèles «physico-bio-géo-chimiques» permettant, entre autre, de simuler l’évolution du climat ; enfin le couplage peut s’étendre aussi aux modèles économiques intégrant ainsi la dimension socio-économique, voire politique de la question climatique.

Mais les simulations doivent s’appuyer sur des observations. Longtemps ces observations in situ on été la principale, sinon la seule approche de la réalité géophysique et ont piloté l’évolution des sciences de l’environnement. Mais elles étaient très insuffisantes, difficiles à réaliser, couteuses et inégalement réparties dans l’espace et le temps laissant des régions entières vides de données, notamment dans les immensités océaniques que l’Année Géophysique Internationale n’avait pu combler.

Les nouvelles technologies d’observation de la Terre à partir de plateformes satellitaires opérèrent une véritable révolution dans la vision que l’on pouvait avoir de ces milieux et de leur rôle dans le climat. Ces nouvelles approches de l’observation de notre planète devinrent une nouvelle pièce du puzzle climatique. Cette pièce ajoutée « venue de l’espace », est d’autant plus déterminante qu’elle croise presque toutes les disciplines scientifiques impliquées antérieurement dans le climat et agrège entre elles ces disciplines comme le font les modèles. Les observations spatiales, assimilées dans les modèles, contribuent donc aussi au «ciment» qui «colle» entre elles les pièces du puzzle climatique permettant une «prévision opérationnelle» de son évolution dans ce qui sera appelé les «modèles climatiques».