Novembre 2016

1/1 En hommage à Michel Gauthier

Le 10 juin dernier, nous avons appris avec émotion que Michel nous avait quittés.

Le 10 juin dernier, nous avons appris avec émotion que Michel nous avait quittés.

Il a été l'un des pionniers du Club des Argonautes qu'il a rejoint dès sa deuxième séance, en mai 2003.

Ses connaissances de l'Énergie Thermique des Mers pour la production d'électricité (ETM, en anglais OTEC) et de l'utilisation de l'eau de mer profonde pour la climatisation (en anglais SWAC), sa conviction que c'était une voie d'avenir, ont joué un rôle important dans les orientations du Club.

En effet, au cours de sa carrière à l'Ifremer, Michel (deuxième à gauche sur cette photo d'octobre 2011), a travaillé sur ces sujets. Après une étude de faisabilité particulièrement réussie, il a dirigé l'avant projet de centrale à Tahiti confié à Groupement d’Intérêt Économique. À sa grande déception, en 1987, les pouvoirs publics ont décidé d'abandonner cette filière et le projet n'a jamais vu le jour. Cependant, toujours convaincu de l'intérêt de ces recherches, il est resté très actif dans ce domaine. Dès 1990 et pendant plus de dix ans, il a animé un réseau international de compétences, "International OTEC Association (IOA)" dont il était président. L'objet était de "mettre en place une coordination, une diffusion de l'information ainsi qu'une coopération de toutes les parties intéressées dans la conversion de l'énergie thermique des océans et les applications d'eaux profondes océaniques." L'Europe, l'Amérique, l'Asie étaient représentées.

Arrivé à l'âge de la retraite et devenu membre du Club des Argonautes, Michel a poursuivi avec dynamisme son action au travers de toutes ses relations internationales et nationales, notamment auprès des organismes publics français.

Il s'exprimait ainsi :

L'océan est effectivement le principal récepteur de l'énergie solaire reçue sur Terre. Il en est aussi le plus grand réservoir. Dans la zone inter-tropicale, on peut exploiter les différences de température entre la couche superficielle chaude de l'océan (>25°C) et les couches profondes, (quelques centaines de mètres), où la température est de l'ordre de 5°C.

Pourquoi la France, qui fut pionnière en la matière, et qui possède la plus grande zone économique maritime dans les régions tropicales, laisserait-elle en friche une énergie renouvelable, non intermittente, et dont les retombées: climatisation, production d'eau douce, voire aquaculture, sont loin d'être négligeables ?

En 2007, année d'élection présidentielle, se produisit un événement inattendu. L'institut Français de la Mer a posé une série de questions à chaque candidat à la Présidence de la République. L'une d'elle était :

"Quelles perspectives de développement des activités maritimes de l’Outre-mer français voyez-vous dans les cinq prochaines années ?"

La réponse du candidat Nicolas Sarkozy, futur Président a été :

"La mer tropicale est également une source majeure d'énergies renouvelables, malheureusement inexploitée aujourd'hui. Leur développement passe par une recherche appliquée pertinente sur l'éolien offshore, sur l'hydrolien, et surtout sur l'énergie thermique des mers, actuellement ignorée", reprenant presque mot pour mot titre qui se trouvait sur notre site Web depuis plus d'un an !

Cette déclaration sur l'ETM est à l'origine de la reprise des travaux dans ce domaine en France il y a un peu moins de 10 ans.

La participation de Michel aux travaux du Club a été substantielle : un dossier complet sur l'ETM, souvent cité dans les sites spécialisés sur les énergies marines, des FAQs, de nombreuses News relatant les dernières nouveautés du domaine. Michel a aussi apporté son soutien à de jeunes ingénieurs intéressés par les applications de la ressource Eau Froide Profonde. Plusieurs sont devenus membre correspondants (David Levrat, Matthieu Hoarau, David Wary). Avec Gérard Nihous et Jacques Ruer (désormais membre du Club), le Club dispose ainsi d'experts toujours prêts à répondre à nos questions ou écrire un article.

Michel était souvent présent aux réunions du Club, participait activement à nos discussions, nos orientations. C'était aussi un ami dont le sens de l'humour et la bienveillance nous manquent énormément.

Gaëlle, fille de Michel Gauthier, nous parle de son père.. Propos recueillis par Yves Dandonneau.

La cité de la mer - Michel Gauthier - Illustrations et mise en pages : Yves Dandonneau

Février 2016

1/2 Atlas du climat : Face aux défis du réchauffement.

Livre de François-Marie Bréon et Gilles Luneau, préfacé par Jean Jouzel, cartographie de Hugues Piolet.

Recension de Yves Fouquart.

Un bouquin de plus sur le climat, quelques variantes sans doute mais rien de bien transcendant, c’est à cela que je m’attendais. Des livres sur le climat, ce n’est certes pas ça qui manque. Avec la COP21, on en a vu fleurir une quantité impressionnante. Celui-ci arrive un peu plus tard mais il tranche sur ses prédécesseurs. Entrez donc dans une librairie et feuilletez-le. Ce qui frappe au premier coup d’œil, c’est la présentation : des figures, des cartes et des schémas en pagaille, de la couleur, bref, une présentation superbe. De quoi rendre jaloux quand on a, comme moi, commis un bouquin rendu presque illisible par son éditeur.

Un bouquin de plus sur le climat, quelques variantes sans doute mais rien de bien transcendant, c’est à cela que je m’attendais. Des livres sur le climat, ce n’est certes pas ça qui manque. Avec la COP21, on en a vu fleurir une quantité impressionnante. Celui-ci arrive un peu plus tard mais il tranche sur ses prédécesseurs. Entrez donc dans une librairie et feuilletez-le. Ce qui frappe au premier coup d’œil, c’est la présentation : des figures, des cartes et des schémas en pagaille, de la couleur, bref, une présentation superbe. De quoi rendre jaloux quand on a, comme moi, commis un bouquin rendu presque illisible par son éditeur.

L’ouvrage aborde 37 sujets qui disposent chacun d’une double page comportant généralement trois ou quatre illustrations et un texte assez synthétique. Il est divisé en quatre chapitres qui abordent :

- le fonctionnement du climat,

- les perturbations anthropiques,

- les impacts du réchauffement

- et les pistes d’action.

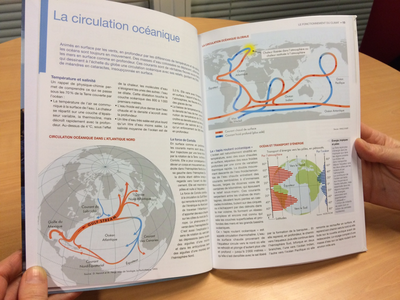

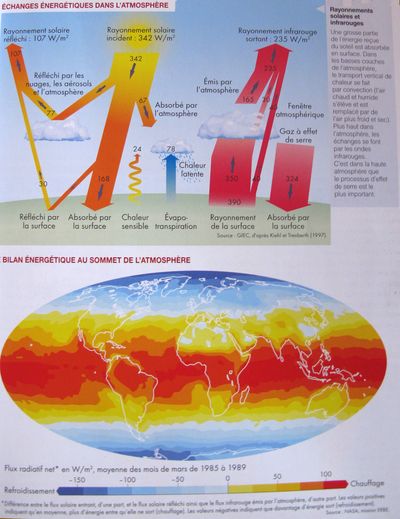

Trente-sept thèmes, c’est finalement assez peu et il a fallu faire des choix. Ce que le livre gagne en présentation, il le perd nécessairement en exhaustivité. Les systèmes d’observation, l’équilibre énergétique, l’alternance des glaciations, la circulation océanique et le cycle du carbone, ce sont les sujets abordés dans le premier chapitre, à cela s’ajoute une présentation des perturbations naturelles aux différentes échelles de temps et l’effet des nuages.

Les systèmes d’observation, l’équilibre énergétique, l’alternance des glaciations, la circulation océanique et le cycle du carbone, ce sont les sujets abordés dans le premier chapitre, à cela s’ajoute une présentation des perturbations naturelles aux différentes échelles de temps et l’effet des nuages.

Le deuxième chapitre aborde la hausse des températures, l’évolution de la glace et de la neige, le niveau des mers, l’effet de serre, les émissions anthropiques de CO2, l’ozone, la déforestation et les aérosols.

Ces deux chapitres ont pour objectif de poser les bases de la problématique. Disons tout de suite que si la présentation est très attrayante, elle ne permet pas de beaucoup approfondir le discours qui reste somme toute assez superficiel et incomplet. Il y a de quoi amener un lecteur curieux à se poser des questions mais il n’y trouvera pas toujours de réponse satisfaisante. Par exemple, deux pages sont consacrées à l’effet de serre mais le processus physique lui-même est expédié en cinq phrases et en moins de 60 mots. C’est assurément très concis. Les questions relatives à la dynamique de l’atmosphère et de l’océan ne sont qu’à peine effleurées au détour de la légende d’une figure. De même, le rôle de la vapeur d’eau et de ses changements de phase n’est pas abordé.

On peut aussi regretter que les illustrations soient trop peu commentées et parfois pas du tout. Ça peut être très perturbant comme dans le cas du cycle du carbone où une des figures est particulièrement mal appropriée puisqu’elle présente sous ce nom, un bilan simplifié qui ne concerne, en fait que les émissions anthropiques alors que le texte se rapporte au cycle du carbone dans son ensemble, c’est à dire en incluant les flux naturels de CO2.

La troisième partie traite de l’influence du réchauffement sur les activités humaines : quels sont les problèmes et quelles sont les perspectives ouvertes par le réchauffement ? On y aborde la question des évènements extrêmes et de leur coût économique et humain, l’ouverture des voies de communication maritime par l’Arctique, les impacts sur la biodiversité marine et terrestre, la pêche, l’agriculture et la santé ainsi que les surcotes et la salinisation liées à la hausse du niveau de la mer. La question des migrations de population et celle du coût du réchauffement terminent ce chapitre.

On y trouve des cartes présentant l’évolution de la chenille processionnaire en France, celle de la productivité agricole dans le monde, l’avancée du moustique tigre en France et la répartition des réfugiés climatiques dans le monde, essentiellement pour causes de tempêtes ou d’inondations.

On y trouve des cartes présentant l’évolution de la chenille processionnaire en France, celle de la productivité agricole dans le monde, l’avancée du moustique tigre en France et la répartition des réfugiés climatiques dans le monde, essentiellement pour causes de tempêtes ou d’inondations.

On sait que nos sociétés sont malades de leur addiction aux énergies fossiles. On commence à en mesurer les dégâts. Une fois le constat établi, que faire ? La désintoxication semble s’imposer mais encore faudrait-il que le remède ne tue pas le malade. C’est, au fond, cette question qui est abordée dans le dernier chapitre qui s’intitule le temps de l’action. En abordant Les scénarios du GIEC, l’historique de la prise de conscience, les difficultés de la coopération à l’échelle planétaire, la question centrale des financements, l’indispensable transition énergétique, les auteurs posent le cadre des pistes d’action pour l’agriculture, les transports et la ville. La piste de la géo-ingénierie n’est pas oubliée mais ce n’est manifestement pas une solution aux yeux des auteurs pour qui cette piste n’est rien d’autre qu’une fuite en avant vers des solutions techniques hypothétiques et dangereuses quand il faudrait un changement radical de paradigme.

Les dernières pages et la conclusion générale prennent une tournure plus engagée mettant en avant les initiatives de la société civile et dénonçant le «manque de volonté politique», les différences d’appréciation Nord/Sud ainsi que les obstacles dressés par les différents lobbys. Le dernier thème intitulé «La révolution des modes de vie est-elle possible ?» oppose deux trajectoires d’évolution possible de la ville : la cité intelligente où tout est centralisé et «mis en équation» dans une démarche «top-down» et l’éco ville qui correspond à la démarche inverse. Les auteurs rappellent fort utilement que ces trajectoires seront soumises à des contraintes imposées par le jeu des acteurs financiers et des acteurs sociaux.

En résumé, un ouvrage qui vaut surtout par sa forme mais qui s’efforce d’aborder tous les aspects de la problématique du changement climatique de la description des mécanismes fondamentaux du système climatique aux impacts prévisibles du réchauffement et aux pistes d’action sans oublier les problèmes sociétaux qui en découlent. C’est fait d’une façon très attrayante mais nécessairement schématique et peu approfondie.

En résumé, un ouvrage qui vaut surtout par sa forme mais qui s’efforce d’aborder tous les aspects de la problématique du changement climatique de la description des mécanismes fondamentaux du système climatique aux impacts prévisibles du réchauffement et aux pistes d’action sans oublier les problèmes sociétaux qui en découlent. C’est fait d’une façon très attrayante mais nécessairement schématique et peu approfondie.

Le lecteur bien au fait de la littérature du climat y retrouvera de nombreux schémas et courbes avec lesquels il est très familier comme par exemple la représentation des échanges énergétiques dans l’atmosphère, le tapis roulant océanique ou l’évolution de la température et du CO2 depuis 400 000 ans, la part des différentes sources d’énergie dans la consommation mondiale, etc... mais c’est le regroupement de toutes ces illustrations qui fait l’intérêt de l’ouvrage. Surtout, il apparaît comme un document à mettre entre toutes les mains et surtout celles des non spécialistes dont l’intérêt pour le sujet en est encore au stade embryonnaire. Si vous avez un cadeau à faire, joignez l’utile à l’agréable et n’hésitez pas, vous aurez même peut être le plaisir d’être questionné sur des aspects laissés dans l’ombre.

Publié aux Éditions Autrement - Octobre 2015.

Février 2016

2/2 L’année climatique 2015 - L’année la plus chaude de l’époque moderne.

Bruno Voituriez et Yves Dandonneau

Sous le signe d’El Niño

Au début de 2014 fut annoncé (on n’ose plus dire prédit) pour le second semestre de l’année un phénomène El Niño qui se déroba au grand dam des scientifiques qui, l’ayant annoncé, attendaient évidemment sa venue.

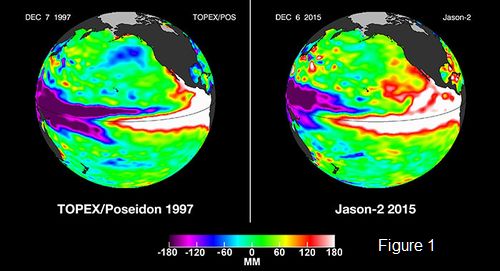

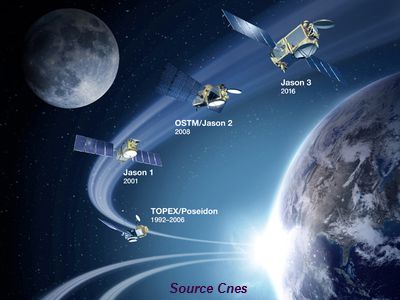

En 2015, sobriété des annonces, on se contenta d’en suivre l’évolution et son épanouissement à partir du mois mai et tout au long de l’année. Phénomène de grande amplitude en tout point comparable à l’évènement de 1997-1998 resté dans toutes les mémoires comme l’El Niño du siècle magnifiquement illustré par les mesures altimétriques du satellite Topex-Poseidon lancé en 1992 . (figure 1)

Comparaison des El Niños 1997/1998 et 2015/2016. Anomalies du niveau de la mer mesurées par Topex/Poseidon (décembre 1997) et Jason 2 (décembre 2015). Le transfert des eaux chaudes de l’ouest vers l’est du Pacifique le long de l’équateur se traduit par une élévation du niveau de la mer à l’est de plus de 20 cm et une diminution équivalente à l’ouest. NASA/JPL-Caltech

Le phénomène a, comme en 1998, marqué de son empreinte les indicateurs du climat global : température, niveau de la mer, teneur en CO2 de l’atmosphère notamment. La NOAA prévoit son déclin à partir de mars 2016 pour un retour à une situation neutre durant le deuxième semestre 2016. El Niño durant en moyenne un peu plus d’un an, il est beaucoup plus facile d’annoncer sa fin que son démarrage….On conclura en 2017.

La température

C’est maintenant traditionnel les agences américaines NASA et NOAA ont conjointement présenté le 20 janvier 2016 le résultat de leur analyse de l’évolution de la température globale de la planète en 2015.

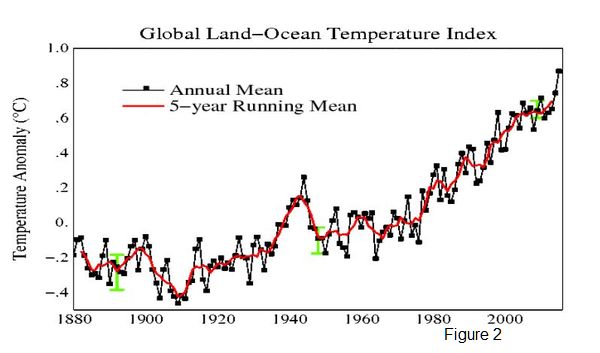

Le résultat est sans appel : la température moyenne de la Terre en 2015 a été supérieure de 0.9°C à la moyenne des années 1901-2000. Elle bat ainsi de 0°16 le record précédent de 2014 qui, lui, n’était que de 0.04°C supérieur au record antérieur de 2010. (figure 2)

Évolution de la température globale depuis 1880 par rapport à la moyenne de la période 1951-1980. NASA-GISS

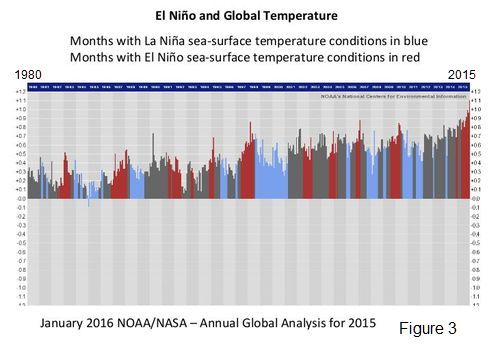

L’amplitude de cet écart d’une année à l’autre est aussi en 2015 un record dont s’approchent les écarts de 1997-1998. Cette similitude entre 1998 et 2015 a une explication : le phénomène El Niño qui induit généralement une élévation de la température et qui, dans les deux cas s’est manifesté avec une exceptionnelle intensité. (figure 3)

El Niño et la température globale 1980- 2015 (NASA/NOAA). El Niño en rouge. La Niña en bleu

Le maximum de température de 1998 auquel certains ont voulu donné une valeur climatique représentative, sans se soucier de la variabilité du climat aux échelles pluriannuelles, et notamment à celle induite par El Niño, est à l’origine de l’hystérie du «hiatus» dans lequel les climatosceptiques voyaient la consécration de leur négation du réchauffement climatique. La fin de l’actuel El Niño débouchera peut-être sur un nouveau plateau apparent, mais cette fois il sera à une valeur de température plus élevée…..

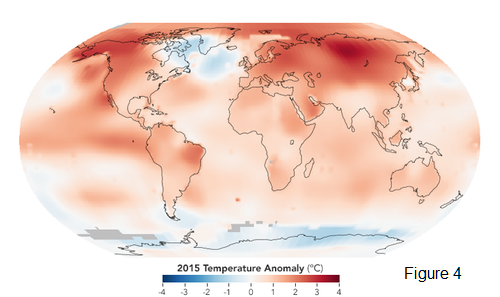

La carte des anomalies de température de 2015 (figure 4) montre que l’’accroissement de température n’est pas uniformément répartie.

Anomalies de température en 2015 par rapport à la moyenne de la période 1951-1980. NASA Earth Observatory

Un point attire l’attention : l’anomalie négative très significative sur l’Atlantique Nord. Les intervenants à la conférence de presse NASA/NOAA proposent deux explications possibles : l’affaiblissement de la MOC (meridional overturning circulation) qui a pour conséquence un affaiblissement du transport de chaleur vers le nord par l’océan ou bien l’apport d’eau froide venant de la fonte du Groenland (EOS 25 janvier 2016). Affaire à suivre…..

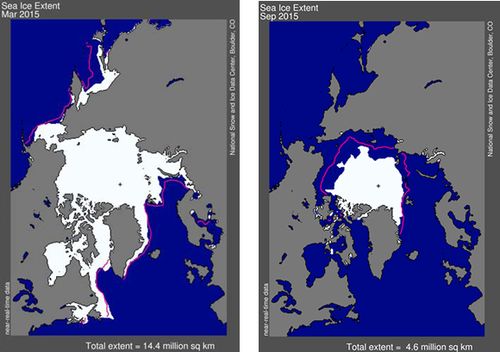

Les banquises

En Arctique la banquise a atteint son extension maximum en février 2015 : 14.5 millions de km2 soit 1.1 millions Km2 de moins que la moyenne 1980-2010. C’est l’extension la plus faible depuis que l’on mesure cette extension par satellite en 1979 (figures 5 et 6).

Figure 5

Extension de la glace Arctique en mars 2015 à gauche et septembre 2015 à droite correspondant au maximum et au minimum d’extension. La ligne magenta représente l’extension moyenne sur la période 1981-2010. nsidc.org/data/seaice_index.

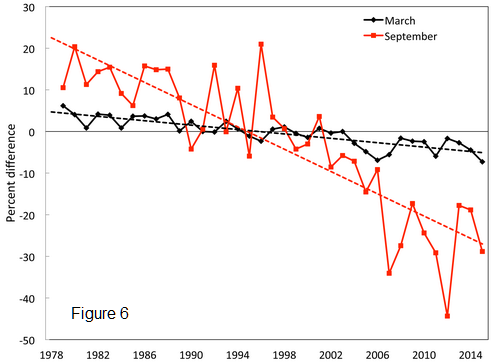

Évolution de l’extension des glaces en Arctique en Mars (maximum) et en septembre (minimum). Période de référence 1981-2010. (D. Perovich et al . 2015. Sea ice in Arctic Report Card Update for 2015)

Le minimum, 4.4 millions de km2 a été atteint le 11 septembre : c’est la quatrième plus faible extension depuis le début des observations satellitaires. C’est 1.8 millions de km2 de moins que la moyenne 1981-2010 et 1 million km2 au-dessus du minimum absolu de septembre 2012. (figures 5 et 6) . La décroissance est en moyenne de 2.6% par an en Mars (au maximum) et de 13.4% en Septembre au minimum.

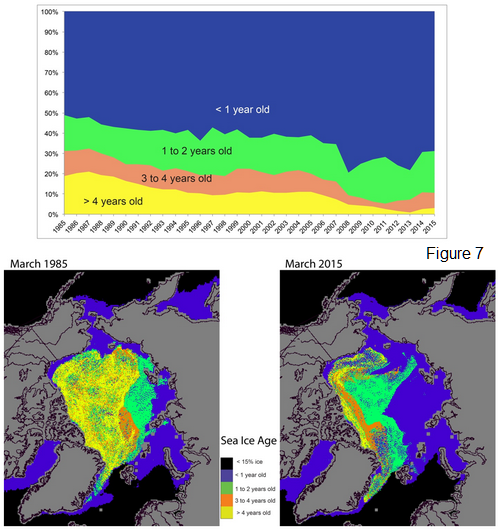

L’âge de la glace est un paramètre important pour évaluer l’évolution de la banquise au-delà des variations saisonnières. Pour se maintenir, le stock de glace de l’Arctique doit être alimenté par des glaces qui survivent au dégel et passent le cap des années. En mars 1985 la plus vieille glace (plus de 4 ans) représentait 20 % du pack et en 2015 elle n’en représentait plus que 3% (figure 7).

Évolution de l’âge des glaces de l’Arctique à leur maximum en mars en haut. Comparaison de l’ âge des glaces en Mars 1985 et Mars 2015 en bas. (Perovich et al . 2015. Sea ice in Arctic Report Card Update for 2015)

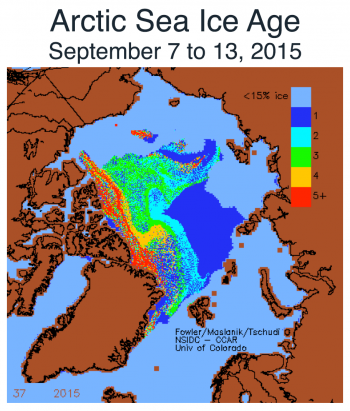

À l’inverse la glace de première année est passée d’environ 50% du pack en 1980 à 70% en mars 2015. Manifestement les réserves s’épuisent. Un indicateur de l’évolution prévisible de ce stock est la proportion de glace de première année qui résiste à la fonte estivale qui suit leur formation. En 2015 (figure 8) c’est soixante deux pour cents de la glace nouvellement formée (première année) qui n’a pas résisté, à comparer aux records de 2007 (67%) et 2012 (73%).

Figure 8

Les âges des glaces de l’ Arctique à leur extension minimum de septembre 2015

Ainsi, faute d’être régulièrement ravitaillé, inexorablement le stock de glace arctique s’appauvrit.

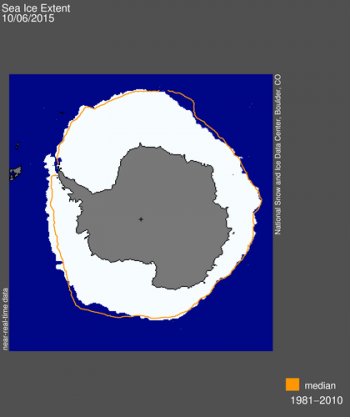

La banquise antarctique a atteint son maximum (18.8 millions de Km2) le 6 octobre 2015 (figure 9).

Figure 9

La banquise de l’Antarctique : extension maximum le 6 octobre 2015. La ligne orange représente l’extension moyenne 1981-2010. (NSIDC)

C’est la seizième plus grande extension depuis 1981 (120 000 km2 au-dessus de la moyenne 1981- 2010) mais surtout cette année met fin à trois années de croissance consécutives surprenantes en période de réchauffement mais expliquées par l’accroissement du vent dans l’Antarctique (cf news 2015).

Le niveau de la mer

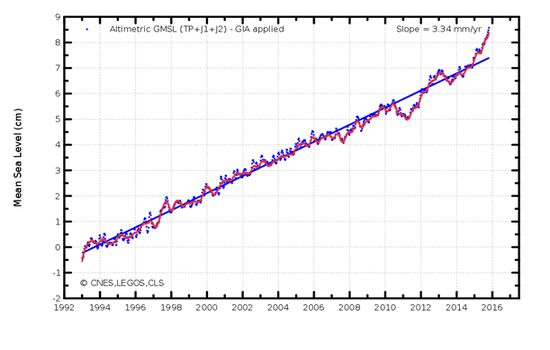

L’élévation du niveau de la mer qui est en moyenne d’environ 3.3 mm/an sur la période 1993-2015 a été particulièrement importante en 2015 comme le montre la courbe de la figure 10 qui est en forte croissance.

Figure 10

Élévation du niveau de la mer de 1993 à 2015 (AVISO)

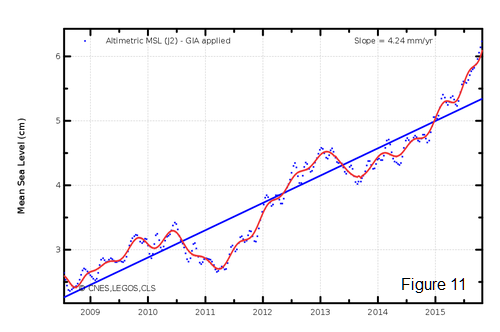

C’est encore El Niño qui marque son empreinte. On voit sur la même figure qu’un pic analogue avait été observé pendant l’El Niño de 1997/1998. Cela tient à ce que le phénomène El Niño se traduit par de fortes précipitations sur l’océan et globalement un transfert d’eau des continents vers l’océan. Malheureusement le système climatique étant très complexe on ne peut en déduire que chacun des pics observés correspond à un phénomène El Niño. Par exemple le pic de 2013 apparent aussi sur la courbe ne correspond à aucune anomalie de type El Niño. Un zoom sur la période 2009-2015 (figure 11) semble indiquer une accélération de l’élévation du niveau de la mer (4.24 mm/an). À ce stade on se contentera d’en prendre acte en attendant la suite…..

Élévation du niveau de la mer 2009-2015 (AVISO)

Le gaz carbonique

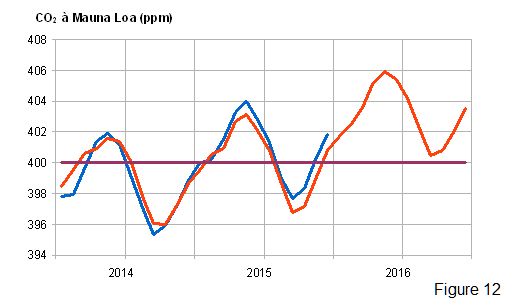

Les teneurs en gaz carbonique de l’atmosphère ont continué de croître en 2015 passant selon la NOAA de 397.69 ppm en novembre 2014 à 400.38 en novembre 2015 soit une augmentation de 2.69 ppm . C’est la valeur la plus élevée depuis 1998 (2.82). Faut-il encore y voir la trace d’El Niño qui s’est manifesté, on l’a vu, avec une rare intensité en I997/1998 et 2015 ? En situation normale l’océan Pacifique équatorial, siège d’un upwelling (remontée d’eau froide riche en gaz carbonique le long de l’équateur) est normalement une source de CO2 alors que pendant un El Niño c’est l’inverse : le Pacifique équatorial envahi par les eaux chaudes qui s’écoulent d’ouest en est, et dont le gaz carbonique est en équilibre avec celui de l'atmosphère perd ce caractère de source de CO2. Au contraire, les importantes modifications du régime des pluies sur les continents pendant les épisodes El Niño y modifient profondément le cycle du carbone. La hausse très abrupte de la concentration en CO2 atmosphérique en 1997-98 est imputable aux sécheresses intenses et aux incendies qui ont marqué cette période. Il est encore trop tôt pour affirmer qu'une hausse analogue se reproduira pour l'épisode 2015-2016. Si c'était le cas, l'enregistrement de la concentration en CO2 de l'atmosphère à Mauna Loa (îles Hawaï) ne repasserait désormais plus au dessous de la barre symbolique de 400 ppm, qu'il aurait définitivement franchie en octobre 2015 (figure 12)....

Comparaison de l'évolution du CO2 pendant les El Niño de 1997-98 et de 2015-16. En bleu : évolution de 2014 à 2015 ; en rouge, évolution de 1996 à 1998, augmentée de la tendance croissante observée de 1996 à 2015.

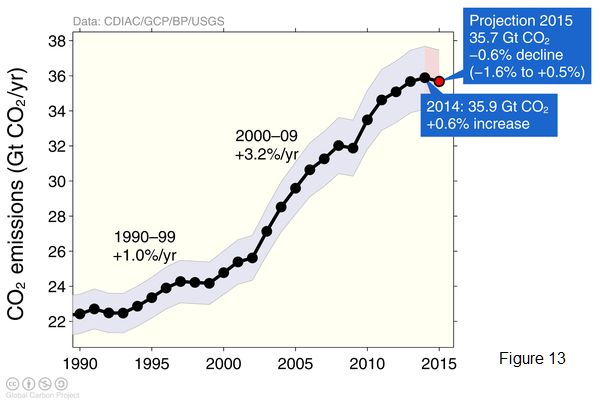

Reste à réussir à anticiper l'apparition du phénomène El Niño, qui, jusqu'à maintenant, résiste aux tentatives de prévision. Contrairement à 1997-98, il semble bien qu’en 2015 les émissions de CO2 aient diminué. Selon le Global Carbon Project les émissions de 2015 seraient de 35.7 Gigatonnes contre 35.9 en 2014 soit une diminution de 0.6%. Chiffre à confirmer : l’an dernier à la même époque le Global Carbon Project annonçait pour 2014 une augmentation des émissions de 2.5% alors qu’elle fut ramenée finalement à +0.6 %. L’avenir dira si ce ralentissement (2014), puis cette baisse (2015) est le résultat d’un véritable effort de réduction des émissions ou la simple manifestation d’un très net ralentissement de la croissance du plus gros émetteur de CO2, la Chine. Une baisse analogue des émissions avait déjà été observée en 2009 (figure 13) suite à la crise de 2008 mais l'accroissement des émissions avait ensuite rapidement repris son cours.

Évolution des émissions de CO2 (fuel et industrie) depuis 1990. (Global Carbon Project).

L’année 2015 est particulièrement intéressante parce que l’occurrence d’El Niño permet de faire une comparaison avec la situation analogue de 1997/1998. De fortes similitudes sont déjà apparues sur les impacts respectifs de ces deux évènements. Mais n'anticipons pas.: El Niño est capricieux. Attendons le retour à la normale annoncé en 2016 pour tirer des conclusions....définitives."

Janvier 2016

1/1 Après la COP 21 - Bruno Voituriez.

La 21ème Conférence des Parties à la Convention Cadre des Nations Unies sur les Changements Climatiques qui s’est tenue à Paris du 30 novembre au 12 décembre a débouché sur un accord que l’on peut qualifier d’historique, puisqu’il efface l’échec de la COP 15 de Copenhague en 2009 dont l’objectif était de définir un nouvel accord pour prendre la suite du protocole de Kyoto (COP 3 de 1997) qui arrivait à échéance en 2012. Lors de la COP 18 à Doha en 2012, il fut décidé de prolonger le protocole de Kyoto jusqu’en 2020 et de préparer un nouvel accord pour lui succéder. C’était l’objectif de la COP 21 et il fut atteint puisqu’accord il y eut.

La 21ème Conférence des Parties à la Convention Cadre des Nations Unies sur les Changements Climatiques qui s’est tenue à Paris du 30 novembre au 12 décembre a débouché sur un accord que l’on peut qualifier d’historique, puisqu’il efface l’échec de la COP 15 de Copenhague en 2009 dont l’objectif était de définir un nouvel accord pour prendre la suite du protocole de Kyoto (COP 3 de 1997) qui arrivait à échéance en 2012. Lors de la COP 18 à Doha en 2012, il fut décidé de prolonger le protocole de Kyoto jusqu’en 2020 et de préparer un nouvel accord pour lui succéder. C’était l’objectif de la COP 21 et il fut atteint puisqu’accord il y eut.

C’est un succès important puisque l’accord a reçu l’approbation des représentants des 195 Etats présents dont les USA, (qui a l’époque de Kyoto était le plus grand producteur de CO2,) et de l’Australie qui n’avaient pas ratifié le protocole de Kyoto et aussi du Canada qui s’en était retiré. Une dynamique est ainsi créée qui ne sera sans doute pas remise en cause au moment de la signature effective par les États car, à la différence du protocole de Kyoto, il n’est contraignant que sur la méthodologie de mise en œuvre de l’accord et pas sur les objectifs chiffrés de réduction des gaz à effet de serre ou de financement des mesures d’atténuation et d’adaptation des pays en voie de développement par les pays développés.

Réduction des Gaz à effet de serre.

Plutôt que d’imposer des taux de réduction comme c’était le cas pour le protocole de Kyoto, il a été demandé à chaque État de présenter son plan de réduction pour faire une analyse de la somme de ces contributions et en tirer des conclusions, pour l’action, par rapport à l’objectif affiché de limiter à 2°C en 2100 l’augmentation moyenne de la température de la Terre par rapport à l’ère dite préindustrielle (1880). Cent quatre vingt sept Etats ont rendu leur copie, («INDC» Intended Nationally Determined Contributions), ce qui correspond à 97% des émissions mondiales de 2011. C’est en soi un succès car cela montre que la quasi-totalité des États a pris conscience du problème et est déterminée à agir. Néanmoins la COP a aussi pris acte, avec inquiétude, qu’en l’état, avec ces contributions, on était assez loin du compte pour maintenir l’accroissement de la température moyenne de la Terre en-dessous de 2°C (le minimum d’augmentation serait 2,7°C en l’état des contributions annoncées). C’eut pu être une butée conduisant à l’échec. Heureusement la diplomatie profitant de la participation volontaire de la quasi-totalité des états a su faire preuve de souplesse et, en l’occurrence, on peut dire que la COP 21 a su être pragmatique en adoptant la méthode expérimentale.

Il est demandé aux parties de communiquer d’ici 2020 une nouvelle contribution et de le faire ensuite tous les cinq ans. Le Groupe de travail spécial de l’Accord de Paris, (qui succède à celui de Durban mis en place à la COP 17 de 2011 pour préparer le nouvel accord), a été créé pour analyser ces contributions et en tirer les conclusions aux Conférence des Parties. Ainsi, pas à pas (rapides), pourra être faite la confrontation entre la décroissance mesurée des émissions des gaz à effet de serre, la prévision de leur évolution, l’évolution prévisible du climat et son observation.

La COP 21 va même plus loin : pour répondre à la demande des États Insulaires particulièrement exposés, la conférence :

«Invite le Groupe d’experts intergouvernemental sur l’évolution du climat à présenter un rapport spécial en 2018 sur les conséquences d’un réchauffement planétaire supérieur à 1,5 °C par rapport aux niveaux préindustriels et les profils connexes d’évolution des émissions mondiales de gaz à effet de serre». Sachant que depuis l’ère préindustrielle la température a déjà augmenté de près de près de 1°C, c’est évidemment peu crédible mais ainsi va la diplomatie : en échange les États Insulaires acceptent qu’au titre des pertes et préjudices «l’Accord ne peut donner lieu ni servir de fondement à aucune responsabilité ni indemnisation».

Adaptation et financement

Le changement climatique, ou plutôt les changements climatiques (car chaque région de la Terre aura son «changement propre») auront bien lieu et il faudra nécessairement s’y adapter. Les Pays en voie de développement qui ont le besoin impératif de continuer à se développer pour réduire la pauvreté sont souvent les plus exposés. Il est donc nécessaire qu’ils aient le soutien des pays développés : soutien technologique pour leur développement en réduisant au maximum les émissions de gaz à effet de serre et soutien financier.

Le point crucial est évidemment financier. Il avait été décidé lors des COP 15 et 16 de créer pour ce faire un fond de 100 milliards de dollars par an à l’échéance 2020. Là encore, il y a un écart entre les «promesses» et la réalité. La date retenue par l’accord pour atteindre ces 100 milliards par an est 2025, mais il s’agit là maintenant d’un plancher : ce fond devra augmenter ensuite pour tenir compte des besoins et des priorités des pays en développement. Ici encore pas de contraintes imposées, mais une évaluation permanente par les comités ad hoc mis en place dans le cadre de la CCNUCC.

Pertes et préjudices

C’est un élément récent soulevé par les pays les plus vulnérables au changement climatique, pour que les conséquences du changement climatiques sur la durée, comme l’élévation du niveau de la mer et les événements météorologiques extrêmes(inondations, cyclones), soient pris en compte. La question était au programme de la COP 18 de Doha en 2012. À la COP 19 de Varsovie en 2013 the “Warsaw International Mechanism for Loss and Damage associated with Climate Change Impacts“ a été créé et son programme fut fixé à la COP suivante de Lima en 2014. On l’a vu précédemment,«l’Accord [de Paris] ne peut donner lieu ni servir de fondement à aucune responsabilité ni indemnisation». Néanmoins le «Mécanisme international de Varsovie» est maintenu et son Comité exécutif est chargé d’élaborer des recommandations relatives à des démarches intégrées propres à prévenir et réduire les déplacements de populations liés aux effets néfastes des changements et à y faire face.

Conclusion

Nombreux sont ceux qui ont manifesté une certaine déception face aux résultats de cette COP 21 qui effectivement ne débouche pas sur des plans concrets, chiffrés et contraignants. Ils redoutent ainsi un avenir climatique catastrophique du fait d’un possible dépassement des fatidiques 2°C. Rappelons que l’affichage 2°C est une construction politique issue de l’échec de la COP de Copenhague (News 2015 club des Argonautes). La démarche pragmatique adoptée par l’Accord de Paris est saine car elle tire les leçons du passé : le semi-échec du protocole de Kyoto et l’échec de la COP de Copenhague qui visait à donner une suite à ce protocole.

Une nouvelle dynamique est enclenchée, confortée par la prise de conscience par 195 Etats dont les plus grands émetteurs de gaz à effet de serre de la réalité du changement climatique et des difficultés auxquels ils exposent l’humanité.

Dans le journal «Le Monde» des 10-11 janvier 2016, Nicolas Hulot perplexe s’interroge à propos de la COP 21 : «l’avenir dira si c’est le début d’une extraordinaire ambition ou d’une ultime mystification».

On peut parier sur le premier terme de l’alternative. La présence de nombreuses entreprises à la COP 21, que certains écologistes militants ont vue d’un œil méfiant, va dans ce sens car elles ont compris que l’avenir et leur intérêt passent par la «décarbonation» de l’énergie et le développement de technologies et énergies nouvelles. C’est le cas notamment des entreprises pétrolières qui n’ont d’ailleurs plus le choix comme le montre le procès intenté aux USA à EXXON qui, pourtant convaincue dès le début des années 1980 de la réalité du changement climatique, a pendant trente ans financé parlementaires et divers lobbys, incluant même des scientifiques pour contester la réalité du phénomène. Les fonds de pension qui sont tenus de faire le maximum de bénéfices sont aussi sur la brèche. Si cette orientation de l’intérêt bien compris se confirme, l’avenir sera peut-être plus souriant que certains qui désespèrent de la sagesse de l’homme ne le prévoient. En tout état de cause, comme l’affirme le Club des Argonautes, Il est temps d'agir.

Janvier 2016

2/2 LANCEMENT DE JASON-3 - Le point sur l'altimétrie au 18/01/2016. Jean Pailleux.

Le satellite altimétrique Jason-3 a été lancé avec succès le 17 janvier 2016 depuis la base américaine de Vandenberg en Californie. C'est le 3e satellite de la série Jason, sa mission principale est d'assurer la continuité de celle de Jason-2, toujours en fonctionnement. Développé dans le cadre d'une collaboration américano-européenne (CNES, EUMETSAT, NOAA, NASA), ce satellite est d'abord destiné à la mesure du niveau de l'océan, grâce au radar altimétrique Poséidon-3B, associé à un système d’orbitographie de haute précision.

Le satellite altimétrique Jason-3 a été lancé avec succès le 17 janvier 2016 depuis la base américaine de Vandenberg en Californie. C'est le 3e satellite de la série Jason, sa mission principale est d'assurer la continuité de celle de Jason-2, toujours en fonctionnement. Développé dans le cadre d'une collaboration américano-européenne (CNES, EUMETSAT, NOAA, NASA), ce satellite est d'abord destiné à la mesure du niveau de l'océan, grâce au radar altimétrique Poséidon-3B, associé à un système d’orbitographie de haute précision.

À son bord, se trouvent également :

-

l'instrument DORIS, développé par le CNES, ainsi qu'un réflecteur laser et un récepteur GPS. Ces 3 éléments constituent le système de localisation et de restitution d’orbite précise;

-

un radiomètre micro-onde (AMR : pour évaluer le contenu atmosphérique en vapeur d'eau et pour faciliter la correction altimétrique dite de «troposphère humide »).

Jason-3 est placé sur une orbite inclinée de 66° (par rapport à l'équateur) à 1336 km d'altitude, la même orbite que Jason-2. Ses mesures de hauteurs dynamiques de l'océan sont destinées à être utilisées en synergie avec celles de plusieurs autres satellites. Cette flottille contribue aux besoins de l'océanographie opérationnelle et de la surveillance du climat en fournissant d'autres données comme la température de surface, et les variations de couleur de l'océan. Les satellites altimétriques contribuent aussi à l'observation de la hauteur des vagues, du vent de surface (à 10 m au-dessus du sol), et de certaines étendues d’eau continentales. Souvent ils embarquent un sondeur micro-onde pour mesurer également l'humidité atmosphérique intégrée sur la verticale."

Un point sur le développement de l'altimétrie spatiale

L'émergence de l'altimétrie spatiale est décrite sur ce même site web :

Partie 1 : La Terre mesurée depuis l’Espace... : de DIAPASON (1966) à JASON (2001), la contribution française

La « News » d'avril 2006 : Quinze ans de progrès en altimétrie radar

Le principe de l'altimétrie est rappelé dans la FAQ : Quelles sont les variations actuelles du niveau de la mer?

Voir aussi : «Satellite altimetry and earth sciences», edited by Lee-Lueng Fu and Anny Cazenave. Academic Press. ISBN : 0-12-269545-3

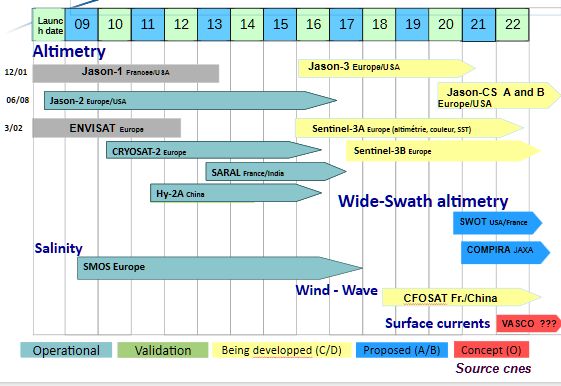

Nous faisons ici un point sur la mesure depuis l’espace du niveau de la mer au moment du lancement de Jason-3. Nous remontons jusqu'au début des années 1990, résumant ainsi 25 ans d'histoire de l'altimétrie. ERS1 (1991-2000), ERS2 (1995-2011) et ENVISAT (2002-2012) sont trois satellites européens (ESA) qui contribuèrent beaucoup à l'altimétrie sur cette période tout en embarquant de nombreux autres instruments. Voir par exemple les 11 instruments embarqués sur ENVISAT.

Ces trois satellites européens étaient tous sur des orbites héliosynchrones, alors que le satellite américain GFO (1998 - 2008), le successeur de GEOSAT (1985 – 1990), plus spécialement dédié à l'altimétrie, plus léger, était sur une orbite inclinée non héliosynchrone.

Une étape majeure a été atteinte dès août 1992 avec le lancement du satellite TOPEX–Poséidon, une mission franco-américaine de référence pour l'altimétrie (haute précision, orbite non héliosynchrone inclinée à 66° et à 1336 km d'altitude). La mission de TOPEX–Poséidon s’est terminée en 2005. Cependant, la précieuse collection de mesures entamée 13 ans plus tôt, se poursuit grâce à la série des «Jason» : Jason-1 (2001-2013) et Jason-2 (lancé en 2008, toujours en service), et Jason-3 qui vient d'être lancé.

On parle de «missions de référence», car l'orbite non héliosynchrone permet de mesurer les marées. Les plateformes héliosynchrones, donc phasées avec le cycle diurne, sont affectées par un échantillonnage inadéquat du cycle des marées. A la différence d'une plateforme multi-missions comportant une grande diversité de mesures, un système dédié du type Jason est plus léger, moins coûteux, et son orbite peut être optimisée dans ses moindres détails pour satisfaire les besoins de la mesure de la hauteur de l'océan. Il n'est pas nécessaire de rechercher « une répartition équitable du mécontentement » entre les exigences parfois contradictoires de divers utilisateurs. Les mesures fournies par les satellites héliosynchrones (ERS, ENVISAT, Sentinel-3) sont étalonnées (recalées) sur les mesures des satellites non-héliosynchrones (Jason).

En outre , les rendez-vous en orbite entre missions de référence successives, (décembre 2001 entre TOPEX–Poséidon et Jason-1, puis juillet 2008 entre Jason-1 et Jason-2), ont permis d’opérer, (au cours de 2 vols en formation serrée de plusieurs mois), un inter-étalonnage de ces 3 systèmes de mesure couvrant maintenant une durée d’observation de plus de 20 ans. Il s’agit d’une étape vitale pour éliminer les effets de dérives éventuelles ou de biais de mesure entre un système précis mais vieillissant, et son successeur, en début de carrière ! Espérons que le même inter-étalonnage va pouvoir s'effectuer entre Jason-2 et Jason-3.

L’existence de mesures de référence permet de tirer profit des observations co-localisées : lorsque 2 systèmes altimétriques réalisent chacun une mesure de hauteur dynamique au même endroit avec un décalage de quelques heures, voire de quelques jours… il est possible d’apporter une correction au système moins précis en utilisant la mission de référence. (Cf. Eos Transactions, sept. 1995.)

Malgré une certaine limitation en couverture de données (due au choix d’une orbite qui ne donne pas accès aux latitudes supérieures à 66° N ou S, et à la visée des altimètres qui se fait uniquement au nadir), les instruments ont permis d'estimer le niveau de l'océan avec une précision inégalée. Plus précisément, ils donnent accès au champ de hauteur dynamique, une grandeur intégrale caractéristique de la colonne d’eau, homologue de ce qu’est pour l’atmosphère le champ de pression au sol. La série des Jason contribue aussi à l'observation de la hauteur significative des vagues, et, de manière plus marginale, à celle du contenu total en électrons de l’ionosphère, et à celle du vent à la surface de l'océan.

L'observation altimétrique en 2016

À coté de Jason-2 et Jason-3 déjà mentionnés, les satellites suivants sont actuellement en service et fournissent des données altimétriques :

-

SARAL: satellite héliosynchrone franco-indien équipé de l'altimètre Altika ; lancé en 2013, on estime à 5 ans sa durée de vie.

-

HY-2A : satellite héliosynchrone chinois équipé d'un altimètre (et aussi d'un diffusiomètre) ; lancé en 2011, il est toujours en service ; son successeur HY-2B doit être lancé en 2016.

-

CRYOSAT-2 : satellite de l'ESA, sur une orbite non héliosynchrone passant tout près des pôles, plus spécialement dédié à l'observation de la glace, mais contribuant de manière significative à l'observation de l'océan ; il est équipé du radar interférométrique SIRAL qui peut fonctionner en mode «SAR» pour atteindre localement une résolution horizontale de 250m.

Sentinel-3A, premier satellite altimétrique européen de la série du programme COPERNICUS, doit autre lancé au début 2016, peu de temps après Jason-3. Il doit être placé sur une orbite héliosynchrone à 815 km d'altitude et être équipé du radar altimétrique SRAL.

Pour l'océanographie opérationnelle telle qu'elle est pratiquée maintenant à Mercator-Océan, les observations des satellites suivants Jason2, SARAL, et Cryosat2, sont utilisées pour guider les modèles. Les spécialistes parlent d'assimilation de ces données dans les modèles. Les données sont disponibles en quelques heures pour les dernières données et dans les 24h avec un traitement plus fin des erreurs. HY-2A a été assimilé jusqu’à l'été 2015, mais des anomalies ont été détectées et ses données ont été retirées de l'assimilation. Elles seront réintroduites si leur monitoring montre une meilleure qualité.

Le diagramme suivant résume l'ensemble des missions altimétriques depuis 1991 et contient aussi les missions programmées pour les prochaines années.

Un point complet sur l'altimétrie nécessite de mentionner aussi les missions gravimétriques qui permettent de mieux connaître le champ de gravité terrestre et donc le géoïde. Depuis 2002 un satellite GRACE fonctionne opérationnellement, les successeurs (GRACE-FO – Follow-On) devraient être prêts à continuer à partir de 2017. La mission GOCE de l'ESA (2009 – 2012) a permis d'étudier le champ de gravité à une résolution horizontale très fine.

Et le futur jusqu'en 2025 ?

Dans son plan de mise en œuvre pour l'évolution du système mondial d'observation jusqu'en 2025, adopté en 2013/14 par l'Organisation Météorologique Mondiale (OMM), on trouve l'action suivante concernant l'observation altimétrique : «Implement an altimeter constellation comprising a reference mission on high-precision, not sun-synchronous, inclined orbit, and two instruments on well separated sun-synchronous orbits.».

Cette action a été rédigée à partir des besoins exprimés par les usagers s'occupant des différentes applications utilisant la hauteur du niveau de la mer, besoins extrapolés jusqu'en 2025. Sans regarder dans les détails, on voit que la situation actuelle de l'altimétrie spatiale n'est déjà pas loin de celle recommandée par les experts de l'OMM. Il subsiste toutefois des lacunes par rapport aux besoins idéaux («gaps with respect to observation requirements» dans le langage du web Oscar de l'OMM), en particulier si l'on regarde de près dans quelle mesure les instruments actuels permettent d'atteindre la bonne couverture globale en observations et la bonne résolution horizontale.

Pour améliorer l'observation altimétrique (et aussi l'observation d'autres paramètres environnementaux comme ceux de l'ionosphère, ou ceux du géoïde), plusieurs avancées technologiques sont prévus sur les satellites du futur (déjà programmés ou encore à l'étude).

-

La série Sentinel (inaugurée par Sentinel-3A début 2016) doit se poursuivre par Sentinel-3B prévu après 2017 pour une durée de 7 ans environ.

-

Idem pour HY-2B qui doit succéder à HY-2A.

-

Après Jason-3, un «Jason-CS» (Jason Continuity of Service) devrait prendre le relais, avec une instrumentation améliorée en cours de réalisation. Son nouvel instrument (Poseidon-4) fournira une précision de 5 mm. Jason-CS doit rejoindre la filière « Sentinel » en s'appelant aussi « Sentinel-6A ».

-

La mission franco-américaine SWOT, également en cours de réalisation, devrait être mise en orbite en 2020. Elle doit permettre des avancées majeures, non seulement en océanographie à haute résolution, mais aussi dans l'hydrologie des fleuves et rivières. Elle doit s'appuyer en particulier sur le radar interférométrique KaRIN (Ka-band Radar Interferometer) qui observerait la surface des océans et autres étendues d'eau sur une fauchée de 120 km de large avec une très fine résolution horizontale.

-

Au stade de la conception, la mission COMPIRA de l'agence japonaise JAXA emportera aussi un instrument à large fauchée sur une orbite non héliosynchrone et peu inclinée.

En savoir plus :