Septembre 2018

1/1 Aeolus et son lidar-vent enfin dans l'espace. Jean Pailleux

Que mesure le lidar Aladin embarqué sur Aeolus ?

Mission Aeolus : l'aboutissement d'un très long processus

Comment les données Aeolus vont-elles être distribuées, évaluées et utilisées ?

Aeolus : une contribution au système mondial d'observations parmi beaucoup d'autres

Le 22 août 2018, à 18h20 heure locale (21h20 UTC), une fusée Vega décolle de la base guyanaise de Kourou avec à son bord le satellite Aeolus muni d'un lidar, le premier instrument spatial capable d'observer des profils verticaux de vent dans l'atmosphère. Le satellite Aeolus (appelé aussi ADM-Aeolus ; Atmospheric Dynamics Mission - Aeolus) représente une masse de 1360 kg placée sur une orbite héliosynchrone à 320 km d'altitude. Il est équipé d'un seul instrument actif : le lidar-vent Aladin (Atmospheric Laser Doppler Instrument) mesurant le vent par effet Doppler. Il s'agit d'une mission expérimentale pilotée par l'Agence Spatiale Européenne (ESA) dans sa série dite «Earth Explorers». Les données doivent être mises à disposition de la communauté scientifique d'ici quelques mois, et la durée de vie de la mission est estimée à 3 ans (2018-2021). Si elle est couronnée de succès, elle prouvera la viabilité de ce concept de «lidar-vent spatial» et ouvrira la voie à des missions pleinement opérationnelles basées sur le même concept.

La lancement d'Aeolus est une étape majeure dans l'histoire de l'utilisation des lidars en météorologie. Testé ou utilisé en routine depuis la fin des années 70 pour mesurer diverses variables atmosphériques depuis le sol, ce type d'instrument a mis beaucoup plus de temps pour pouvoir être embarqué sur des satellites météorologiques. La mesure du vent au moyen d'un lidar spatial a déjà été étudiée de façon approfondie dans les années 80, en particulier aux USA et en France (CNES), mais les difficultés technologiques n'ont pas permis à ce moment de déboucher sur le développement d'aucun prototype. Un projet européen piloté par l'ESA (ADM ; Atmospheric Dynamics Mission), a vu alors le jour vers 1990, aboutissant à la définition du satellite et de son instrument. Il a été choisi en 1999 parmi les missions spatiales devant être menées à bien avec l'année 2007 comme date cible de lancement. Le lancement intervient donc avec 11 ans de retard et de travail visant à faire fonctionner correctement le lidar dans les conditions de l'espace.

Que mesure le lidar Aladin embarqué sur Aeolus ?

Pour mesurer les vents depuis l'espace, Aeolus va tester une technique lidar nouvelle mise au point par Airbus Defence and Space (précédemment «Astrium» ; «Matra Marconi Space (MMS)» encore plus précédemment). Il s'agit d'un laser de forte puissance qui va sonder les couches atmosphériques depuis une trentaine de kilomètres d'altitude jusqu'au sol. Il envoie des impulsions depuis le satellite à une longueur d'onde unique fixée à 355 nm (dans l'ultra-violet), selon un angle de visée s'écartant de 35° du nadir, dans un plan vertical perpendiculaire à sa trajectoire, sur la droite par rapport au mouvement du satellite. La principale mesure du lidar Aladin est donc un ensemble de valeurs du vent le long de cette ligne de visée inclinée à 35°, valeurs obtenues à partir des échos reçus en retour par l'instrument depuis les différentes couches de l'atmosphère et des décalages Doppler mesurés sur ces échos. Les cibles principales du laser sont essentiellement les molécules des principaux composants de l'air (azote, oxygène) en ciel clair. Toutefois sa forte résolution spectrale lui permet d'identifier aussi plusieurs types d'aérosols ainsi que le sommet des nuages.

Principe de la mesure du vent par la mission spatiale Aeolus. Crédit ESA.

Seule la composante du vent le long de la ligne de visée (LOS – Line Of Sight) est obtenue par cette technique. Elle est appelée «vent LOS» («LOS wind» en anglais). De plus, afin d'obtenir une bonne précision les signaux Doppler sont accumulés et moyennés sur une distance de l'ordre de 87 km (voir figure) le long de la trajectoire du satellite (ou plutôt de sa trace au sol selon la ligne de visée) afin de produire un profil de vent LOS. À cette échelle horizontale, le vent vertical est généralement négligeable devant le vent horizontal, ce qui permet d'extraire tous les 87 km environ des vents horizontaux selon la ligne de visée appelés «vent HLOS» (Horizontal Line Of Sight winds). Ce vent horizontal est le produit qui intéresse le plus les utilisateurs, en particulier ceux s'occupant de l'assimilation pour les modèles de prévision numérique du temps et pour les réanalyses climatiques.

Les spécifications de la mission Aeolus prévoient que la composante de vent ainsi mesurée sera obtenue avec une précision de 1 à 2 m/s (variable selon l'altitude considérée). La résolution verticale prévue varie de 250 m dans la couche limite de l'atmosphère jusqu'à 2 km dans la stratosphère au-delà de 20 km.

Les principales limitations de ce système d'observation sont les suivantes :

- Une seule composante du vent observé, celle dans la direction perpendiculaire à la trajectoire du satellite Aeolus.

- Peu de points d'observation du fait de la ligne de visée unique et de l'inter-distance de 87 km entre profils observés ; donc couverture globale en données de faible densité si on la compare aux autres instruments spatiaux sondant l'atmosphère en température et humidité.

- Comme pour les sondeurs infrarouges satellitaires, le lidar Aladin ne pénètre pas les nuages, et donc les observations sont limitées aux parties de l'atmosphère en ciel clair ou situées au-dessus des nuages.

La vidéo de l'ESA, visible sur son site et ci-dessous, explique très bien à la fois le fonctionnement de l'instrument et l'intérêt de mesurer le vent sur toute la planète.

Mission Aeolus : l'aboutissement d'un très long processus

Le lidar a été utilisé en météorologie depuis un demi-siècle pour étudier à partir du sol la composition chimique de l'atmosphère, les aérosols, les nuages et le vent. Dans ce domaine, la communauté scientifique française s'est montrée très active : voir par exemple Mégie and Menzies (1980) pour la mesure des espèces chimiques, ou encore Souprayen et al. (1999) pour une technique de mesure du vent dite «détection directe». Cette dernière, traitant la diffusion Rayleigh des molécules d'air ainsi que la diffusion Mie des aérosols, est très proche dans son principe de la technique retenue pour la mission spatiale Aeolus. Elle a aussi permis en 1993 l'installation d'un lidar-vent à l'Observatoire de Haute-Provence (OHP), qui fonctionne régulièrement depuis 1995.

Vue aérienne de la station géophysique Gérard Mégie à l'Observatoire de Haute Provence. Crédit : CNRS/OHP

À partir des années 80, la plupart des campagnes de mesures en météorologie utilisent différents types de lidars, d'abord installés au sol, puis souvent aussi embarqués sur des avions de recherche. Dès le début du XXIe siècle, ils commencent à fonctionner régulièrement dans le contexte des réseaux de profileurs opérationnels en météorologie. En 2018, Météo-France opère en routine une dizaine de stations profileurs-lidars observant les aérosols (cendres volcaniques en particulier) ou le vent.

Voir : Site Meteo France "Les lidars et sodars"

La technologie du lidar a mis beaucoup plus de temps à se développer de façon à être utilisée à bord d'un satellite, ce qui explique qu'il a fallu attendre 2018 pour voir le premier lidar-vent dans l'espace. Et c'est seulement au début du XXIe siècle que se concrétisent les premières missions spatiales telles que CALIPSO, un satellite NASA/CNES lancé en 2006 avec le lidar nuages-aérosols CALIOP à bord, associé à deux autres instruments. Voir : Site OSCAR "satellite Calipso"

Deux problèmes au moins contribuent à expliquer les difficultés techniques des missions spatiales embarquant des lidars par rapport aux instruments basés au sol :

- Le lidar est un instrument actif gros consommateur d'énergie. Cela explique en particulier que la durée de vie estimée pour Aeolus soit de 3 ans, alors que par exemple le premier satellite Metop, lancé en 2006, voit fonctionner encore la plupart de ses instruments 12 ans plus tard.

- Aladin est un type d'instrument très sensible au milieu dans lequel il se trouve plongé et à ses variations. Il est donc très difficile de s'assurer qu'il fonctionnera bien dans l'espace par des tests au sol simulant l'environnement spatial. Le transport d'Aeolus depuis l'Europe jusqu'à Kourou, avant son lancement, a dû être effectué en bateau plutôt qu'en avion, pour lui éviter les brusques variations de pression atmosphérique au moment du décollage et de l'atterrissage de l'avion.

Alors que les projets antérieurs étudiant les lidars-vent pour l'espace n'ont pas réussi à déboucher sur une mission spatiale, l'ESA lance vers 1990 un nouveau projet appelé ADM (Atmospheric Dynamics Mission). Le groupe consultatif du projet rassemble des spécialistes de la technologie lidar ainsi que des scientifiques utilisateurs potentiels des données de vent pour la météorologie et le climat, en particulier ceux qui assimilent les observations dans les modèles de prévision numérique (soit pour la prévision du temps au quotidien, soit pour effectuer des réanalyses climatiques). L'objectif du projet ADM est alors de faire converger les besoins des utilisateurs avec la conception d'une mission spatiale observant le vent à l'échelle globale. La décennie 90 est marquée par une évolution très rapide des recherches sur la technologie des lidars ainsi que sur les méthodes d'assimilation de données, et c'est dans ce contexte que se déroulent les études préliminaires ADM. Elles aboutissent en 1999 à la conception d'un instrument fonctionnant par détection directe dans l'ultra-violet (355 nm), qui est retenu par l'ESA pour constituer sa deuxième mission «Earth-Explorers» après GOCE.

Voir : Site OSCAR "satellite GOCE" et Site OSCAR "Satellite ADM-Aeolus"

Cette mission spatiale (qu'on appelle désormais Aeolus ou ADM-Aeolus) est confiée à Airbus Defence and Space qui met au point l'instrument et le satellite dans son centre toulousain. Dès 2003 une maquette de l'instrument est réalisée qui produit des observations de vent correctes à partir du sol. Une description générale de la mission telle qu'elle est envisagée à cette époque est décrite dans Stoffelen et al. (2005). Mais dès que l'on met la maquette dans les conditions de l'espace, elle ne fonctionne plus. Il faudra plusieurs années de reconfigurations de l'environnement, de tests et de réajustements pour arriver à obtenir des données conformes aux spécifications attendues. Aeolus est enfin sur orbite en 2018, avec 11 ans de retard sur le plan initial. Il est maintenant le 5e satellite de la série ESA/Earth-Explorers alors qu'il était initialement en 2e position. Toutefois ces années de retard ont été mises à profit par les scientifiques à la fois pour perfectionner les spécifications de la mission, mieux préparer le traitement des données réelles et leur utilisation dans les modèles.

Voir par exemple Dabas et al. (2008), Tan et al. (2007).

Voir aussi la documentation scientifique complète (2018) sur le site de l'ESA

Comment les données Aeolus vont-elles être distribuées, évaluées et utilisées ?

Pour la plupart des observations satellitaires utilisables dans les modèles de prévision du temps, même nouvelles et purement expérimentales, un moyen très efficace de les évaluer consiste à les entrer dans une chaîne opérationnelle de prévision, et à d'abord les «assimiler en mode passif», c'est-à-dire à les soumettre à un monitoring qui les compare systématiquement à la meilleure estimation de l'état atmosphérique que l'on puisse obtenir sans utiliser les nouvelles données. Au bout d'une certaine période (quelques jours lorsqu'il s'agit d'un type d'observation déjà connu et utilisé ; quelques mois lorsqu'il s'agit d'un type de données nouveau), si le résultat du monitoring est jugé satisfaisant, il suffit de passer du «mode passif» au «mode actif» au niveau de l'assimilation pour que l'utilisation de l'observation devienne opérationnelle.

Pour voir comment fonctionne le monitoring des diverses observations du vent de surface, voir la FAQ "Le vent à la surface de l'océan."

Pour Aeolus, c'est le CEPMMT (Reading, Royaume-Uni) qui va tenir le premier rôle de monitoring, grâce à son système de prévision global. À partir des données brutes fournies par l'ESA, il va effectuer en temps réel les traitements nécessaires pour produire les vents HLOS (une seule composante horizontale) qui seront introduits dans son assimilation globale, et aussi mis à disposition de la communauté météorologique en temps réel (avec l'appui de Eumetsat). Cette communauté comprend tous les autres centres météorologiques impliqués dans la prévision numérique globale opérationnelle. On s'attend à ce que plusieurs d'entre eux puissent assimiler les vents Aeolus après les avoir soumis à leur propre système de contrôle/monitoring opérationnel (qui permet aussi une inter-comparaison avec d'autres types d'observation). Notons aussi que, le vent HLOS étant réduit à une seule composante (suivant une direction variable dans un repère terrestre), il est difficilement utilisable en-dehors d'un système d'assimilation météorologique global spécialement conçu pour traiter une large variété de types d'observation.

Le CEPMMT est donc une partie importante du segment sol d'Aeolus. Outre le vent HLOS, il doit produire un jeu de données météorologiques auxiliaires contenant température et pression (variables météorologiques auxquelles le vent HLOS est sensible, donc nécessaires au traitement).

L'évaluation des vents Aeolus par monitoring doit se poursuivre pendant quelques mois à partir de leur disponibilité. En parallèle du monitoring, des études d'impact seront menées pour évaluer le bénéfice apporté par les nouvelles données à la qualité de la prévision. Dès que ce bénéfice apparaîtra significatif, les données seront assimilées opérationnellement au CEPMMT. On espère que cette date-là ne sera pas trop proche de la fin de vie du satellite ! À partir de ce moment-là, le CEPMMT produira aussi des vecteurs vent aux points d'observation Aeolus à partir de son analyse opérationnelle, pour les usagers qui souhaitent faire des études avec un vecteur vent complet et sans système d'assimilation. Ces usagers devront avoir conscience que ces données de vent ne sont pas des observations pures : elles sont influencées par les mesures du lidar Aladin, mais aussi par le modèle du CEPMMT au travers de son assimilation, et en particulier par... toutes les autres observations assimilées !

Plus de détails sur le segment sol Aeolus sont disponibles sur la News du CEPMMT.

Notons au passage que la mission Aeolus produira des observations d'aérosols et des sommets des nuages, même si l'observation du vent est son objectif principal.

Et le futur plus lointain ?

Aeolus est une mission expérimentale. Il s'agit de vérifier si un lidar spatial est capable de mesurer le vent sur une épaisseur de l'atmosphère de l'ordre de 30 km avec suffisamment de précision et de fiabilité. La durée de vie du satellite a été estimée à 3 ans. Le compromis choisi par les concepteurs du projet a été de favoriser plus la qualité de la mesure que la quantité d'observations produites, en particulier en effectuant une moyenne des signaux sur 87 km et en produisant seulement une composante de vent tous les 87 km, selon une ligne de visée unique fixée à 35° par rapport au nadir. La couverture de données (représentée ici sur une période de 12 h) est peu dense (quelques milliers de points d'observation) comparée à celle des sondeurs atmosphériques tels que IASI (quelques centaines de milliers d'observations, mais très rapprochées et très redondantes). Notons que le nombre d'observations (profils verticaux) Aeolus est du même ordre que le nombre de stations du réseau mondial de radiosondages, principale source directe d'information sur le profil vertical du vent jusqu'à maintenant, mais avec une répartition sur le globe plus homogène.

Couverture de données simulées Aeolus sur une période de 12 h. Image : CEPMMT (Michael Rennie)

La mission Aeolus sera un plein succès :

- si des données lidar sont finalement produites en temps réel sur une période proche de 3 ans,

- si elles s'avèrent suffisamment fiables et précises (d'après le monitoring du CEPMMT et des autres centres de prévision),

- si elles peuvent être assimilées dans un modèle en améliorant la prévision globale de manière significative.

Si la qualité des mesures de vent s'avère conforme aux spécifications attendues, l'impact d'Aeolus sur la qualité de la prévision devrait être sur l'hémisphère nord du même ordre que l'impact des vents de radiosondages. Sur l'hémisphère sud il devrait être au moins aussi important que sur l'hémisphère nord. On s'attend surtout à ce que l'impact soit très important dans les tropiques qui, contrairement aux régions extra-tropicales, ne permettent pas une bonne restitution du champ de vent à partir des observations de pression et température. Une fois qualifié pour améliorer la prévision globale, le lidar-vent spatial sera automatiquement qualifié pour améliorer les réanalyses climatiques.

La mission expérimentale Aeolus ne sera pas pérennisée, du moins pas tout de suite. Mais si elle est un plein succès, elle ouvrira la voie à plusieurs autres missions qui devraient permettre à partir des années 2020 ou 2030 de bien couvrir le globe en données de vent pleinement opérationnelles. En renforçant le nombre total d'observations et donc la couverture de données par rapport à Aeolus, on peut espérer une avancée majeure dans l'observation globale du vent, dans la qualité des prévisions et des réanalyses climatiques, du moins en ce qui concerne l'atmosphère. Concernant l'océan, l'apport potentiel d'Aeolus (et de ses successeurs éventuels) sera beaucoup plus faible car il ne peut être qu'indirect, via le couplage océan-atmosphère qui comprend une modélisation des deux couches limites (océanique et atmosphérique) et des différents flux allant de l'une à l'autre. Le vent à 10 m au-dessus de la surface océanique joue un rôle fondamental dans ce couplage. Il ne peut pas être observé directement par les instruments du type Aladin, mais son estimation sera améliorée dans une analyse ou une prévision à quelques heures ou quelques jours échéance par l'assimilation de mesures de vent obtenues à des altitudes plus élevées. Les mesures Aeolus sont des observations de grande échelle qui devraient surtout contribuer à mieux analyser les grandes ondes atmosphériques et donc à mieux analyser les systèmes tels que les tempêtes ou les cyclones en formation. Pour le vent à la surface de l'océan, on peut raisonnablement espérer une synergie au sein d'une assimilation entre les mesures de la rugosité océanique qui permettent de l'estimer à petite échelle et les mesures de lidar-vent (plus hautes dans l'atmosphère) qui permettent de l'estimer à grande échelle.

Au moment du lancement d'Aeolus, le 22 août 2018, plusieurs medias ont parlé de «méthode révolutionnaire pour observer l'atmosphère» dont on espérait qu'elle allait faire faire «un bond à la prévision du temps», pouvant par exemple «amener la prévision à 15 jours d'échéance au même niveau que la prévision actuelle à 7 jours». Ces termes peuvent peut-être représenter un objectif à long terme, à condition de bien les définir par des critères objectifs. Mais ils donnent aux non-spécialistes une vision beaucoup trop optimiste, en laissant croire que c'est le seul lancement d'Aeolus qui va permettre cela. Aeolus ouvrira peut-être une voie vers cela, mais par l'intermédiaire de nombreuses autres missions spatiales à venir, et conjointement avec toutes les autres sources potentielles de progrès pour la météo et le climat.

Aeolus : une contribution au système mondial d'observations parmi beaucoup d'autres

Le lien web de l'OMM (Organisation Météorologique Mondiale) donne une liste complète des satellites environnementaux actuels ou déjà programmés pour les années à venir. Il s'agit de plusieurs dizaines de satellites et de types d'instruments. Si l'on compte individuellement chaque instrument à l'intérieur d'un même type, on dépasse largement la centaine. Chaque année voit le lancement de plusieurs satellites servant peu ou prou les besoins de la météorologie et du climat, mais les données ne sont pas toutes disponibles en temps réel pour la météorologie opérationnelle.

L'automne 2017 a été riche en lancements de satellites : un satellite européen, un chinois et un américain.

Voir : la News "Automne 2017, plusieurs nouveaux satellites pour la météo et le climat".

Cette année 2018 a vu en mai le lancement de deux satellites« GRACE-FO » (GRACE Follow-On) documenté sur la News "Mise en orbite des deux satellites GRACE-Follow on"

La particularité de cette mission gravimétrique est de comprendre deux satellites jumeaux dont on mesure en permanence l'inter-distance.

Le 25 juillet a vu le lancement par Ariane-5 depuis Kourou de 4 nouveaux satellites Galileo, s'ajoutant aux 22 existants, dont 18 sont opérationnels. La constellation Galileo d'une trentaine de satellites devrait être complète en fin d'année 2019.

Deux satellites chinois ont été lancés :

- FY-2H, le 5 juin 2018, satellite géostationnaire dédié à la météorologie opérationnelle ;

- GF-11, le 31 juillet 2018, sur une orbite héliosynchrone, satellite dédié à l'observation des surfaces continentales à haute résolution.

Pour en savoir plus, taper le nom du satellite dans la case « Quick search » du site web OSCAR de l'OMM.

Le même site web donne une liste impressionnante de satellites devant être lancés avant la fin de l'année 2018.

Parmi eux citons :

- CFOSAT, satellite franco-chinois, dont le lancement est prévu en octobre, qui sera muni d'un diffusiomètre ;

- Metop-C, satellite européen, dont le lancement est prévu en novembre, qui sera muni de sa dizaine d'instruments volant actuellement sur Metop-A et Metop-B.

La vraie originalité d'Aeolus, c'est qu'il emporte le seul instrument capable de mesurer depuis l'espace des vents sur l'épaisseur de l'atmosphère, c'est-à-dire de fournir des profils verticaux de vent, un peu comme les radiosondages. Les dynamiciens de l'atmosphère savent que la connaissance du gradient vertical de vent (cisaillement) est un élément précurseur important pour anticiper le développement de phénomènes extrêmes (orages, tempêtes, cyclones).

Une fois en service, Aeolus pourra fournir directement ce type d'observation conjointement avec trois autres systèmes d'observation basés au sol :

- les radiosondages ;

- les profileurs (radars ou lidars fonctionnant à partir de stations) ;

- les observations d'avions au voisinage des aéroports.

Depuis l'espace, il existe d'autres mesures de vent, mais toujours obtenues à un niveau d'altitude unique.

Voir les FAQ :

Quelles observations pour estimer la température à la surface de la Terre?

Le vent à la surface de l'océan. Comment l'observer ? Comment l'estimer au mieux ?

Bibliographie

Dabas A., M.L. Denneulin, P. Flamant, C. Loth, A. Garnier, A. Dolfi-Bouteyre, 2008: Correcting winds measured with a Rayleigh Doppler lidar from pressure and temperature effects, Tellus, 60A, 206–215.

Mégie, G. and R. T. Menzies, 1980 : Complementarity of UV and IR differential absorption lidar for global measurements of atmospheric species. Appl. Opt., 19, 1173-1183.

Souprayen, C., A. Garnier, A. Hertzog, A. Hauchecorne and J. Porteneuve, 1999 : Rayleigh-Mie Doppler wind lidar for atmospheric measurements. I. Instrumental setup, validation, and first climatological results. Appl. Opt., 38, N°12.

Stoffelen, A., J. Pailleux, E. Källén, J.M. Vaughan, L. Isaksen, P. Flamant, W. Wergen, E. Andersson, H. Schyberg, A. Culoma, R. Meynart, M. Endemann, and P. Ingmann, 2005: The Atmospheric Dynamics Mission For Global Wind Field Measurement. Bull. Amer. Meteor. Soc., 86, 73–87.

Tan, D. G. H., E. Andersson, M. Fisher and L. Isaksen, 2007: Observing system impact assessment using a data assimilation ensemble technique: Application to the ADM-Aeolus wind profiling mission. Q. J. R. Meteorol. Soc., 133, 381-390.

Mai 2018

1/1 Mise en orbite des deux satellites GRACE-Follow On

Le 22 mai 2018, depuis la base de Vandenberg en Californie, deux nouveaux satellites scientifiques GRACE FO ainsi que cinq nouveaux éléments de la constellation Iridium Next ont été mis en orbite par la fusée réutilisable Falcon 9 de la société SpaceX.

Le 22 mai 2018, depuis la base de Vandenberg en Californie, deux nouveaux satellites scientifiques GRACE FO ainsi que cinq nouveaux éléments de la constellation Iridium Next ont été mis en orbite par la fusée réutilisable Falcon 9 de la société SpaceX.

Ces 2 satellites jumeaux de la mission GRACE-Follow On, sont le fruit d'une collaboration entre la NASA et le Centre de recherche allemand pour les géosciences (GFZ). Ils continueront à surveiller les changements dans le cycle de l'eau et la masse à la surface du globe, comme cela a été si bien réalisé par la première mission GRACE, ("Gravity Recovery And Climate Experiment"), mise en orbite en mars 2002, qui a fonctionné jusqu’en octobre 2017, une performance et une chance inouïe pour ce type de mission.

L’altitude de la mission GRACE-FO est celle d’une orbite quasi circulaire à 490 km et l’inclinaison du plan de la trajectoire sur l’équateur est de 89 degrés.

Voici quelques éléments, parmi les plus impressionnants, sur cette mission très remarquable :

Les missions de GRACE

Comme son prédécesseur, GRACE-FO suit les masses d'eau liquide ou gelée "grace"... à des mesures de haute précision des variations mensuelles du champ de gravité de la Terre. Chaque mission GRACE est composée de 2 satellites jumeaux. La connaissance ultraprécise de l'attraction terrestre et de ses variations, résulte de la mesure à mieux que quelques millièmes de mm de la distance, (environ 200 km), entre les 2 engins en orbite. Plus de 99% de l'attraction gravitationnelle de notre planète ne change pas d'un mois à l'autre, car elle représente la masse de la Terre solide elle-même. Mais une infime fraction de la masse terrestre est constamment en mouvement, et c'est surtout de l'eau : la pluie tombe, la rosée s'évapore, les courants océaniques coulent, la glace fond et ainsi de suite.

Les cartes de GRACE montrant les variations régionales de la gravité nous montrent où se déplace chaque mois cette petite fraction de la masse planétaire globale.

Anomalie de champ de gravité au niveau des continents de 2002 à 2009 (Source NASA)

Anomalie de champ de gravité au niveau des continents de 2002 à 2009 (Source NASA)

Anomalie de champ de gravité des océans de 2002 à 2009 (Source NASA)

Anomalie de champ de gravité des océans de 2002 à 2009 (Source NASA)

Nota : La plupart des anomalies de gravité étant dues au mouvement de l'eau autour de la surface de la Terre, la NASA exprime ces variations comme l'épaisseur d'une couche d'eau qui entraînerait une telle anomalie de gravité. Les mesures sont en termes de centimètres d'eau équivalente, ou CM-eq-H2O.

Deux satellites, un instrument

Contrairement aux autres satellites d'observation de la Terre, qui portent des instruments qui observent une partie du spectre électromagnétique, les deux satellites de GRACE-Follow On sont eux-mêmes l'instrument qui effectue des mesures entre-eux.

L'instrument principal mesure les minuscules changements dans la distance entre les deux, qui proviennent des forces gravitationnelles légèrement variables, d'un mois à l'autre, en fonction des changements de la répartition des masses en surface ou souterraines, proches de la surface. Cette distance, variable continûment, est mesurée à partir de signaux micro-onde émis et reçus entre les deux satellites jumeaux comme dans la première mission Grace - KBR instrument (K/Ka-Band Ranging) -. Dans la mission GRACE-FO, un système expérimental nouveau et supplémentaire beaucoup plus précis (au moins d’un facteur 10) a été mis en place ; il est fondé sur l'interférométrie de signaux laser émis entre les deux satellites - LRI instrument (Laser Ranging Interferometer) -.

Les chercheurs, géodésiens & hydrologues, produisent des cartes mensuelles de l'eau et du changement de masse en combinant ces informations avec des mesures GPS de l'endroit exact où se trouvent les satellites et des mesures accélérométriques d'autres forces agissant sur l'engin spatial, telles que la traînée atmosphérique.

Le traitement des données géophysiques pour déterminer précisément chaque mois un modèle de champ de gravité de la Terre implique nécessairement l’utilisation des données de distances laser obtenues régulièrement sur les satellites Lageos à 6 000 km d’altitude qui donnent spécifiquement la position du centre de masse de la Terre et ses variations temporelles ainsi que l’aplatissement géodynamique de la Terre avec ses variations temporelles. Ces grandeurs ne pourraient être déterminées avec précision par les seules données de Grace-FO.

Les micro accéléromètres ultra précis utilisés pour mesurer les forces non-gravitationnelles agissant sur les satellites ont été construits et réalisés en France par l’ONERA, une compétence unique au plan mondial.

Pour en savoir plus, sites à consulter :

OSCAR, Fiche technique sur GRACE-FO

Février 2018

1/1 L’année climatique 2017

Bruno Voituriez

C’est le 30e anniversaire du protocole de Kyoto, premier accord international destiné à s’attaquer au réchauffement climatique, en demandant aux États de réduire leurs émissions de gaz à effet de serre et de prendre des engagements pour ce faire.

Il a été adopté lors de la COP n°3 le 11 décembre 1997. COP signifie : Conference of Parties to United Nations Framework, Convention on Climate Change ( UNFCC ). Cette convention issue du sommet de la Terre de Rio de 1992 entre en action en 1994, et la première COP se réunit l’année suivante en 1995 à Berlin. En 1997, la COP 3 adopte le protocole de Kyoto. Les COP's se réunissent tous les ans depuis 1995. Le Groupe d’experts intergouvernemental sur l’évolution du climat (GIEC) a été créé en 1988 en vue de fournir des évaluations détaillées de l’état des connaissances scientifiques, techniques et socio-économiques sur les changements climatiques, leurs causes, leurs répercussions potentielles et les stratégies de parade. Les COP’s s'en nourrissent.

La COP 21, dont on a beaucoup parlé, s’est tenue à Paris en 2015. La conférence de Paris connut au moins un succès : l'adoption d’un nouvel accord "Accord de Paris" pour succéder au protocole de Kyoto qui devait arriver à échéance en 2012. La COP 15 de Copenhague en 2009 devait préparer le nouveau protocole appelé à prendre la suite de celui de Kyoto. Ce fut un échec total. Les discussions reprirent à DOHA à la COP 18 de 2012 et finalement accord il y eut pour un nouveau traité à Paris en 2015. L’échec de Copenhague était formellement effacé. Quant au fond de ce nouveau traité et de ses objectifs à atteindre, on peut avoir des doutes. De tels accords entre 195 états ne peuvent s’obtenir sans concession et l’acceptation d’objectifs que l’on sait illusoires comme par exemple celui de ne pas dépasser 1.5°C d’augmentation ( voir news de février de 20I6 ) par rapport à l’époque préindustrielle…

Mais là n’est pas le sujet, et il est question de parler du climat de l’année 2017 et de sa position dans l’évolution du climat : une marche en plus ou une marche en moins ?

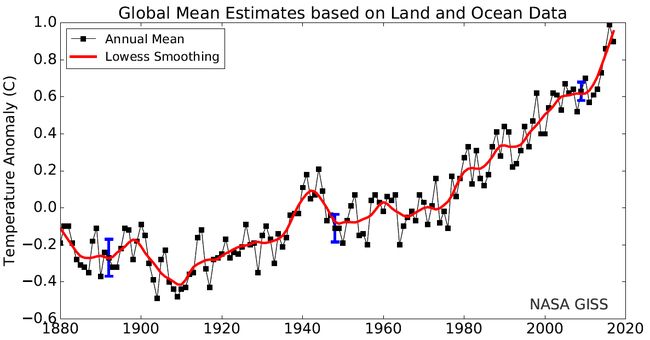

Fig 1 : Évolution de la température depuis 1880

Selon la NASA et la NOAA qui ont présenté le 18 janvier 2018 le bilan climatique, 2017 fait partie des 3 (vraisemblablement 2) années les plus chaudes depuis 1880 avec une augmentation de 0.9°C par rapport à la moyenne 1951-1980 contre 0.99 pour 2016. À ce rythme là, où en seront nous en 2100 avec l’accroissement visé par le traité de Paris de 1.5°C par rapport à l’ère préindustrielle ? Depuis le protocole de Kyoto en 1997 il y 30 ans, la température a augmenté de 0.5°C et elle ne cesse de croître. Tout se passe comme si les trains politique et scientifique circulaient sur des voies divergentes en dépit du synchronisateur que le Giec devrait être pour les faire converger.

El Niño

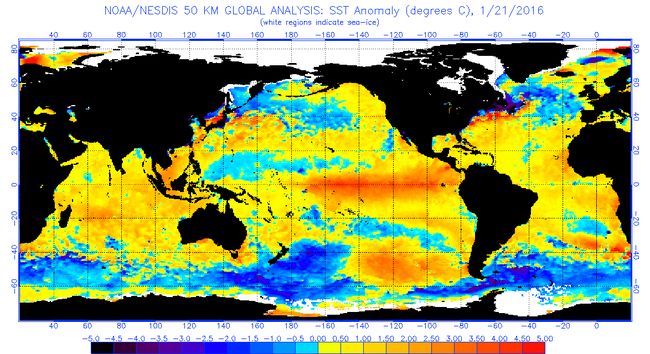

Les trois dernières années successives 2015, 2016, 2017 furent donc les plus chaudes depuis 1880. Rien de surprenant à cela pour 2015 et 2016 puisqu’un puissant El Niño démarra fin 2015 ( fig 2 ) et couvrit toute l’année 2016 et que l’on sait que les années les plus chaudes correspondent à des El Niño puissants.

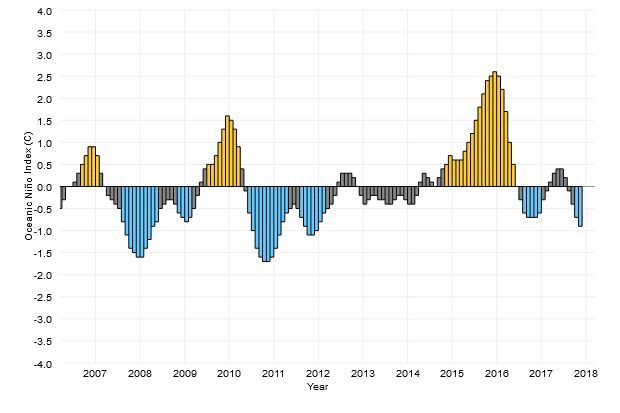

Fig 2 : L’indice océanique ENSO : l’année 2017 est dans le neutre, ni Niño, ni Niña

L’année 2017 détient donc un record : l’année la plus chaude sans EL Niño. Selon la NASA, globalement El Niño valut 0.04°C supplémentaires en 2015, 0.12°C pour 2016 et 0.00°C pour 2017. Fantaisie de celui que l’on appelle maintenant souvent dans la presse, selon l’ humeur, l’enfant terrible ou turbulent alors qu’à l’origine le phénomène doit son nom Niño a à l’enfant Jésus… ou changement de régime qui hisse le réchauffement global au niveau d’El Niño ? L’avenir le dira ! Car de nouvelles anomalies ou changements d’équilibre sont à attendre au fur et à mesure que la température augmente. Pour 2017, comme elle le fait toujours, la NOAA s’efforce de prévoir à un an l’évolution d’ENSO (El Niño Southern oscillation) et en discute. Le 8 janvier 2015 la NOAA concluait pour 2016 :

« In summary, there is an approximately 50-60% chance of weak El Niño conditions during the next two months, with ENSO-neutral favored thereafter »

Résultat, l’El Niño qui s’est développé en 2016 a été le plus important depuis celui de 1998 qui n’avait pas été prévu non plus, comme aucun autre d’ailleurs. La compréhension du climat et de son changement repose sur l'identification de grandes oscillations du système couplé Océan Atmosphère dont la plus célèbre est "l'EL Nino Southern Oscillation" (ENSO). On ne sait pas encore prévoir correctement leur évolution, ce qui est préoccupant, car réchauffement aidant, les oscillations type ENSO combinées à d’autres peuvent provoquer de nouvelles perturbations ( voir plus loin les glaces de l’Arctique ). Aux échelles régionales, l’année 2017 ( fig 3 ) ne montre pas de différences significatives avec l’année 2016 ( fig 1 ) du bilan de 2016.

Fig 3 : Anomalie de température 2017 par rapport à la période 1950-1951

Le contenu thermique de l’ océan

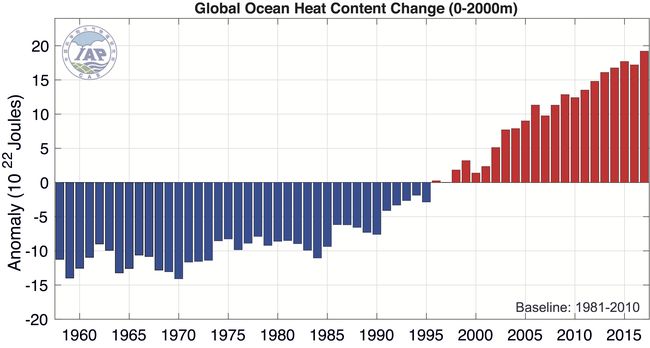

L’océan absorbe plus de 90 % de la chaleur en excès générée par l’augmentation de l’effet de serre ; sa température et son contenu thermique augmentent donc ( fig 4 ).

Fig 4 : Évolution du contenu thermique des 2000 premiers mètres de l’océan depuis 1958

L’année 2017 représente un record depuis 1958. Elle dépasse l’année Niño 2016 qui la précède, de même que l'année 1999 affiche un contenu thermique de l’océan supérieur à celui de l’année Niño 1998. Cela peut surprendre alors qu’El Niño se caractérise par un très fort réchauffement de l’Océan Pacifique équatorial. Mais cet océan équatorial ne fait pas la totalité de l’océan, et dans les faits, il s’agit pour l’océan d’un transport d’eau chaude de l’ouest vers l’est du Pacifque équatorial. Cette redistribution de chaleur concerne l’ensemble du globe et sur la fig 5, on voit qu’à côté du réchauffement bien visible dans le Pacifique ( au niveau de l’équateur ), il y a de nombreuses zones de refroidissement susceptibles de capter plus de chaleur à l’issue d’El Niño.

Fig 5 : Anomalie de la température de surface en janvier 2016 ( Niño )

Une chose est certaine : au-delà de variabilités interannuelles, globalement l’océan et l’atmosphère ne cessent de se réchauffer. Pour en juger, les mesures sont essentielles. En décembre 2017, il y avait 3878 balises ARGOS opérationnelles. C’est 100 en moins qu’en janvier 2017.

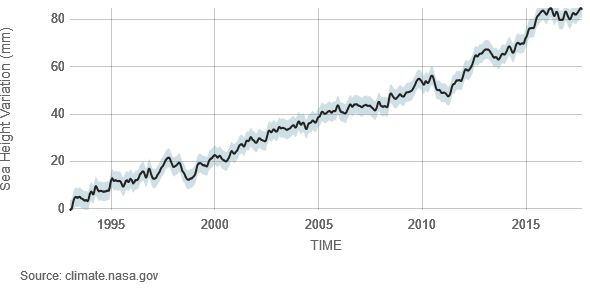

Le Niveau de la mer

Il monte incontestablement au rythme assez régulier, au niveau global, de 3.32 mm/an. Comme à l’habitude, Niño 2015-2016 se marque par un maximum relatif du niveau de la mer qui n’affecte pas l’augmentation de 84.1 mm depuis le lancement du satellite altimétrique Topex/Poseidon en 1992 ( fig 6 ).

Fig 6 : Évolution du niveau de la mer depuis le lancement du satellite Topex/Pseidon en 1992

L’Arctique

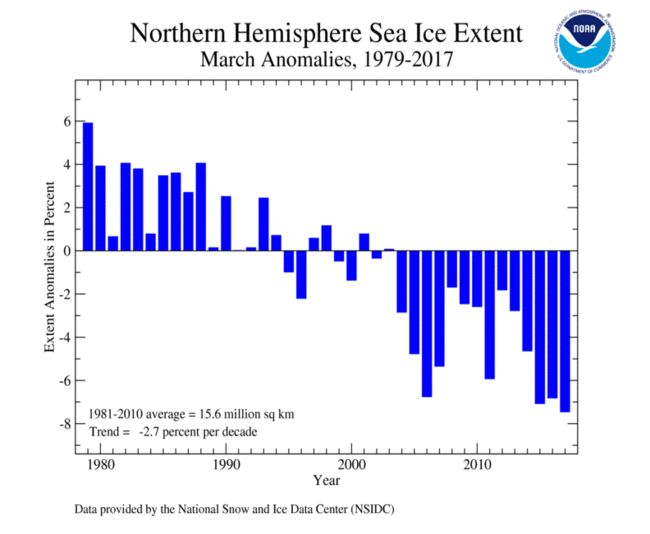

Comme à l’accoutumée, la banquise arctique a atteint son extension maximum en mars 2017, le 7 précisément, et son minimum en septembre 2017, le 13 ( fig 7 et 8 ).

Fig 7 : L’extension de la glace arctique à son maximum, le 7 mars 2017

Fig 8 : L’extension de la glace arctique à son minimum, le 13 septembre 2017

La valeur moyenne de mars fut de 14.43 millions de km2, soit 7.5 % de moins que la moyenne annuelle sur 1981- 2010. C’est la plus faible extension observée en mars. Avec 14.49 km2, 2015 n’était pas loin ( fig 9 ).

Fig 9 : Évolution dans l’hémisphère nord, en mars à son maximum de l’extension de la glace (anomalie par rapport à 1979/2017). Mars 2017 marque un record de réduction.

La glace atteignit son extension minimum le 13 septembre, 4.64 millions de km2. C’est la 8e extension minimum (mesures satellitaires selon NSIDC) ( fig 10 ).

Fig 10 : Évolution dans l’hémisphère nord en septembre, à son minimum, de l’extension de la glace (anomalie par rapport à 1979/2017. L’année 2012 garde son record.

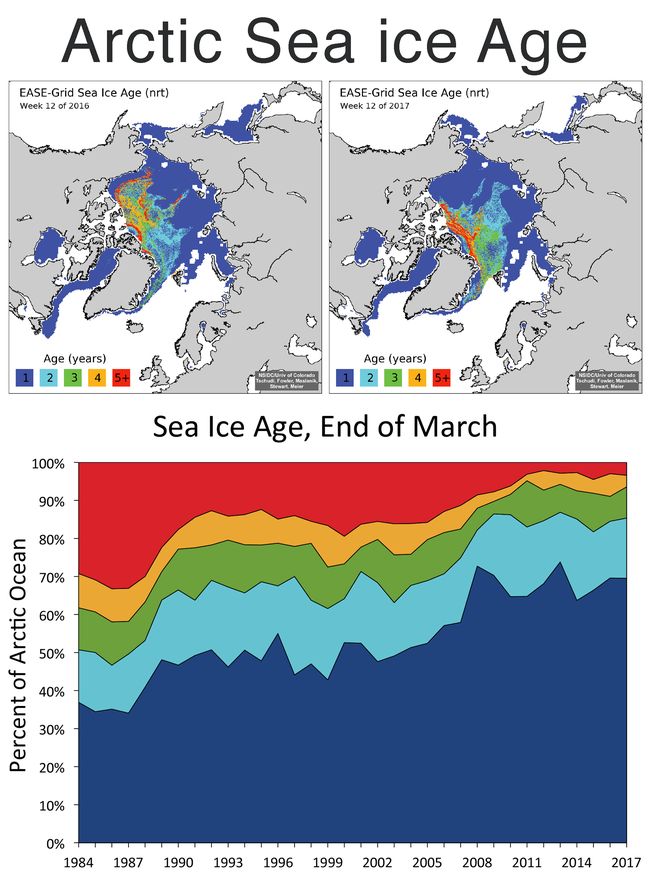

L’extension en mars, période du maximum, diminue de 2.7 % par décennie. L’extension de la glace est un indicateur important de l’évolution du climat, mais l’âge de la glace ( depuis l’année où elle s’est formée ) qui est corrélée à son épaisseur et donc à sa masse, est sans doute plus significative : moins il y a de glace plus rapidement elle fond. Sur la fig 11, on voit peu de différence entre 2016 et 2017, mais il est clair que la glace de 1re année ( l’année en cours qui fond quasi totalement ) est de plus en plus importante et représente 70 % de l’extension totale, alors que la glace de 5e année est passée de 30 % de la surface en 1984 à quelques pourcents en 2017. C’est manifestement sur l’Arctique que le réchauffement climatique, sur l’atmosphère et sur l’océan, à son effet le plus marqué.

Fig 11 : L’âge de la glace en mars dans l’Arctique. En haut, comparaison 2016/2017. En bas, évolution de 1984 à 2017.

L’Antarctique

Fig 12 : Évolution dans l’Antarctique de la glace à son maximum en Mars. La glace a repris sa décroissance.

Dans les années 2000/2010, la surface de la banquise antarctique avait curieusement une tendance à s'accroître au moment de son extension maximum de septembre qui atteignit sa valeur la plus élevée en 2014 : 20.12 millions de km2. En 2015 et 2016, la décroissance reprit et l’extension de la banquise repassa sous la moyenne 1979/2010. En septembre 2017, elle fut de 18.3 millions de km2 soit 4.5 % sous la moyenne 1981-2010. Dans une news de 2015, on expliquait cet accroissement de la banquise de la manière suivante : le renforcement des vents d’ouest autour du continent induit un accroissement vers le nord du transport d’Ekman de la glace et des eaux froides de surface depuis le continent Antarctique, ce qui facilite la formation de glace. Les modifications induites par le changement climatique dans le champ de pression atmosphérique peuvent y avoir leur part, mais on suspecte surtout la diminution depuis la fin des années 1970 de l’ozone au-dessus de l’Antarctique, « le trou d’ozone », qui modifie de manière importante l’équilibre radiatif de la stratosphère. Dans les années à venir ce déficit d’ozone devrait se résorber, atténuant ce phénomène de refroidissement des eaux de surface et contribuant à une augmentation de l’effet de serre… Peut-être cette hypothèse est–elle validée par les trois dernières années…

Le gaz carbonique dans l’atmosphère

Comme les autres paramètres, les teneurs de l’atmosphère en gaz carbonique, principal gaz à effet de serre, poursuit son évolution avec régularité ( fig 13 ), en respectant les cycles biologiques du monde vivant et sans faiblir. En 2016 et 2017, la teneur de l’atmosphère a toujours été au-delà de 400 ppm ( fig 13 ).

Fig 13 : Évolution des teneurs en CO2 de l’atmosphère mesurées à l’observatoire de Mauna Loa

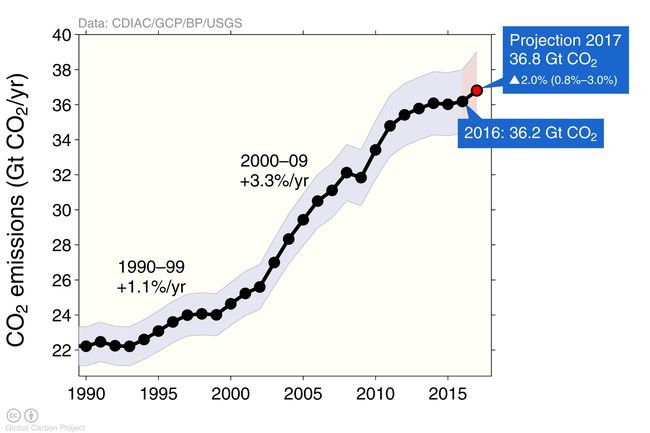

Le 27 janvier 2018, cette teneur était de 407.87 ppm. Et pourtant, il y eut une bouffée d’espoir, car les émissions diminuèrent légèrement en 2015 : 35.7 Gt de CO2 en 2015, contre 35.9 en 2014. Cela ne dura point, on était à 36.3 en 2016 et 36.4 en 2017… la croissance reprend ( fig 14 ).

Fig 14 : Évolution des émissions de CO2 dont la croissance a repris après une timide tentative de diminution en 2015

Conclusion

On serait tenter de dire que l’évolution climatique suit son cours régulièrement et sans surprise au rythme des activités humaines, dans un système globalement stable. Le « globalement stable » est important. En effet, ce n’est pas au niveau global que se situent actuellement les difficultés mais bien dans l’accroissement local des événements climatiques extrêmes et de leur intensité.

On a parlé du cyclone Irma le plus puissant dans l’Atlantique depuis 1980, qui a dévasté les Antilles (Saint Martin et Saint Barthelemy), en compagnie du cyclone José qui le suivait ainsi que la tempête Katia en septembre, du cyclone Maria en octobre à la Dominique, aux îles Vierges, Porto Rico.

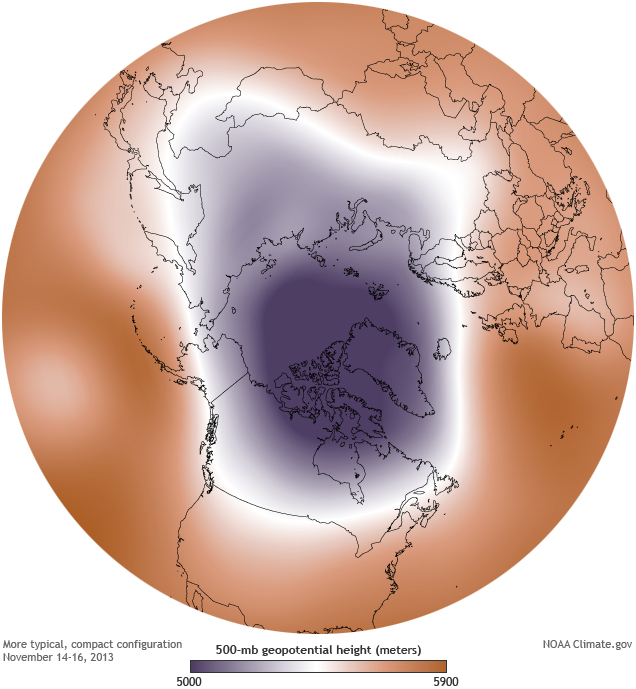

Nombreuses et catastrophiques ont été les inondations. Il y a certes de tels événements depuis toujours mais à ces échelles, ils présentent l’inconvénient d’être quasiment imprévisibles. Ils restent néanmoins dans un système stable de climat que nous connaissons, mais qui pourrait ne pas durer. Un exemple en a été donné en 2017-18 qui a bien fait rire M. Trump, confronté début janvier 2018 à une vague de froid au nord des USA et aussi au Canada alors que l’on cherche à le convaincre de la réalité du réchauffement climatique qui ne le préoccupe pas. Il s’agit en quelque sorte de la désintégration du Vortex Polaire (qui fera bientôt sur ce site l’objet d’une communication importante). Le pôle Nord est une zone de basse pression autour de laquelle des vents très violents tournent dans le sens contraire des aiguilles d’une montre dans la haute atmosphère et la stratosphère. Dans les conditions normales le vortex bien formé autour du pôle contient bien l’air froid et l’empêche de descendre vers les plus basses latitudes ( fig 15 ).

Fig 15 : Le vortex polaire bien établi en novembre 2013 sur le pôle. Zone de basse pression autour duquel tourne le vent qui confine le plus grand froid.

S'il y a réchauffement, le vortex se disloque et l’air froid peut s’échapper jusqu’à des latitudes tempérées. Ce qui est arrivé fin 2017/début 2018 et en 2013/14 ( fig 16 ).

Fig 16 : Le vortex polaire de basse pression éclaté en plusieurs morceaux qui libèrent l’air froid qui peut ainsi descendre vers les latitudes moyennes.

La disparition de la banquise et le réchauffement de l’Arctique auquel EL Niño n’est pas étranger favorise cette dislocation, et il n’est pas exclus qu’à terme et peut-être brutalement les circulations atmosphérique et stratosphérique soient durablement perturbées perdant toute stabilité, préalable peut-être à un véritablement changement de système climatique.