Décembre 2017

1/1 Automne 2017 : plusieurs nouveaux satellites pour la météo et le climat

Jean Pailleux

Sentinel-5P et la chimie atmosphérique

Le 13 octobre 2017, le satellite européen Sentinel-5P (de l'ESA) a été lancé avec succès depuis la base de Plesetsk, dans le nord de la Russie. La mission principale des satellites Sentinel-5 (dont Sentinel-5P est le précurseur) concerne la chimie atmosphérique : mesurer la concentration de nombreux gaz atmosphériques et des aérosols, en appui des applications de surveillance de la qualité de l'air et de l'évolution du climat. Pour prolonger Sentinel-5P dans les prochaines années, c'est le satellite METOP (Seconde Génération) qui embarquera les instruments de la mission Sentinel-5 (convergence des missions européennes METOP et Sentinel-5, opérées par EUMETSAT).

Sentinel-5P est placée sur une orbite héliosynchrone (nœud ascendant : 13h30) à 824km d'altitude. Son instrument TROPOMI (Tropospheric Monitoring Instrument) est un ensemble de spectromètres destinés à fournir des mesures de la composition atmosphérique, en particulier des gaz à effet de serre tels que le gaz carbonique et le méthane. Il va permettre d'avoir une couverture globale en observations de dioxyde d'azote (NO2), un polluant clé pour la chimie atmosphérique, avec une résolution nettement améliorée.

Pour une information complète sur les mesures de cet instrument, voir la page TROPOMI du site OSCAR de L'Organisation Météorologiqie Mondiale.

Tous les centres opérant des modèles globaux de chimie atmosphériques sont appelés à utiliser en temps réel les observations de ce satellite. Les mesures de Sentinel-5P sont essentielles en particulier pour le programme européen CAMS (Copernicus Atmospheric Monitoring Service) qui est opéré par le CEPMMT (Centre Européen de Prévision Météorologique à Moyen Terme).

Image d'artiste du satellite Sentinel-5P (Source : ESA/ATG medialab)

JPSS-1 (alias NOAA-20) pour la météorologie et le climat

Le 18 novembre 2017, le satellite américain JPSS-1 (1er de la série «Joint Polar Satellite System») a été lancé avec succès depuis la base de Vandenberg, en Californie. Renommé officiellement «NOAA-20» après sa mise en orbite, il prolonge la série NOAA de satellites météorologiques opérationnels, vieille de plus de quarante ans, mais maintenant équipée des instruments les plus modernes. Certains de ces instruments contribuent de façon significative à la chimie atmosphérique ainsi qu'à l'observation de l'ionosphère.

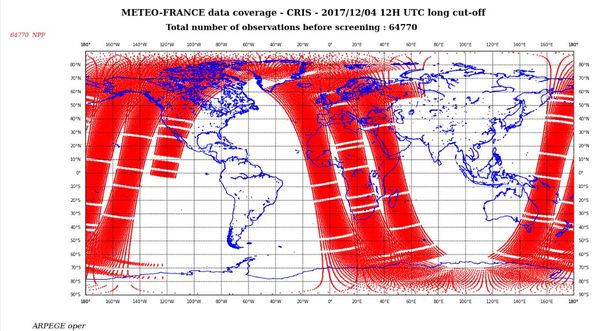

NOAA-20 est placée sur une orbite héliosynchrone (nœud ascendant : 13h30) à 824km d'altitude, la même orbite que Sentinel-5P. Le choix des orbites héliosynchrones de NOAA-20, de METOP (nœud descendant : 9h30) et du satellite de la Défense américaine DMSP (nœud descendant : 5h30) a été fait de façon à optimiser la couverture globale de données, du moins pour les sondeurs et imageurs qui sont embarqués sur ces trois types de satellite. Pour NOAA-20, citons en particulier le sondeur infra-rouge CRIS qui fournit des données très semblables à celles de l'instrument IASI sur METOP. La couverture de données CRIS, ici illustrée pour le satellite SNPP (Suomi NPOESS Preparation Programme – le précurseur de NOAA-20), devrait être très semblable pour ce nouveau satellite.

Données obtenues à Météo-France à partir du sondeur CRIS du satellite américain SNPP, le 4 décembre 2017, pour la période de 6h allant de 9h à 15h UTC. On attend une couverture semblable pour NOAA-20 qui est sur la même orbite. Source : Météo-France

Données obtenues à Météo-France à partir du sondeur CRIS du satellite américain SNPP, le 4 décembre 2017, pour la période de 6h allant de 9h à 15h UTC. On attend une couverture semblable pour NOAA-20 qui est sur la même orbite. Source : Météo-France

L'ensemble des instruments de NOAA-20 est décrit sur le site OSCAR de L'Organisation Météorologiqie Mondiale.

Le sondeur micro-onde ATMS et l'imageur infra-rouge VIIRS sont semblables aux instruments ayant déjà volé sur d'autres satellites et largement utilisés en prévision numérique du temps comme dans les réanalyses.

D'autres capteurs sont relativement nouveaux, par exemple :

- l'instrument OMPS (Ozone Mapping and Profiler Suite) qui permet de mesurer des concentrations de gaz (O3, NO2, SO2,etc...) ;

- les instruments « SEM... » conçus pour observer l'ionosphère et surveiller la «météo de l'espace».

Image d'artiste du satellite NOAA-20 (alias JPSS-1). Source : NOAA/NESDIS

Image d'artiste du satellite NOAA-20 (alias JPSS-1). Source : NOAA/NESDIS

Pour en savoir plus sur NOAA-20 et l'ensemble des satellites de cette série, voir par exemple le site de la NOAA.

Le satellite chinois FY-3D

Le 14 novembre 2017, le satellite chinois FY-3D (4e de la série Feng-Yu-3) a été lancé avec succès depuis la base chinoise de Taiyuan.

Ses multiples instruments en font un satellite assez semblable aux satellites européens METOP et aux satellites américains JPSS. Comme ces derniers, sa mission principale est la météorologie opérationnelle, avec aussi une contribution importante à la chimie atmosphérique et à la météo de l'espace (ionosphère).

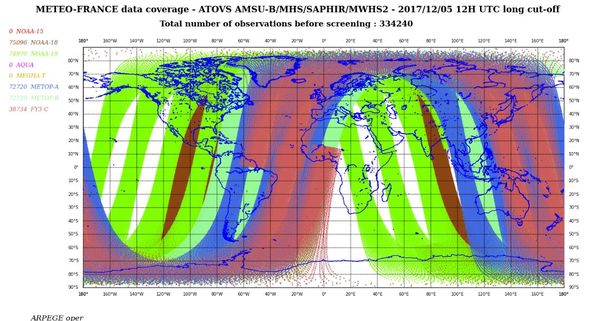

Placé à 836km d'altitude sur une orbite héliosynchrone (nœud ascendant 14h00), FY-4D est aussi très proche de JPSS-1 par son orbite et donc par sa couverture de données. Son prédécesseur, FY-3C (le 3e de la série) est le premier satellite chinois dont les données ont commencé à être utilisées dans l'assimilation globale de Météo-France. La carte jointe montre en couleur mauve les données de l'instrument micro-onde MWHS2 disponibles à Météo-France à partir du satellite FY-3C dont l'orbite est très proche de celle de METOP (couleur bleue).

Données obtenues à Météo-France le 5 décembre 2017 à partir des sondeurs micro-onde (canaux sensibles à l'humidité atmosphérique uniquement) embarqués sur divers satellites héliosynchrones, pour la période de 6h allant de 9h à 15h UTC. Le satellite FY-3C et son instrument MWHS2 apparaît en couleur mauve.On attend une couverture semblable pour FY-4D mais sur une orbite héliosynchrone décalée d'environ 4h. Source : Météo-France.

Les différents instruments de FY-3D sont documentés sur le site OSCAR de L'Organisation Météorologiqie Mondiale.

Notons le sondeur infra-rouge HIRAS dont la fiche descriptive (accessible à partir du lien précédent) marque un saut technologique par rapport à son prédécesseur IRAS (sur FY-3C). Notons aussi que, comme METOP et contrairement à NOAA-20, FY-3D dispose d'un récepteur GNSS (appelé GNOS) qui permettra d'obtenir des données météorologiques de radio-occultation.

Perspectives pour 2018

On trouve une liste exhaustive des satellites d'observation de la Terre récemment lancés et à lancer prochainement sur le site OSCAR de L'Organisation Météorologiqie Mondiale.

Mis sur orbite à l'automne 2017 on peut noter un satellite marocain (Mohammed-VI-A) ainsi que deux satellites de la série américaine SkySat. Ils sont équipés d'imageurs pour observer la surface terrestre à haute résolution dans le visible et l'infra-rouge.

Sous l'onglet «Planned launches 20xx» (colonne de droite du lien web), on note que le satellite japonais GCOM-C1 doit être lancé le 23 décembre 2017 : sur une orbite polaire héliosynchrone, son imageur SGLI est prévu surtout pour obtenir des données relatives à la couleur de l'océan, à la végétation et aux aérosols. Dans la série européenne du programme Copernicus, le lancement de Sentinel-3B (surfaces océanique et continentale) est prévu au printemps 2018.

2018 devrait voir le lancement de la 2e constellation COSMIC de 6 satellites équipés de récepteurs GNSS, la première constellation, maintenant en fin de vie, ayant fait ses preuves en matière de fourniture opérationnelle de données de radio-occultation, observations très efficaces pour documenter la structure verticale de la température et de l'humidité atmosphérique à grande échelle.

La fin 2018 devrait enfin voir le lancement du satellite européen ADM-AEOLUS : mission expérimentale de l'ESA destinée à obtenir à partir d'un lidar embarqué des observations de profils verticaux de vent. Si cette mission (purement exploratoire) s'avère couronnée de succès, ce sera la première fois que l'on observera depuis l'espace la structure verticale du vent. ADM-AEOLUS ouvrira alors la voie à d'autres missions «lidar vent» destinées à l'observation opérationnelle du vent global. En effet jusqu'à présent les satellites n'ont pu obtenir des observations de vent qu'à quelques niveaux dans l'atmosphère : la surface des océans, le sommet de la couche limite, la tropopause... Jusqu'à présent les seules observations directes permettant de caractériser la structure verticale du vent sont les radiosondages (ballons-sondes), les mesures d'avion au-dessus des aéroports et les réseaux de profileurs (télédétection à partir du sol).

Voir le site OSCAR.

Enfin, concernant l'observation du vent, notons la mission exploratoire de la NASA CYGNSS (Cyclone Global Navigation Satellite System). Il s'agit d'une constellation de 8 micro-satellites lancés en décembre 2016 . Les satellites sont équipés de récepteurs GPS mis en œuvre de façon à restituer le vent à partir de la rugosité de l'océan, en ciblant particulièrement les zones océaniques sous les cyclones tropicaux.

Voir le site OSCAR.

Novembre 2017

1/1 Incendies de forêt et changement climatique

Yves Dandonneau

Des incendies ravageurs en Californie, en Espagne, au Portugal, avec de nombreuses victimes : cette première quinzaine d'octobre 2017 paraît exceptionnelle. Elle suit de peu une série mouvementée de cyclones dans l'Atlantique tropical, pour lesquels le rôle amplificateur du changement climatique a été évoqué. Pour les incendies, il semble naturel aussi de s'interroger sur son rôle possible.

Des incendies ravageurs en Californie, en Espagne, au Portugal, avec de nombreuses victimes : cette première quinzaine d'octobre 2017 paraît exceptionnelle. Elle suit de peu une série mouvementée de cyclones dans l'Atlantique tropical, pour lesquels le rôle amplificateur du changement climatique a été évoqué. Pour les incendies, il semble naturel aussi de s'interroger sur son rôle possible.

En effet, le déclenchement et la progression des incendies de forêt sont favorisés par une végétation sèche, surtout si celle-ci est abondante. Or, avec le réchauffement climatique, les conditions qui favorisent les incendies tendent à se renforcer.

D'une part, selon le 5e rapport du GIEC, on observe une tendance à l'augmentation du risque d'épisodes de sécheresse et de leur durée dans les climats de type méditerranéen.

D'autre part, on observe aussi une hausse des températures et un risque accru de canicule.

Sous cette double influence, la végétation subit des pertes en eau qui peuvent entraîner la dessiccation du feuillage, voire son dépérissement. Certaines forêts offrent alors, répartie sur plusieurs mètres de hauteur, une abondante biomasse inflammable dans laquelle le feu se propage très vite et devient très difficile à arrêter. Ceci, certainement, a favorisé les récents incendies qui ont frappé la Californie, le sud de la France, le Portugal, l'Espagne, et la Grèce.

En Californie, une étude récente a montré que le changement climatique dû aux activités humaines était responsable de la moité des dégâts causés par les incendies de ces dernières années, et a aussi montré que chaleur et sécheresse ne suffisaient pas à expliquer l'ampleur des feux : les pluies d'hiver y ont aussi favorisé une croissance exubérante des plantes herbacées qui, devenues sèches en été, ont constitué le carburant très inflammable grâce auquel le feu s'est propagé très vite.

Ces conditions sont régulièrement remplies sous les climats tropicaux où une saison sèche alterne avec une saison des pluies, comme dans les savanes africaines où les feux de brousse annuels étaient une pratique pastorale. À l'inverse, on voit bien que les régions semi-arides ne sont pas touchées par de grands incendies. Le déclenchement des incendies dépend donc d'un dosage adapté de chaleur, de sécheresse, et de croissance végétale, conditions sur lesquelles le changement climatique influe de manière différente selon les régions considérées.

Annuler le changement climatique, si c'était possible, ne résoudrait donc pas partout uniformément le risque : le développement des villes et des infrastructures, l'extension des zones habitées, sont une autre cause, très importante, de l'augmentation du risque d'incendies de forêts, en multipliant les départs de feu, accidentels ou criminels. Notons aussi que l'éparpillement d'habitations en milieux sensibles cause davantage de victimes.

S'organiser pour mieux faire face à cette menace est donc nécessaire. Ceci passe par une gestion adaptée des forêts, en utilisant des moyens tels que le choix d'espèces plus résistantes à la sécheresse et moins propices à la propagation des feux (à ce titre, l'abondance des plantations d'eucalyptus au Portugal a été un facteur aggravant), le nettoyage des sous-bois, la pratique de contre-feux, l'aménagement de coupe-feux et de systèmes de surveillance. Grâce à de telles mesures, quoi qu'en laisse penser la profusion d'information, force est de reconnaître qu'autrefois, les incendies ravageaient des étendues souvent plus grandes qu'aujourd'hui. Ainsi, le risque d'incendie dans la forêt des Landes n'a pas disparu, mais le terrible incendie de 1949 qui avait tué 82 personnes ne s'y est pas reproduit depuis la mise en place d'aménagements appropriés.

Il sera cependant difficile de supprimer tous les risques. En particulier, les zones de montagne sont et resteront très difficiles à protéger, en raison des difficultés d'intervention et de la vitesse à laquelle le feu peut s'y propager.

Dans un livre récent, «Firestorm - How Wildfire Will Shape Our Future», Edward Struzik analyse l'évolution du risque d'incendie, ses causes et ses remèdes. De façon inattendue, il fait remarquer qu'en l'absence de toute mesure prise pour limiter le risque, aucun responsable ne sera désigné si un incendie survient. Au contraire, celui qui mettra en application des mesures de précaution risque, après un incendie, de voir son action critiquée. Ceci encourage à considérer ces catastrophes comme une sorte de fatalité et favorise l'inaction. Compte tenu de l'omniprésence de l'homme dans tous les milieux, de l'accroissement des risques de sécheresse dans certaines régions du globe, et de la difficulté à réduire les risques d'incendies de forêt, il est probable que ceux-ci persisteront, avec leur cortège de dévastations et de victimes.

Il est une autre conséquence de ces incendies dont on a peu parlé en cette fin d'été 2017 : il s'agit des émissions de gaz carbonique auxquelles ils donnent lieu. L'agence américaine NASA a récemment observé que l'événement El Niño de 2015-2016 avait entraîné une sécheresse exceptionnelle en Indonésie à la suite de laquelle s'étaient développés des feux de forêt gigantesques, qui sont une des causes de l'accroissement de 3 ppm de la concentration en gaz carbonique de l'atmosphère en 2016, au lieu des 2 ppm environ observés chaque année au rythme de nos émissions actuelles. C'est ce qui s'était passé aussi avec la même conséquence à la suite des El Niño de 1982-1983, et de 1997-1998.

Mais c'est surtout aux hautes latitudes que cette menace est inquiétante. D'immenses espaces de forêt brûlent dans l'ouest du Canada, où une pullulation d'insectes mangeurs de bois a causé la mort de très nombreux arbres qui, dans un contexte de sécheresse persistante, alimentent des feux qui se propagent dans des régions peu habitées.

Plus préoccupant encore est l'incendie qui s'est développé au Groenland en 2017 : celui-ci, qu'incontestablement on peut imputer à la sécheresse et à une température exceptionnellement élevée, ne brûle pas seulement la végétation, qui y est rase et rabougrie. Il se développe dans l'immense réservoir de carbone qu'y constituent les tourbières. Or, la matière organique de la végétation terrestre et des sols apparaît comme le principal réservoir dans lequel l'homme puisse ré-enfouir à moindre coût une part importante du carbone qu'il a émis depuis le début de l'ère industrielle (agir sur l'autre réservoir important qu'est l'océan est en effet hors de portée). Le réchauffement du climat tend à éroder ce réservoir, car plus la température est élevée, plus cette matière organique s'oxyde rapidement. C'est pourtant ce réservoir qui est considéré comme le seul capable de recevoir l'excèdent de gaz carbonique de l'atmosphère qui est la cause du réchauffement climatique. Encore faut-il le préserver. Il est donc inquiétant de voir les forêts renvoyer dans l'atmosphère lors des incendies le gaz carbonique qu'elles avaient préalablement fixé par photosynthèse.

Plus préoccupant encore est l'incendie qui s'est développé au Groenland en 2017 : celui-ci, qu'incontestablement on peut imputer à la sécheresse et à une température exceptionnellement élevée, ne brûle pas seulement la végétation, qui y est rase et rabougrie. Il se développe dans l'immense réservoir de carbone qu'y constituent les tourbières. Or, la matière organique de la végétation terrestre et des sols apparaît comme le principal réservoir dans lequel l'homme puisse ré-enfouir à moindre coût une part importante du carbone qu'il a émis depuis le début de l'ère industrielle (agir sur l'autre réservoir important qu'est l'océan est en effet hors de portée). Le réchauffement du climat tend à éroder ce réservoir, car plus la température est élevée, plus cette matière organique s'oxyde rapidement. C'est pourtant ce réservoir qui est considéré comme le seul capable de recevoir l'excèdent de gaz carbonique de l'atmosphère qui est la cause du réchauffement climatique. Encore faut-il le préserver. Il est donc inquiétant de voir les forêts renvoyer dans l'atmosphère lors des incendies le gaz carbonique qu'elles avaient préalablement fixé par photosynthèse.

Octobre 2017

1/1 Pour amener le climat à un état stable après la perturbation anthropique, il faudra retirer du gaz carbonique de l'atmosphère. Le coût en sera très élevé si nous ne réduisons pas rapidement nos émissions.

Yves Dandonneau

Dans un article récent paru dans la revue Earth Systems Dynamics sous le titre «Young people’s burden : requirement of negative CO2 emissions», qu'on peut traduire par «un fardeau pour les futures générations : le besoin d'émissions négatives de CO2», James Hansen et 14 autres auteurs se basent sur ce qu'on sait du climat pour évaluer les conséquences, au siècle prochain, des mesures que nous allons prendre pour limiter les émissions de gaz à effet de serre, et pour quantifier les émissions négatives de gaz carbonique auxquelles il faudra recourir pour stabiliser le climat dans un état qui nous soit favorable. Ces émissions négatives sont l'inverse des émissions, c'est à dire des retraits de gaz carbonique de l'atmosphère. Ils concluent que les objectifs de réductions volontaires des émissions, adoptés par les états lors de la COP 21 en 2015 nous conduiraient à des teneurs en gaz carbonique dans l'atmosphère bien supérieures à 350 parties par million (ppm, on en est à 405 ppm !). La teneur de 350 ppm est le seuil au delà duquel ils considèrent que le réchauffement climatique risque d'évoluer vers des situations que nous aurions beaucoup de mal à gérer.

La prévision du climat sur des durées aussi longues se heurte à de nombreuses incertitudes. Le réchauffement en cours résulte d'un déséquilibre radiatif : depuis plusieurs décennies, la Terre émet moins de rayonnement qu'elle n'en reçoit du Soleil. Cependant, 93 % de la chaleur ainsi gagnée va dans les océans, d'abord dans la couche de surface, puis, par mélange, dans les eaux profondes. Or ce mélange est lent et mal connu. Le déséquilibre radiatif dépend de la température de la Terre, et de la nature et de la concentration en gaz à effet de serre. Le plus important de ces gaz, le gaz carbonique, interagit avec les océans et la biosphère en fonction de la température. Les interactions sont très nombreuses, souvent mal connues, et leurs effets se font sentir avec beaucoup de retard (voir encart ci-après).

Pour atteindre leur objectif, les auteurs ont simplement choisi d'associer modèle et relations empiriques de la façon suivante :

- L'évolution de la température est calculée en fonction du forçage radiatif et d'une sensibilité climatique (i. e. la réponse de la température moyenne du globe à ce forçage) choisie comme la plus communément admise parmi les estimations publiées.

- L'évolution du gaz carbonique dans l'atmosphère est calculée en tenant compte des nouvelles émissions, et des résultats d'un modèle de cycle du carbone forcé par la température.

- La nouvelle concentration en CO2, et la nouvelle température permettent de calculer le forçage radiatif, et ainsi de suite.

Ce modèle est mis en œuvre pour divers scénarios, incluant les prévisions du GIEC (élévations du CO2 et de la T° de l'atmosphère)» utilisés dans le dernier rapport du GIEC, ainsi que d'autres scénarios, du plus économe en CO2 (diminution de 6 % par an des émissions à partir de 2020) au plus pollueur (où ces émissions croissent de 2 % par an jusqu'à atteindre 25 GtC/an). Le scénario à - 6 % par an est bien entendu celui au terme duquel on obtient la température (0,5 °C au dessus de la température maximum au cours de l'Holocène) et la concentration en CO2 (390 ppm) les plus basses. Celui à -3 % aboutit à 415 ppm, et le scénario avec des émissions constantes à 540 ppm.

Or, les auteurs considèrent qu'au delà de 350 ppm, un nouvel équilibre climatique s'établirait à une température supérieure à celle du maximum de l'Holocène. Dans ces conditions, le risque existe que les rétroactions lentes s'accélèrent et qu'il y ait un basculement du climat. En particulier, les surfaces englacées des zones polaires pourraient se réduire, les émissions de méthane des pergélisols s'emballer, ou les sols perdre leur carbone sous forme de gaz carbonique (un réchauffement de 1°C du sol entraîne une perte de 30 GtC de carbone vers l'atmosphère, et + 2 °C entraînerait 55 GtC, soit l'équivalent d'environ 6 ans de nos émissions actuelles de gaz carbonique). L'emballement de la fonte des calottes polaires constitue un risque majeur : en effet, au cours de l'Eémien (c'est à dire le précédent interglaciaire), avec une température supérieure de seulement 1°C à celle de l'époque préindustrielle, le niveau des océans était plus élevé de 6 à 9 m.

Pour passer au dessous de concentrations en gaz carbonique qui, à moyen terme, déstabiliseraient le climat, il sera nécessaire de recourir à des émissions négatives.

Les solutions les moins coûteuses sont celles qui consistent à reconstituer la matière organique des sols et à fixer du carbone dans les forêts et les prairies. Toutefois, cette première catégorie de solutions ne pourrait retirer, selon les auteurs, que 100 GtC de carbone environ, soit, tout de même, l'équivalent de 10 ans de nos émissions actuelles. C'est cependant moins que les 153 GtC qu'il faudrait retirer de l'atmosphère dans le cas où les émissions décroîtraient de 6 % par an à partir de 2020. Si ces émissions diminuent de 3% par an, ou continuent au rythme actuel, c'est respectivement 237 ou 695 GtC qu'il faudrait retirer.

Pour aller au delà de ces 100 GtC qui pourraient être stockées dans les sols, il faudra faire appel à des techniques beaucoup plus coûteuses. Celle qui est la plus envisagée actuellement, consiste à prélever le gaz carbonique à la source, à la sortie des centrales électriques thermiques, et à l'enfouir. D'autres techniques sont à l'étude, pour prélever le gaz carbonique à faible concentration dans l'atmosphère, en utilisant de l'énergie solaire ou éolienne. Les coûts de ces techniques seront très difficilement à notre portée. Des politiques vigoureuses de réduction de nos émissions sont donc nécessaires le plus vite possible pour ne pas alourdir le besoin d'émissions négatives dans le futur.

Les résultats de cette publication peuvent susciter des discussions. D'un point de vue strictement scientifique, les choix qui sont faits de certains paramètres (par exemple, la valeur de la sensibilité climatique, ou du seuil critique à 350 ppm de CO2) sont quelque peu arbitraires. Et les conclusions n'apportent rien de nouveau à la connaissance du climat. Cependant elles signalent un risque réel, à long terme, que nos sociétés n'ont encore pas bien pris l'habitude de traiter, mais qu'elles ne peuvent pas négliger. Au moins doivent elles le connaître.

L'ajustement du climat à la perturbation anthropique : un processus très lent

Il nous est difficile de concevoir que le climat du siècle prochain est conditionné par le gaz carbonique que nous avons rejeté dans l'atmosphère depuis le début de l'ère industrielle, difficile aussi de voir dans le climat actuel, qui a encore peu changé, les menaces qui pèsent sur le futur. L'évolution très schématique ci dessous, imaginée à titre d'exemple, peut aider à comprendre cette lenteur d'un retour à un nouvel équilibre.

Phase 1 (1880 - actuel) :

Les émissions de gaz carbonique ont commencé avec l'ère industrielle et elles ont cru jusqu'en 2015 où elles semblent se stabiliser. Jusqu'en 1980, la concentration de l'atmosphère en gaz carbonique a augmenté de 1 ppm/an, et par la suite, de 2 ppm/an. La moitié environ de ces émissions a été absorbée par les océans et par les écosystèmes terrestres. Cette croissance de la concentration en gaz carbonique fait que la terre reçoit plus de rayonnement au sommet de l'atmosphère qu'elle n'en émet, et elle se réchauffe. Nous le savons en regardant l'évolution de la température moyenne globale (0,18 °C par 10ans depuis 1970). Cette différence entre le rayonnement reçu et le rayonnement émis par la Terre constitue le forçage radiatif, qui s'est accru de 0,4 W/m2 tous les 10 ans.

Phase 2 (actuel - 2050) :

La poursuite des émissions, même si celles ci se stabilisent ou diminuent donne tout de même lieu aux augmentations de la concentration en gaz carbonique de l'atmosphère, du forçage radiatif et de la température. Avec l'augmentation de la température de la Terre, le rayonnement qu'elle émet depuis le sol tend à augmenter, sans pour autant équilibrer le bilan radiatif de la Terre : un forçage radiatif subsiste.

Phase 3 (2050 - 2100) :

Arrêt des émissions. À cause du forçage radiatif qui subsiste, la Terre continue de se réchauffer. Ce faisant, le rayonnement qu'elle émet augmente doucement. D'un autre côté, les océans absorbent peu à peu du gaz carbonique de l'atmosphère, à mesure que le mélange amène en surface des eaux profondes dont la teneur en gaz carbonique correspond à l'équilibre climatique qui prévalait avant l'ère industrielle. La diminution de la concentration en gaz carbonique de l'atmosphère et l'augmentation du rayonnement émis par la Terre tendent à réduire le forçage radiatif.

Phase 4a (2100...) :

On a pu procéder à des émissions négatives suffisantes pour abaisser la concentration en gaz carbonique à un niveau tel que le rayonnement émis par la terre et celui qu'elle reçoit s'équilibrent. Le climat est alors stabilisé.

Phase 4b (2100...) :

On n'a pas su procéder à suffisamment d'émissions négatives et le forçage radiatif se poursuit. La température moyenne de la Terre continue d'augmenter. Elle atteint un niveau critique. La matière organique des sols, en particulier celle des pergélisols, s'oxyde rapidement, faisant augmenter la concentration en gaz carbonique de l'atmosphère et renforçant l'effet de serre. Les calottes polaires se réduisent et réfléchissent une part moindre du rayonnement solaire, augmentant ainsi le forçage radiatif : la fusion des calottes s'accélère et le niveau des océans s'élève rapidement d'une dizaine de mètres, ou davantage.

Référence :

Article paru dans Earth Systems Dynamics. 14 auteurs coordoné par James Hansen

Avril 2017

1/1 Surveillance des océans, mesures in-situ, programme Argo et NAOS

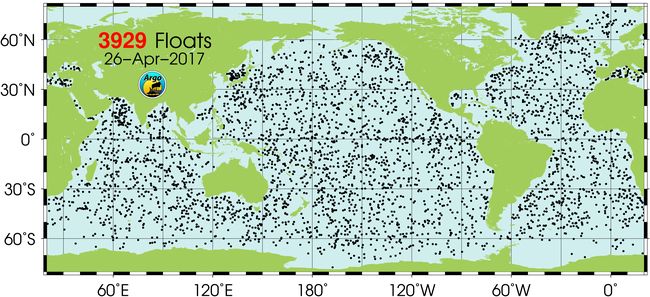

Lancé en 2000 par la Commission océanographique intergouvernementale de l'Unesco (COI) et l'Organisation météorologique mondiale (OMM), le programme Argo avait pour objectif de développer et maintenir un réseau global de 3000 flotteurs profilants mesurant en temps réel la température et la salinité des océans depuis la surface jusqu'à 2000 m de profondeur. Cet objectif a été atteint en 2007. En avril 2017, le réseau comprend un peu plus de 3900 flotteurs.

Carte des flotteurs Argo actifs. Source Argo.

Issue d'une coopération très réussie entre plus de 30 pays, ce réseau unique d'observation globale in-situ des océans, complément indispensable des observations satellitaires, a permis de mettre en oeuvre la démarche : "observer, comprendre, prévoir" pour préciser le rôle de l'océan sur le climat.

Cette série d'observations a permis des avancées remarquables dans la représentation par des modèles numériques de l’océan, nécessaires à la prévision océanique et climatique saisonnière. Les données sont systématiquement utilisées par les systèmes mondiaux d’océanographie opérationnelle (NOAA, Jamstek au Japon, BOM en Australie et Copernicus Marine Service coordonné par Mercator Océan en Europe) et leurs applications.

Il a aussi contribué à améliorer l'estimation de la chaleur stockée dans les océans, à mieux comprendre l'élévation globale du niveau des mers, et à analyser les variations de la circulation océanique et des zones de convection profondes. Ces mesures ont également montré des changements dans la salinité qui suggèrent une amplification du cycle hydrologique.

Compte tenu de sa contribution éminente notamment pour l'étude du changement climatique, le réseau ARGO doit, d'une part être pérennisé, et d'autre part étendre son champ d'observation.

En effet :

- certaines zones ne sont pas assez couvertes car la répartition des flotteurs dans les océans est inégale,

- des mesures à plus grande profondeurs sont nécessaires,

- ainsi que de nouvelles mesures dans le domaine de la biogéochimie.

Dans ce but, un renforcement de la coopération internationale est apparu indispensable. La France a pris dès 2011 les dispositions pour y prendre part. Il s'agit du projet NAOS (Novel Argo Ocean observing System) mis en place pour une durée de 9 ans.

Depuis le début du programme Argo, la France a été leader de l'effort européen pour cette infrastructure mondiale. La consolidation sur le plan administratif est intervenue en 2014 avec la mise en place d'une structure légale Euro-Argo ERIC (European Research Infrastructure Consortium), qui organise et fédère les contributions européennes à Argo et dont le siège est localisé en France à Brest.

Quels sont les objectifs du projet NAOS ?

Cinq secteurs d'activité ont été confiés à cinq groupes de travail avec des objectifs bien précis :

-

Renforcer la contribution française au réseau Argo

L'objectif est de maintenir et améliorer le réseau Argo pour les prochaines décennies. C'est un élément clé, les scientifiques ont besoin de données pour poursuivre leurs recherches afin de surveiller la planète, poursuivre l'amélioration des connaissances du rôle de l'océan sur le climat. Ils doivent aussi comprendre et prévoir les implications environnementales et sociétales.

La priorité est donc de renforcer la contribution française et européenne au réseau international Argo par le déploiement de flotteurs supplémentaires sur la période de 2012 à 2019 (actuellement, chaque année, 800 à 900 nouveaux flotteurs sont déployés, pour maintenir le réseau de flotteurs actifs à son niveau actuel, leur durée de vie moyenne étant de 3 à 4 ans). Il s'agit de flotteurs Arvor développés par l'Ifremer et industrialisés par la société NKE. Avant 1994, l'Ifremer avait étudié une première génération de flotteurs Marvor mis en oeuvre dans les campagnes océanographiques. Puis vers 1997, des besoins nouveaux de flotteurs dérivant étant apparus, le profileur Provor héritier de Marvor a été mis au point.

Il s'agit de flotteurs Arvor développés par l'Ifremer et industrialisés par la société NKE. Avant 1994, l'Ifremer avait étudié une première génération de flotteurs Marvor mis en oeuvre dans les campagnes océanographiques. Puis vers 1997, des besoins nouveaux de flotteurs dérivant étant apparus, le profileur Provor héritier de Marvor a été mis au point.

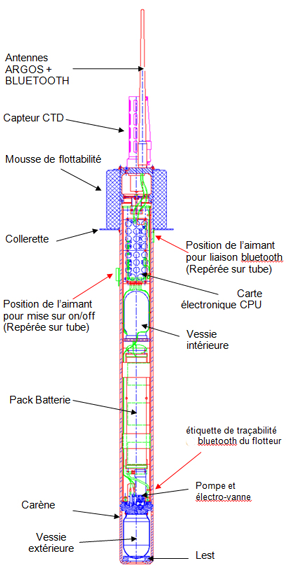

Ces appareils sont utilisés de la façon suivante : après un séjour de deux semaines à la profondeur de 1000 m, le flotteur descend jusqu'à 2000 m, puis remonte jusqu'à la surface pour transmettre les mesures effectuées. On récupère ainsi deux fois par mois le courant moyen à 1000 m ainsi que des profils de température et de conductivité (dont on déduit la salinité).

Enfin, pour le programme Argo a été développé un profileur Arvor plus léger et plus facile à mettre en oeuvre que le Provor, exclusivement dédié à la mesure de température et de salinité. Les profileurs Provor étant plus volumineux, peuvent plus facilement être équipés de capteurs optiques et sont utilisés maintenant pour les besoins de mesure de l'oxygène dissous et d'autres paramètres biogéochimiques. -

Développer la nouvelle génération de flotteurs Argo

Il s'agit de développer de nouveaux outils d'observation et les évolutions instrumentales répondant aux besoins d'Argo pour les 10 années à venir. Les nouveaux flotteurs seront plus intelligents, plus fiables, moins coûteux et économes en énergie. Ils seront aussi capables d'embarquer de nouveaux capteurs permettant d'élargir la gamme de mesures (en particulier pour la biogéochimie : oxygène, chlorophylle-a, nitrate, carbone), et d'aller vers les plus grandes profondeurs (jusqu'à 4000 m). Certains disposeront aussi de nouvelles capacités de transmission par satellite, Argos-3 et Iridium.

-

Flotteurs avec capteurs biogéochimiques en Mer Méditerranéenne

La Méditerranée est une des mers les plus impactées par la pression humaine et par le changements climatique, d'où l'importance de disposer de moyens d'observations et de données scientifiques. Ce programme permettra de mettre en place le premier réseau d'observation robotisé des écosystèmes marins et d'avancer dans la compréhension des dynamiques des écosystèmes en Méditerranée.

-

Flotteurs avec capteurs biogéochimiques en Arctique

Le changement climatique a provoqué des modifications considérables des biotopes marins dans l'Océan Arctique. La diminution de l'étendue de la banquise durant l'été a entraîné une augmentation de la production primaire au cours de la dernière décennie. Les écosystèmes marins sont impactés par des perturbations liées à la couverture de glace, la lumière, les nutriments et la température. Les flotteurs seront déployés dans les zones de glace saisonnière.

-

Flotteurs profonds avec capteurs d’oxygène en Atlantique Nord

Des flotteurs profonds (au delà de 2000 m) permettent de disposer de données nouvelles apportant une meilleure estimation du rôle de l'océan dans l'élévation du niveau de la mer. L'existence de capteurs d'oxygène apporte des éléments nouveaux sur la concentration en oxygène dans l'océan, sur la dynamique océanique, les écosystèmes et le cycle du carbone. Les séries de données sur la température, la salinité et les concentrations en oxygène dissous permettront d'étudier la variabilité de la convection profonde, des propriétés des masses d'eau, de la circulation océanique et la réponse biogéochimique à ces changements.

Où en est-on ?

Renforcement de la contribution française au réseau Argo

Entre 2012 et 2015, 67 flotteurs (Arvor) mis en service sont actuellement traités par le centre de données Coriolis. Ils ont été déployés sur une grande surface géographique (Atlantique Sud, Atlantique équatorial, Atlantique Nord, Golfe de Guinée, Pacifique S.O, Golfe du Bengale), et sur des supports variés : campagnes océanographiques (80%), déploiement d’opportunité (voiliers et marine marchande). De nouveaux flotteurs seront déployés en 2017.

Nouvelle génération de flotteurs Argo

Les développements de nouveaux flotteurs et l'amélioration des flotteurs existants sont quasiment menés à terme. Bon nombre ont été déployés, ce qui a permis aux chercheurs de mener des expériences scientifiques pilotes en mer Méditerranée, en Arctique et dans l'Atlantique Nord. Elles vont se poursuivre et évoluer vers l’exploitation scientifique des observations et leur apport pour la compréhension du rôle de l’océan sur le climat.

- Nouveau profileur Arvor avec fiabilisation et simplification de la mise en oeuvre. Déploiement en grande quantité. Choix de transmission Argos ou Iridium.

- Arvor profond ( Deep-Arvor), profileur profond permettant de doubler la profondeur d'un profil Argo en allant jusqu'à 4000 m, et pouvant ainsi explorer près de 90 % du volume des océans. Quelques prototypes ont été déployés et necessitent des améliorations.

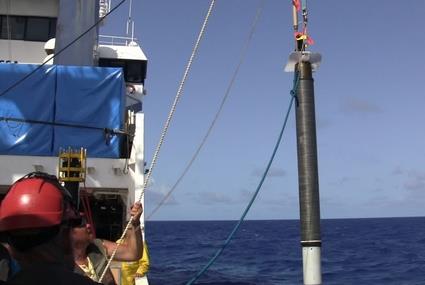

Mise à l'eau d'un Deep Arvor. Source Ifremer

Mise à l'eau d'un Deep Arvor. Source Ifremer

- Flotteurs Provor :

- Provor Noss avec capteur de densité NOSS qui mesure la déviation d'un faisceau laser traversant le milieu à analyser et calcule un indice de réfraction, une densité et une salinité.

- Provor CTS5 (Pro-Ice) avec une stratégie de détection et d'évitement de la glace lors de sa remontée.

Flotteurs avec capteurs biogéochimiques en Mer Méditerranéenne

Concernant les flotteurs avec capteurs biogéochimiques en Méditerranée, plus de 80% ont été déployés notamment lors de campagne BioArgoMed en 2015, spécifiquement dédiée au déploiement et à la récupération des flotteurs NAOS.

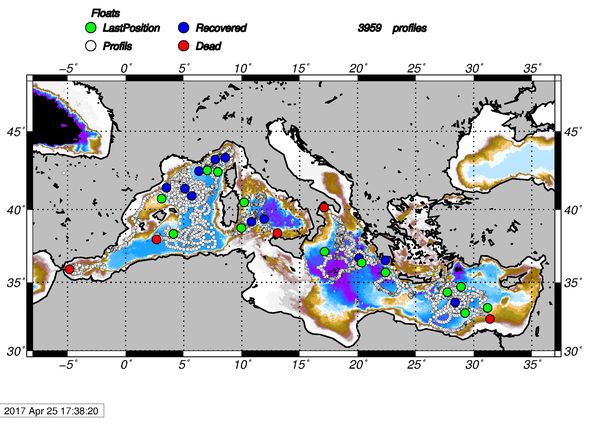

Positions des profils des flotteurs NAOS en mer Méditerranée (points blancs : dernière position disponible; points verts : flotteurs toujours opérationnels ; points rouge : flotteurs perdus ; points bleu : flotteurs récupérés).

Positions des profils des flotteurs NAOS en mer Méditerranée (points blancs : dernière position disponible; points verts : flotteurs toujours opérationnels ; points rouge : flotteurs perdus ; points bleu : flotteurs récupérés).

5482 profils (dont 3202 de NO3/O2) ont été collectés, depuis novembre 2012. Leur exploitation a permis de progresser dans la connaissance et a donné lieu à plusieurs publications.

Flotteurs biogéochimiques en Arctique

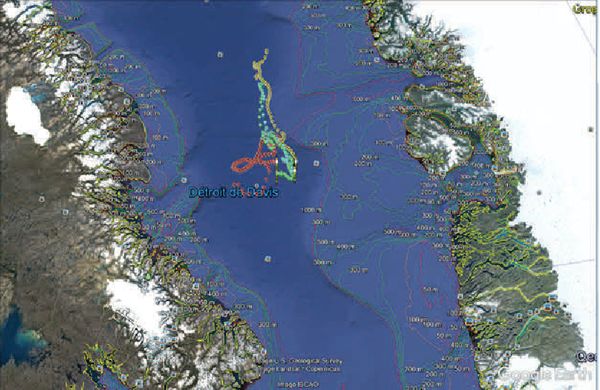

Le 9 juillet 2016, les premiers flotteurs adaptés aux conditions arctiques (flotteurs Pro-Ice) ont été déployés en Baie de Baffin depuis le brise-glace canadien Amundsen dans le cadre du projet GreenEdge dont l'objectif est de comprendre les dynamiques du bloom phytoplanctonique de printemps, de déterminer son rôle dans l'océan arctique et les conséquences pour les populations.

Trajectoires des quatre flotteurs depuis leur largage jusqu’à leur plongée hivernale le 1er novembre 2016. Source Naos.

Cinq flotteurs avec capteurs biogéochimiques ont été déployés, 4 en mer de Baffin et un en mer de Labrador.

Ces flotteurs Pro-Ice sont équipés de capteurs CTD (conductivité, température et profondeur), d’oxygène dissous, de fluorescence de la chl a (chlorophylle), de fluorescence du CDOM (matière organique dissoute), de la rétro-diffusion des particules, et de nitrate (deux flotteurs sur quatre).

Flotteurs profonds avec capteurs d'oxygène Atlantique Nord

L’océan profond (au-dessous de 2000 m) reste à ce jour encore mal connu faute de moyens d'observation. L'existence de profileurs Deep-Arvor capables d’échantillonner les 4000 premiers mètres de la colonne d’eau va permettre de disposer de données et de remédier à ce manque.

De nombreuses questions se posent sur la circulation profonde moyenne et sa variabilité, sur la variabilité interannuelle, décennale et à long terme des masses d’eaux profondes et leur rôle sur le stockage de chaleur océanique et l’augmentation du niveau de la mer et plus généralement sur le rôle de la dynamique océanique dans la pénétration et la propagation dans l’océan profond des anomalies climatiques.

L'existence de flotteurs profonds permet d'avoir une meilleur estimation du rôle de l'océan dans l'élévation du niveau de la mer en accédant à la composante thermique profonde. Leur capacité de mesurer la concentration en oxygène dissous met en place une surveillance globale de la concentration en oxygène dans l'océan afin d'évaluer l'impact du changement climatique sur la dynamique océanique et les écosystèmes et pour mieux fermer le cycle du carbone.

Trois zones de déploiement privilégiées des Deep Arvor ont été déterminées dans le cadre d'une stratégie européenne : l’océan Atlantique Nord, l’océan Austral et la mer Méditerranée.

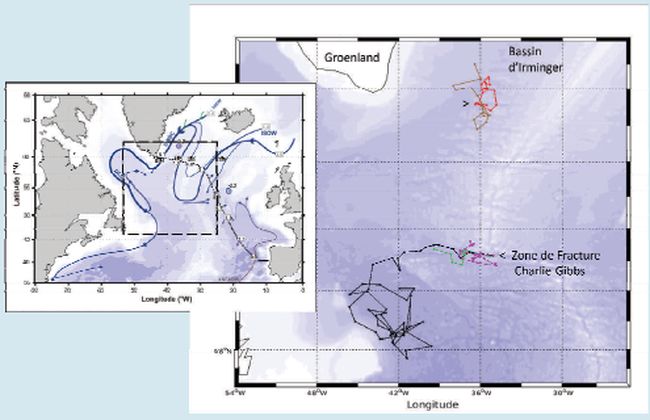

D'ores et déjà, cinq flotteurs Deep-Arvor, équipés d’un capteur d’oxygène dissous, ont été déployés dans le gyre Subpolaire Nord Atlantique . Trois d’entre eux ont été mis à l’eau simultanément dans la zone de fracture Charlie-Gibbs (CGFZ) au cours de l’été 2015 (campagne RREX), tandis que les deux autres ont été largués dans l’Est du bassin d’Irminger au cours de l’été 2016 (campagne BOCATS). Ces déploiements ont conduit à l’acquisition d’un jeu de données de température, de salinité et d’oxygène dissous à haute fréquence (dix jours), unique en profondeur (> 2000 m). ces jeux de données de haute qualité ont déjà conduit à des résultats remarquables.

Trajectoires des trois flotteurs Deep‐Arvor‐O2 déployés dans la Zone de Fracture Charlie‐Gibbs (CGFZ) en juillet 2015 et des deux flotteurs déployés dans l'Est du bassin d'Irminger en juillet 2016, comparées à la circulatioon profonde du Gyre subpolaire Nord Atlantique (carte de gauche, Daniault et al., 2016) dans laquelle les flotteurs dérivent. Les flotteurs noir, marron et rouge communiquent toujours et transmettent leurs données tous les dix jours, tandis que les flotteurs vert et violet ont cessé toutes communicationons (mise à jour le 21 décembre 2016).Source NAOS.

Pour plus de détails sur l'ensemble de ces travaux consulter la News letter NAOS de janvier 2017.

Conclusion

Sonder en profondeur les océans, les scruter en permanence était un rêve d'océanographe. Il a commencé à se réaliser il y a 10 ans quand le réseau Argo est devenu opérationnel, résultat d'une coopération internationale sans équivalent. C’est le premier réseau mondial d’observation in situ des océans en temps réel, le complément indispensable des mesures satellitaires permettant aux scientifiques d’observer, comprendre, prévoir et donnant les éléments à la société pour agir. Avec NAOS, la structure Euro-Argo Eric, ce réseau est pérennisé.

Participants au programme NAOS

Les partenaires de ce programme sont : Ifremer, UPMC, CNRS/INSU, UeB, Shom, CLS, nke.

Les laboratoires participants : LOV (Laboratoire d'océanographie de Villefrance), LOCEAN (Laboratoire d'Océanographique du Climat), LOPS Laboratoire d'Océanographie Physique et Spatiale., département RDT (Ifremer Recherches et Développements Technologiques) , UMI Takuvik

En savoir plus

News letter NAOS de janvier 2017

News 2014 : Euro-Argo ERIC, Une infrastructure de recherche européenne pour l'observation des océan

Journal Mercator Océan. Numéro spécial Euro Argo

Février 2017

1/2 Température moyenne globale : La nécessaire amélioration des bases de données vue par les climato-sceptiques comme une manipulation suspecte.

Yves Dandonneau

La température moyenne à la surface du globe terrestre est suivie avec attention comme l'indice du réchauffement climatique tel que nous le ressentons, nous qui vivons sur cette surface. Elle est estimée à partir d'observations qui, à partir de 1880, sont devenues en nombre suffisant pour qu'on puisse établir des moyennes globales.

Depuis cette date, les techniques de mesure, surtout celles en mer, ont évolué :

- prélèvements d'eau au seau et mesure par thermomètre dans ce seau,

- capteurs électroniques dans les prises d'eau des navires,

- mesure par satellite du rayonnement infrarouge émis par la surface,

- capteurs de température sur des bouées dérivantes.

Chaque système est particulier et pour harmoniser l'ensemble des données, des corrections y sont apportées de temps à autre. Ces corrections sont généralement de très faible amplitude. La dernière en date était destinée à corriger un biais qui subsistait entre les mesures en mer modernes et celles anciennes prises «au seau» à partir des navires, affectées par une légère variation entre la prise d'eau proprement dite et la lecture du thermomètre. Elle a déclenché une polémique très vive avec les climatosceptiques, polémique qui a même pris aux États Unis un tour politique.

En effet, alors que la température moyenne globale augmentait bon an mal an assez régulièrement, un record très marqué de la température moyenne globale en réponse au phénomène El Niño qui a sévi en 1997-98 a tenu longtemps. Pendant plus d'une dizaine d'années – cette période a été appelée «le hiatus» – la hausse des températures a semblé s'arrêter, donnant des arguments aux climato-sceptiques pour contester le réchauffement global, et ouvrant la porte à toutes sortes d'hypothèses annonçant un refroidissement à venir. Le réchauffement a depuis repris sa course, mais la querelle avait été attisée par cette correction récente des données de température qui, (hasard pour la communauté des climatologues, mais manipulation délibérée pour certains opposants à la théorie du réchauffement climatique), avait fait tomber le record de 1997-98.

Chaque année n'est pas forcément plus chaude que la précédente. La variabilité climatique affecte les transferts de chaleur entre les divers réservoirs du système climatique (n'oublions pas que les terres émergées ne stockent que 1 % du surplus de chaleur lié à l'augmentation de l'effet de serre), de telle sorte que des années un peu plus froides interrompent souvent, naturellement, la suite d'années record. Les années où sévit le phénomène El Niño en particulier, donnent lieu à des sauts de température très marqués. Il en a été ainsi pour l'El Niño de 1997-98, et il en été de même pour celui, récent, de 2015-2016. Le record de température atteint ces années là ne sera sans doute pas dépassé de sitôt et un nouveau «hiatus» est possible, qui ne remettra pourtant pas en cause le réchauffement global, mais qui redonnera peut être aux climato-sceptiques le prétexte à de nouvelles polémiques.

Leurs arguments peuvent apparaître convaincants pour le public non spécialiste, et démolir cette argumentation demande un effort qui est perçu comme une perte de temps fastidieuse. Les recettes pour ne pas tomber dans le piège :

- ne pas faire confiance aux sites notoirement «climato-sceptiques»,

- vérifier que le travail est basé sur des publications dans des revues avec comité de lecture,

- s'assurer que les auteurs de l'article sont affiliés à des universités ou des organismes de recherche,

- et avoir en tête que si un chercheur spécialiste du climat découvrait un mécanisme ou une hypothèse mettant à mal la vérité du réchauffement climatique, il n'hésiterait pas une seconde à le publier et en retirerait une renommée que tous recherchent.

(Voir l''article publié par Stefan Rahmstorf sur le site de RealClimate que nous avons traduit en français).

Février 2017

2/2 L’année climatique 2016 - L’année la plus chaude de l’époque moderne : Niño, Nada, Niña

Bruno Voituriez

Contexte général

La news de février 2016, faisant le bilan de l’année climatique 2015, s’intitulait déjà «l’année la plus chaude de l’époque moderne».

En 2015, El Niño a régné en maître toute l’année et a beaucoup contribué à ce record. Cet épisode a démarré en octobre 2014 ainsi que le montre sur la figure 1 l’évolution de l’indice océanique d’El Niño (qui représente l'anomalie de température de surface dans les zones 3/4 du pacifique équatorial figure 1 bis).

Figure 1 : Evolution de l’indice océanique El Niño.

Il représente les anomalies de température de surface dans la zone 3/4 du Pacifique équatorial.

Si les anomalies sont positives et supérieures à 0.5°C, on est en période Niño.

Si elles sont négatives et supérieures à 0.5, on est en Niña.

( NOAA Climate.gov )

Figure 1 bis : Le zonage du Pacifique équatorial utilisé pour caractériser El Niño

Il a culminé un an plus tard avec des anomalies de température supérieures à 2°C dans cette zone, d’octobre 2015 à mars 2016. Il a décru ensuite rapidement pour disparaître en juin où la situation devient neutre, c'est-à-dire que les écarts à la normale de température sont inférieurs à 0.5°C. Formellement les trois derniers mois de l’année correspondent même à des situations Niña avec des écarts de 0.8°C en dessous de la normale. Cette évolution était prévisible car les épisodes Niño caractérisés ne dépassent quasiment jamais 2 ans. En janvier 2016 le «Climate prediction centre» de la NOAA prévoyait correctement que le fort El Niño allait graduellement faiblir au printemps 2016 pour une transition vers une situation neutre à la fin du printemps ou au début de l’été, c’est bien ce qui s’est passé.

En janvier 2017, le Climate Prediction Center prévoit un rapide retour à des conditions neutres (février 2017) après le bref épisode Niña de l’automne 2016, situation qui devrait se maintenir jusqu’à l’automne 2017, sans se prononcer sur la suite, car la prévision de l’évolution d’une situation neutre vers El Niño ou la Niña est très difficile, faute de disposer d’indicateurs fiables d’évolution dans ce «marais climatique». Les probabilités pour la période Août, Septembre, Octobre donnent l’avantage à la situation neutre (La Nada) 49%, puis Niño (36%) et Niña (15%).

CPC/IRI Early-Month Official ENSO Forecast Probabilities

| Season | La Niña | Neutral | El Niño |

| DJF 2017 | 43% | 57% | 0% |

| JFM 2017 | 28% | 70% | 2% |

| FMA 2017 | 19% | 74% | 7% |

| MAM 2017 | 14% | 74% | 12% |

| AMJ 2017 | 12% | 67% | 21% |

| MJJ 2017 | 12% | 60% | 28% |

| JJA 2017 | 13% | 54% | 33% |

| JAS 2017 | 15% | 50% | 35% |

| ASO 2017 | 15% | 49% | 36% |

On n’est capable de prévoir les évolutions de Niño et Niña que lorsque le phénomène a déjà démarré. D’où d’ailleurs une nouvelle appellation pour ces périodes neutres : la «Nada» autrement dit «rien» au sens de "circulez il n’ y a rien voir et on ne peut rien prévoir"….C’est à Bill Patzert du Jet Propulsion Laboratory de la Nasa que l’on doit la popularisation de cette expression.

En 2011, les USA connurent au printemps le plus grand nombre de tornades depuis 1953. S’en suivirent des discussions sur la cause que l’on voulait connaître de l’intensification de ces événements. On pensait naturellement comme c’était devenu l’habitude, à El Niño, La Niña ou le changement climatique. Consulté à plusieurs reprises par la presse Patzert répondit : Nada (il n’y a rien) car effectivement on était en période neutre dont n’émergeait aucun signal significatif et donc aucune prévision possible. Et il ajoutait : "Je n’aime pas la NADA". Pourquoi cela ? "Parce que avec Niña ou Niño, vous pouvez faire une prévision car ils structurent le système climatique et vous pouvez décemment faire une prévision à long terme. Avec la Nada c’est comme des adolescents sans règle. Il n’y a pas de contrainte et le système est imprévisble". On refera le point dans un an et revenons à 2016.

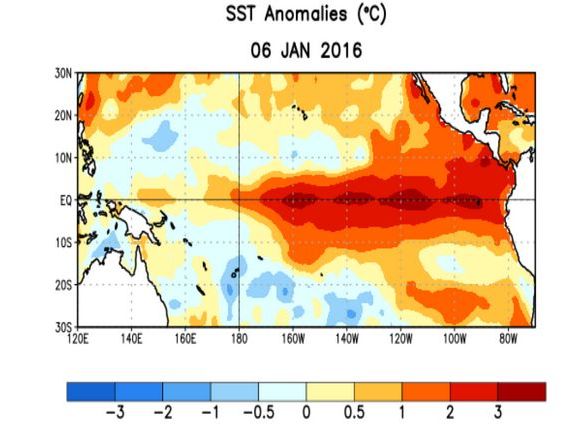

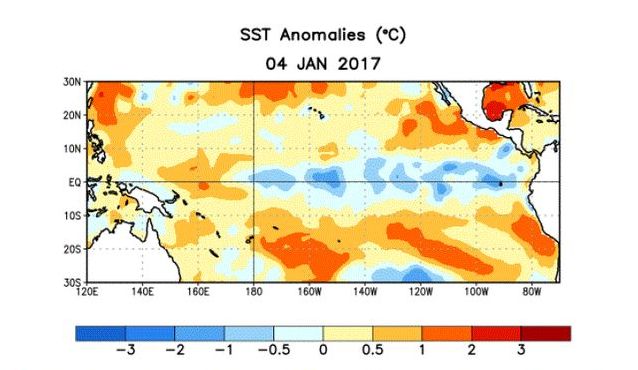

Température

Le contraste entre les cartes de température de surface entre la pleine période El Niño de janvier 2016 (+ 4°C ) sur la zone 3/4 et la même carte un an plus tard en période Niña (- 2°C), soit un écart de 6°C est flagrant (figures 2a et 2b).

Figure 2a : Anomalies de température dans le Pacifique équatorial : Janvier 2016 Niño. (NOAA Climate prediction center)

Figure 2a : Anomalies de température dans le Pacifique équatorial : Janvier 2016 Niño. (NOAA Climate prediction center)

Figure 2b : Anomalies de température dans le Pacifique équatorial : Janvier 2017 Niña. (NOAA Climate prediction center)

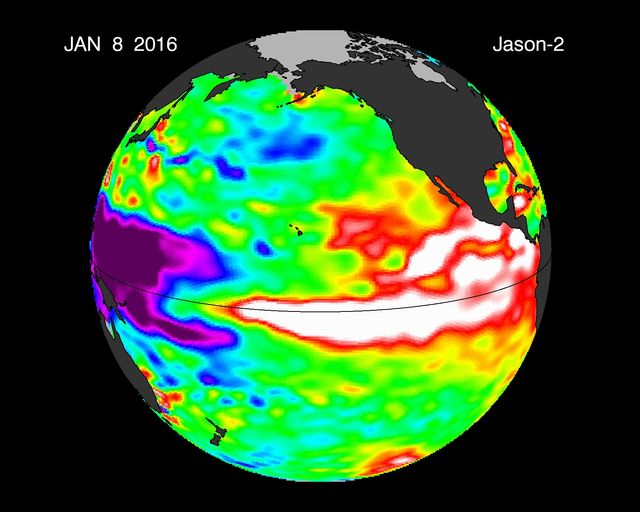

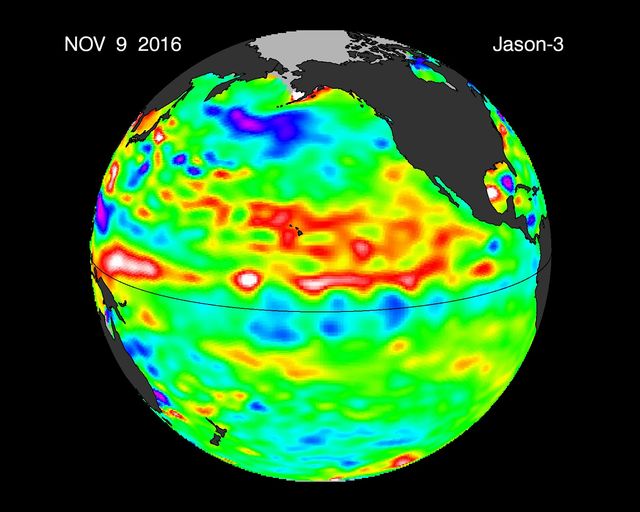

Même contraste spectaculaire sur le niveau de la mer à l’équateur. Anomalie de +20 cm en janvier 2016 en plein El Niño, contre – 6 cm un an plus tard (figures 3a et 3b).

Figure 3a : Anomalie du niveau de la mer dans le pacifique équatorial, Janvier 2016

Figure 3b : Anomalie du niveau de la mer dans le pacifique équatorial, november 2016.

La situation de 2016 , mi-Niño, mi-Niña fut donc très différente de celle de 2015, pleinement El Niño. Pourtant elle battit le record de température de 2015. C’est la troisième année consécutive qu’il en est ainsi et que l’on atteint des valeurs jamais obtenues depuis 1880. (figure 4).

Figure 4 : Température globale moyenne incluant les données sur terre et en mer. (NASA Giss)

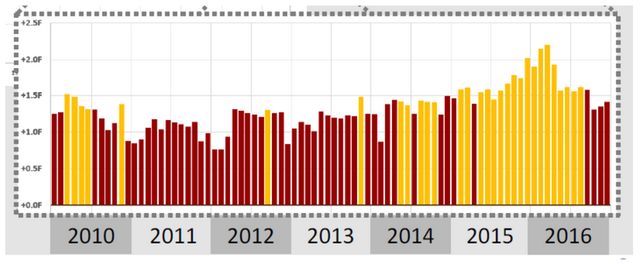

Par rapport à 2015, la température s’est accrue de près de 0.1°C, soit 1.1°C depuis la fin du 19ème siècle. Il est intéressant de noter que les températures mensuelles de 2016 furent supérieures à celle de 2015 jusqu’à l’automne 2016, correspondant à l’apparition d’un épisode Niña modéré (figure 5).

Figure 5 : Évolution des températures mensuelles de 2010 à 2016.

Les mois jaunes représentent des records de température par rapport aux mois des années précédentes.

(NOAA/NASA global analysis for 2016)

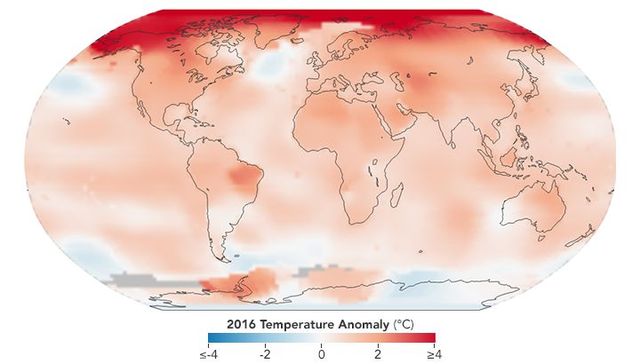

La carte des anomalies de température de 2016 (figure 6) montre que l’accroissement de température n’est pas uniformément réparti.

Figure 6 : Anomalies de température en 2016 par rapport à la moyenne de la période 1951-1980. (Nasa Earth Obervatory)

Un point avait attiré l’attention en 2015 : l’anomalie négative très significative sur l’Atlantique Nord, que l’on appelle « cool blob » (goutte froide).

Les intervenants à la conférence de presse NASA/NOAA en janvier 2016 avaient proposé deux explications possibles :

- l’affaiblissement de la MOC (meridional overturning circulation) qui a pour conséquence un affaiblissement du transport de chaleur vers le nord par l’océan

- et l’apport d’eau froide venant de la fonte du Groenland (EOS 25 janvier 2016).

Cette anomalie persiste en 2016 mais s’est nettement affaiblie. Affaire toujours à suivre donc en espérant une explication.

Contenu thermique de l’océan

L’Océan joue un rôle primordial dans le système climatique terrestre. C’est notamment lui le principal fournisseur (50%) de l’énergie qui met l’atmosphère en mouvement et crée les climats de la Terre. L’océan absorbe environ 90% du réchauffement induit par le forçage radiatif dû aux GES (gaz à effet de serre) anthropiques. Cela n’est évidemment pas sans conséquence sur son contenu thermique, sa dynamique et ses échanges avec l’atmosphère et donc le changement climatique. La figure 7 illustre l’accroissement du contenu thermique de l’océan (2000 premiers mètres) que l’on évalue maintenant avec précision grâce au développement du réseau ARGO dont les flotteurs mesurent la température jusqu’à 2000 mètres de profondeur. En Janvier 2017 on comptait 3970 flotteurs opérationnels. Cette courbe est très similaire à celle de l’évolution de la température (figure 4), ce qui traduit bien l’intensité du couplage entre océan et atmosphère.

Figure 7: évolution du contenu thermique de l’océan sur 2000 mètres de 1957 à 2016.

Niveau de la mer

Inexorablement le niveau de la mer ne cesse de monter (figure 8) au rythme moyen de 3.416 mm/an (+ou- 0.4 mm).

Figure 8 : Variations du niveau de la mer en mm (Climate NASA Gov)

Il est intéressant de noter la réponse en temps réel des variations du niveau de la mer aux occurrences des événements Niño-Niña qui ont jalonné les années 2014-2016. On voit nettement sur la figure 8 la montée rapide du niveau de la mer entre l'automne 2014, début d’El Niño et son maximum, puis sa diminution mi-2016 lorsque l’on évolue rapidement vers la Nada et la Niña qui signe la diminution finale.

Les banquises

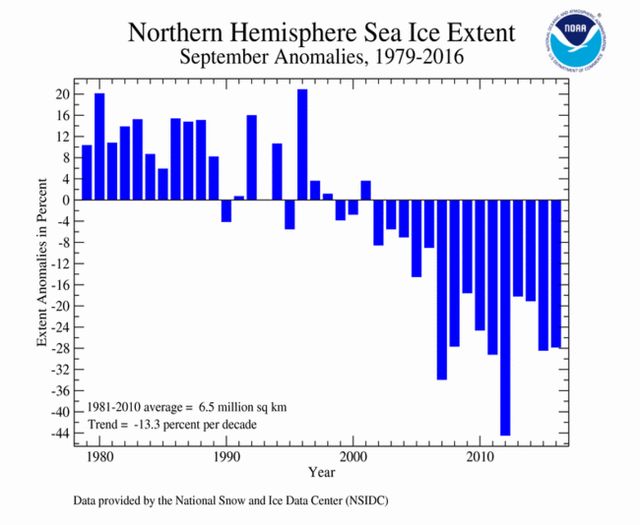

1 - L’Arctique

En Arctique, la banquise a atteint son extension maximum en mars 2016 : 14.43 millions de km2 soit 1.1 millions km2 de moins que la moyenne 1980-2010 (figure 9a). C’est équivalent à ce qui fut observé en 2015 (14.39) qui est en concurrence avec 2016 pour l’extension la plus faible depuis que l’on mesure cette extension par satellite en 1979. C’est 7 % inférieur à la moyenne 1981-2000.

Figure 9a : Anomalies de l’ Extension de la banquise arctique 1976-2016. Mars, extension maximum.

(NOAA National Centers for Environmental Information).

L’extension minimum intervint en septembre 2016 avec une surface de 4.72 millions km2 légèrement supérieure à celle de 2015 (4.68 millions km2) (figure 9b). Ce sont avec 2007 les trois années de couverture minimum après le record de 2012 (3.39 millions de km2).

Figure 9b : Anomalies de l’Extension de la banquise arctique 1976-2016. Septembre, extension minimum.

(NOAA National Centers for Environmental Information).

La différence de surface couverte entre le maximum de mars et le minimum de septembre fut très proche de 10 millions de km2. C’est la septième fois, depuis 2007, qu’un écart aussi important se produit. Avant 2007, cela n’était arrivé qu’une fois en 1991. Cela illustre bien la perte de glace dite pluriannuelle qui survit à la fonte annuelle de la banquise.

Plus la glace est âgée et plus elle est épaisse, et donc plus résistante que la jeune glace aux forçages atmosphériques et océaniques et à la fonte estivale. En 1985, 16 % du pack (relatifs à la couverture totale ) était de la glace de quatre ans ou plus. En mars 2016 cela ne représentait plus que 1.2%. En Mars 2016 la glace de l’année en cours représentait 78% du pack comparé à 55% en mars 1980 (figure 10). C’est un mouvement irréversible qu’il faudrait plusieurs années quasi glaciaires pour interrompre.

Figure 10 : La banquise arctique suivant les âges depuis 1980 :

a- Maximum de mars 1985

b- Maximum de Mars 2016

c- Évolution par classe d’âge de 1985 à 2016

En pourcentage de la surface totale occupée

Globalement les années 2015 et 2016 semblent assez semblables. Pourtant un événement inédit est apparu en fin 2015 sur l’Atlantique Nord : une circulation cyclonique tempétueuse qui s’est étendue à l’Arctique. Il s’ensuivit un flux volent d’air chaud et humide vers le Nord qui eut un double effet : repousser la banquise en formation vers le nord et réchauffer la surface de l’ océan, limitant ainsi la formation de la glace. Durant les mois de janvier, février, mars 2016 on observa alors les plus faibles extensions mensuelles des glaces depuis que l’on surveille la banquise depuis les satellites. Dans l’avenir la conjonction de la diminution de l’épaisseur de la glace et de l’occurrence plus fréquente de ce genre de tempête pourrait accélérer de manière importante la fonte de la banquise.

2 - L’ Antarctique

En 2015, la banquise antarctique en 2015 avait mis un terme à trois ans d’accroissement important de son extension maximale (figure 11) .

Figure 11 : Anomalies de l’ Extension de la banquise Antarctique 1976-2016. Septembre extension maximum.

Elle avait atteint son maximum en septembre 2014 avec 20.12 millions de km2. En septembre 2016, elle fut de 18.45, soit à une valeur très proche de la moyenne sur 1981-2010, qui est de 18.8 millions de km2. C’est très légèrement inférieur à 2015 (18.76). L’accroissement de l’extension de la banquise sud est une tendance générale. En 1979, l’extension était de 18 millions de km2 et en 2014 qui représente le maximum absolu d’extension depuis 1979, elle était de 20.12. Ces variations sont faibles et intriguent les scientifiques. Une news de décembre 2014 interrogeait les causes de cette tendance à l’accroissement et faisait l’hypothèse qu’il pouvait s’agir de du renforcement des vents d’ouest autour du continent qui induit un accroissement vers le nord du transport d’Ekman de la glace et des eaux froides de surface depuis le continent Antarctique ce qui facilite la formation de glace. Les modifications induites par le changement climatique dans le champ de pression atmosphérique peuvent y avoir leur part, mais on suspecte aussi la diminution depuis la fin des années 1970 de l’ozone au-dessus de l’Antarctique («le trou d’ozone» ) qui modifie de manière importante l’équilibre radiatif de la stratosphère. Dans les années à venir, ce déficit d’ozone devrait se résorber atténuant ce phénomène de refroidissement des eaux de surface et contribuant à une augmentation de l’effet de serre… Ce sont encore des hypothèses !

Il est certain en tout état de cause que les variations des relations océan-atmosphère jouent un rôle dans la dynamique des banquises d’autant plus importants que celles-ci se fragilisent comme dans le nord actuellement, ce qui peut accélérer les processus déstabilisateurs. Cf supra la tempête de décembre 2015 dans l’ Arctique.

Le Gaz carbonique.

Le CO2 se porte bien, qu’il s’agisse des émissions et de sa concentration dans l’atmosphère

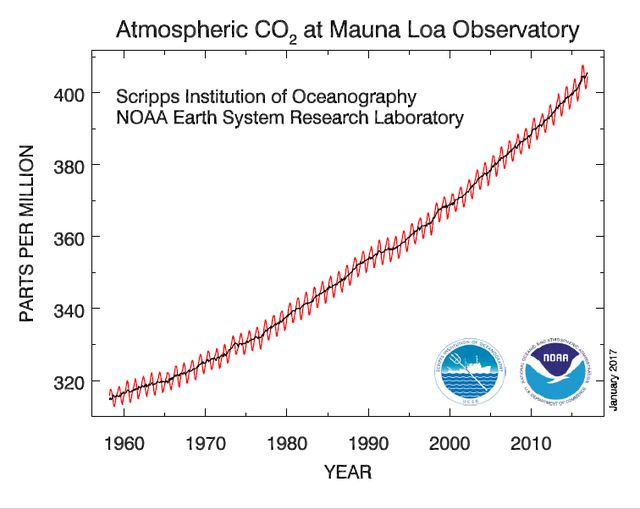

La courbe d’évolution de la concentration du gaz carbonique dans l’atmosphère continue son ascension sans marquer la moindre faiblesse (figure 12).

Figure 12 : Évolution de la teneur en CO2 de l’atmosphère telle que mesurée à l’observatoire de Mona Loa depuis 1958

(Année Géophysique Internationale) ( NOAA-ESRL)

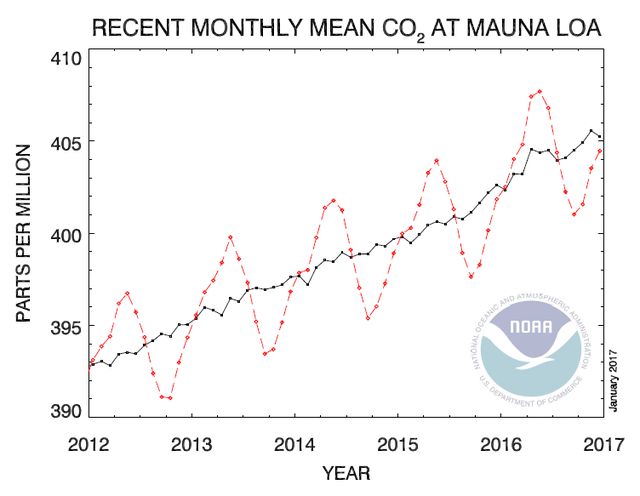

Elle a franchi la «barre» symbolique des 400 ppm en octobre 2015 sans retour en-deçà depuis (figure 13) et continue à croître. En décembre 2016 nous en étions à 404.48.

Figure 13 : Évolution de la teneur atmosphérique en CO2 à Mona LOA 2012-2017.

En rouge les valeurs moyennes mensuelles. En noir la même chose corrigée des variations saisonnières.

Dans la news sur le climat 2015 de janvier 2016, on s’interrogeait sur les relations qu’il pouvait y avoir entre les teneurs en gaz carbonique de l’atmosphère et le phénomène El Niño en cours, compte tenu des fortes augmentations observées entre novembre 2015 (400.16 ppm) et novembre 2014 (397.28), soit 2.88 ppm qui est la valeur la plus élevée depuis l’El Niño de 1998 (3.03). On peut sans doute confirmer qu’il y a bien une relation, car l’écart entre novembre 2016 (403.53) et novembre 2015 bat le record de 1998 et atteint 3.37 ppm. Il y a donc bien un pic de concentration atmosphérique de CO2 qui accompagne le pic de température en période El Niño.

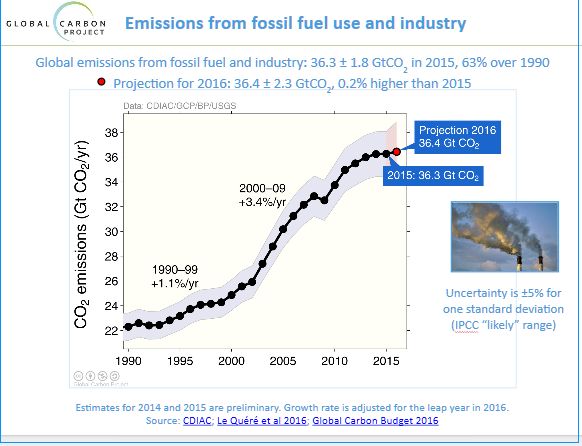

L’an dernier à la même époque, le Global Carbon Project annonçait pour 2015 une baisse légère des émissions : 35.7 Gt de CO2 contre 35.9 en 2014, soit une baisse de 0.6 %. Une première depuis celle de 2009 attribuée à la crise de 2008. Tous calculs faits, les émissions de 2015 sont maintenant évaluées à 36.3 Gt, soit une légère augmentation par rapport 2014. Pour 2016 le Carbon Project (figure14) annonce 36.4, soit une augmentation de 0.3%. On est là dans les marges d’erreur, et s’il n’y a pas la diminution espérée des émissions, on est depuis 2014 sur un plateau qui est un signe encourageant de l’évolution des émissions de CO2. Optimisme très tempéré, donc que les incertitudes politico-économiques pourraient démentir.

Figure 14 : Évolution des émissions de CO2 de 1990 à 2016. (Global Carbon Project)

Conclusion

L’année 2016 fut encore largement dominée par El Niño en dépit d’un final proche de la Niña dont on prévoit l’évolution en 2017 vers une situation qu’en d’autre temps on aurait qualifiée de normale, mais que l’on appelle maintenant Nada, soulignant ainsi l’imprévisibilité de son évolution.

Les deux années 2015-2016 ont bien mis en évidence l’importance d’ENSO sur le climat aux échelles pluriannuelles non seulement sur la température mais aussi sur le niveau de la mer et la banquise.