Mois de décembre 2009

1/1 Une expérience originale au lycée de Saint-Orens de Gameville

L'Académie des Sciences a attribué cette année le prix EADS (science et ingénierie) à Michel Lefèbvre, membre du Club des Argonautes..

Pour fêter cette distinction, il a souhaité relier trois générations sur le thème de l'étude de la Terre et plus particulièrement de l'eau sous toutes ses formes : la génération des pionniers pour la plupart à la retraite, la génération de leurs successeurs qui furent leurs élèves ou leurs stagiaires, chercheurs actuellement aux manettes, et les lycéens futurs scientifiques.

Avec l'aide du CNES, et de ses nombreux amis retraités ou encore en activité dans l'industrie spatiale ou dans les laboratoires scientifiques, il a mis en place le projet VIGIE (Veille Inter Génération pour l’Investigation sur l’Eau).

Ce projet propose aux élèves du lycée Paul Riquet de Saint-Orens d'étudier l’océan de façon historique, scientifique ou technique : est-ce que la mer monte ? à quelle vitesse les calottes glaciaires fondent-elles?, quelle est l’histoire de la mesure des océans ?...

Le coup d'envoi de ce projet mené en collaboration étroite avec l'équipe pédagogique a été lancé le 19 novembre 2009 après-midi au lycée spatial de Saint-Orens, date choisie pendant la Fête de la Science.

La manifestation a commencé par une conférence regroupant pas loin de 200 lycéens, le proviseur, des professeurs, des scientifiques retraités ou en activité, des représentants du CNES et de Planète Science devant ce public attentif, Michel Lefebvre a retracé sa carrière.

Puis, une quinzaine d'ateliers défini par thèmes, regroupant chacun des élèves, un ou deux animateurs scientifiques se sont réunis. Les lycéens ont pu poser des questions, définir les grandes lignes de leur projet tout au long de l'année scolaire.

Puis, une quinzaine d'ateliers défini par thèmes, regroupant chacun des élèves, un ou deux animateurs scientifiques se sont réunis. Les lycéens ont pu poser des questions, définir les grandes lignes de leur projet tout au long de l'année scolaire.

Après un débriefing général en fin d'après midi tout le monde s'est retrouvé pour boire le verre de l'amitié.

Par la suite, cette expérience originale sera étendue à d'autres établissements. Les trois générations vont maintenant échanger leurs questions, points de vue, expériences... Elles se retrouveront en fin d'année pour présenter les résultats de leurs travaux et étudier la poursuite de cette démarche à Saint-Orens, et pourquoi pas, dans d'autres établissements.

Mois de Novembre 2009

1/2 SMOS : "Soil Moisture and Ocean Salinity" - Humidité des sols et salinité des océans.

Le satellite SMOS a été lancé avec succès le 2 novembre 2009 depuis le cosmodrome russe de Plessetsk.

C’est une des missions spatiales d’observation de la Terre de l’Agence Spatiale Européenne qui s’inscrivent (comme GOCE) dans le cadre de son programme «Planète Vivante».

Elle a été proposée et conduite par le CESBIO qui est une Unité Mixte de Recherche (CNRS, Université Paul Sabatier, CNES, IRD) sise à Toulouse.C’est une mission dédiée au cycle de l’eau. L’eau, qui a cette particularité d’exister sur Terre sous trois formes (solide, liquide, gazeuse) est le principal agent des échanges d’énergie entre les différents compartiments du système climatique :

atmosphère, océan, cryosphère, surfaces continentales, milieu vivant.

Elle vise à combler deux lacunes qui concernent ce cycle ;

- l’une directement : l’humidité des sols,

- l’autre indirectement : la salinité de surface des océans.

L’humidité des sols comparés à l’océan, les sols recèlent évidemment une quantité d’eau dérisoire, mais le rôle de cette humidité est sans commune mesure avec le stock qu’elle représente.

SMOS s’intéresse à ce que l’on appelle la «zone des racines», jusqu’à une profondeur de deux mètres environ dont il donnera une image planétaire quantitative de l’humidité (pourcentage d’eau contenue dans une masse ou un volume de terre), tous les trois jours avec une résolution spatiale de 35 à 50Km.

L’humidité des sols intervient directement dans les échanges avec l’atmosphère : plus elle est élevée, plus les sols sont susceptibles de transmettre de l’eau à l’atmosphère et réciproquement.

Elle conditionne aussi le développement de la végétation dont les racines trouvent dans ce réservoir l’eau dont elles ont besoin pour se développer et donc les processus d’échange d’énergie avec l’atmosphère via les processus d’évapotranspiration qui jouent aussi un rôle important aux échelles météorologiques et climatiques.

Qui dit végétation, dit évidemment photosynthèse et donc aussi cycle du carbone, et stockage et déstockage de gaz carbonique en fonction des conditions climatiques dont l’humidité des sols est à la fois un acteur et un indicateur.

Enfin à court et moyen terme l’humidité des sols, directement et via la végétation qu’elle entretient, a un impact sur le régime hydrologique : ruissellement , infiltration, alimentation des nappes phréatiques etc…

Météorologie, Climat, Hydrologie, Végétation et cycle du carbone ont tous besoin d’introduire l’humidité des sols dans leurs modèles de prévision.

C’était une lacune, mais SMOS la comblera.La salinité de surface de l’océanLa salinité évoque a priori le sel plutôt que l’eau, si ce n’est que précisément, c’est du sel dans l’eau et que sa valeur dans l’océan, que l’on exprime en UPS, est voisine de 35 et varie en relation avec le cycle de l’eau.La salinité de surface varie d’une région océanique à une autre de 27 UPS dans les mers du plateau continental arctique à 40 UPS en Mer Rouge et dans le Golfe Persique.

Elle est le reflet :

- des échanges énergétiques entre l’océan et l’atmosphère d’une part, via les processus d’évaporation (qui concentre) et de précipitation (qui dilue)

- et l’océan et la cryosphère d’autre part, via les processus de congélation (qui concentre) et fusion (qui dilue),

processus qu’il est très difficile de mesurer directement et qu’il est pourtant nécessaire de quantifier correctement car ils sont cruciaux dans la dynamique du climat, et qu’il est nécessaire de bien les paramétrer dans les modèles de simulation de l’évolution du climat.

C’est l’océan qui fournit à l’atmosphère (via l’évaporation principalement) l’essentiel de son énergie :

- 50% contre 30% à l’absorption directe de l’énergie solaire

- et 20% pour les continents et la biosphère qu’ils portent.

Le satellite SMOS fournira tous les dix à trente jours une carte de la salinité des surface à 0,1 UPS près, avec une résolution de 200 x 200 km : indication sans cesse renouvelée de l’évolution des échanges énergétiques entre océan et atmosphère notamment dans les régions tropicales où ils sont le plus intenses.

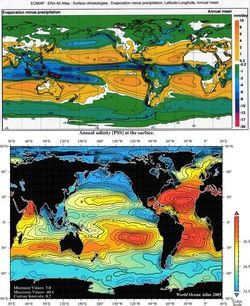

Les cartes d'évaporation-précipitation et de salinité de surface témoignent de la relation qui les lie.

On voit en effet sur les deux cartes ci-contre qui représentent respectivement les moyennes annuelles globales d'évaporation-précipitation et de salinité, que les maxima de salinité dans l'océan Atlantique et dans l'océan Pacifique correspondent aux maxima d'évaporation et que les minima de salinité correspondent aux maxima de précipitations.

La salinité est aussi un paramètre essentiel de la circulation océanique et donc du transport de chaleur par les courants océaniques. C’est elle avec la température qui détermine la densité de l’eau dont les variations sont le moteur de ce que l’on appelle la «circulation thermohaline».

L’exemple le plus fameux et à juste titre compte tenu de son importance dans le système climatique, est ce que l’on appelle de manière imagée le tapis roulant qui prend naissance dans l’Atlantique nord et qui est la conséquence directe du fait que les eaux de surface de l’Atlantique tropical nord sont très salées, beaucoup plus que celles du Pacifique nord où ce phénomène n’a pas lieu.

Les courants océaniques : Gulf Stream, puis Dérive Nord Atlantique transportent vers le nord des eaux très salées donc denses. Dans les mers du Groenland et de Norvège ces eaux densifiées par le refroidissement et une sursalure induite par la formation de la banquise plongent jusqu’à 3500 mètres de profondeur et s’écoulent vers le sud dans tout l’océan. Ce mécanisme fait que le transport de chaleur vers le nord par les courants océaniques est beaucoup plus important dans l’Atlantique que dans le Pacifique avec des conséquences climatiques bien connues, mécanisme dont on craint qu’il ne s’arrête pour cause d’une diminution de la salinité dans l’Atlantique tropical par modification du bilan évaporation-précipitations et / ou dans les mers du Groenland et de Norvège en raison d’un excès d’eau douce (précipitations, diminution de la banquise, fonte des glaciers du Groenland).

SMOS sera notre observatoire permanent de l’évolution du «tapis roulant», comme il pourra l’être également dans les autres régions de l’océan où la dynamique océanique est dépendante des mouvements verticaux.Principe de la mesureL’instrument de mesure est un «radiomètre interférométrique à synthèse d’ouverture», MIRAS :

- radiomètre, car l’instrument mesure le rayonnement émis par la surface de la Terre à une longueur d’onde optimale donnée ici : 21 cm (bande L) qui a en outre l’avantage de ne pas être perturbée par les conditions atmosphériques. Toute matière émet de l’énergie sous forme de rayonnement électromagnétique mais l’intensité du rayonnement dépend des propriétés électriques de cette matière. C’est ce que l’on appelle son «émissivité» qui correspond à la quantité de rayonnement qu’elle peut émettre. La mission SMOS s’appuie sur le fait qu’à la longueur d’onde choisie, l’humidité et la salinité diminuent très significativement l’émissivité du sol et de l’eau de mer respectivement. De la mesure du rayonnement on peut ainsi déduire l’émissivité de la surface et donc l’humidité du sol ou la salinité de la mer.

- «Interférométrique à synthèse d’ouverture» car, et c’est une première pour ce type de radiomètre. A l’antenne de plusieurs dizaines de mètres d’envergure que nécessiterait un seul radiomètre pour obtenir une résolution suffisante, on substitue 69 radiomètres élémentaires répartis sur les trois branches en Y du satellite capables de mesurer la différence de phase du rayonnement incident. Un traitement approprié des observations à partir de toutes les combinaisons possibles des paires de récepteurs faites sous plusieurs angles différents au fur et à mesure que le satellite suit sa trajectoire permet de couvrir une zone de 3000 km de diamètre.

Le satellite est sur une orbite héliosynchrone quasi polaire (inclinaison : 98,44°) et couvre ainsi la totalité de la Terre. Il circule à une altitude de 758 Km. Sa durée nominale est de trois ans avec une possibilité de prolongation de deux ans.

2/2 Deux membres et un correspondant du Club à l'honneur !

Notre président Bruno Voituriez a été élu ce printemps, membre de l'Académie de Marine.

Océanographe Physicien, Docteur ès Sciences, il a travaillé sur les mécanismes physiques qui contrôlent la productivité des écosystèmes océaniques. Il a été responsable des programmes d’océanographie physique et spatiale de l’Ifremer puis directeur de la programmation de l’ORSTOM (actuel IRD). Coordinateur des programmes français d’océanographie physique relevant du Programme Mondial de Recherche sur le Climat, il a été président du Comité National Français pour la COI (Commission Océanographique Intergouvernementale de l’Unesco).Déjà lauréat du prix Science et Défense, notre ami Michel Lefebvre se voit doublement honoré cet automne par l'Académie de Marine qui lui a attribué le prix André Giret, et par l'Académie des Sciences qui lui a attribué le prix EADS "Sciences et Ingénierie".

Michel, d'abord capitaine au long cours, est entré au CNES en 1963. La richesse et la variété de ses propositions l'ont conduit à participer :

- aux investigations de la sonde américaine Magellan autour de la planète Venus,

- à la mise en place du réseau d'orbitographie précise Doris,

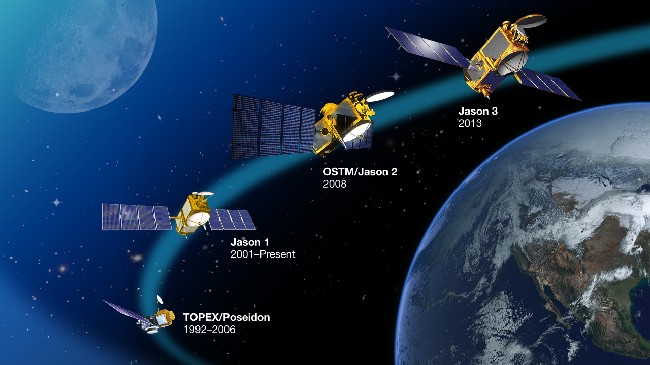

- à être le promoteur infatigable, puis le premier responsable scientifique, côté français, de la filière d'altimétrie océanique de haute précision inaugurée avec le satellite franco-américain TOPEX-Poseïdon.

Cette aventure extraordinaire se poursuit aujourd'hui avec la série Jason-1, Jason-2 et bientôt Jason-3.Pour parachever ce brillant tableau, durant l'été, notre correspondant à Hawaii, Gérard Nihous

a été nommé professeur dans le département de génie océanique ("Ocean and Resources Engineering") de l'Université de Hawaii.

Gérard est un spécialiste internationalement connu des énergies marines en général et de l'énergie thermique des mers en particulier, ce qui explique son lien privilégié avec les Argonautes. Ces travaux ont porté notamment sur l'exploitation de la ressource renouvelable et sur l'évaluation de l'impact environnemental correspondant. Il a d'ailleurs, en liaison, avec le Club donné deux brillants exposés lors de la conférence ICOE 2008 à Brest.

Quelques références :

Le Gulf Stream Bruno Voituriez

Les Humeurs de l'océan. Effets sur le climat et les ressources vivantes. Bruno Voituriez

Mois d'octobre 2009

1/2 Pour une Veille Mondiale Océan et Climat (VMOC)

Comme pour la prévision du temps, la prévision océanique (la "Météo de l'Océan"), exige un réseau global, permanent, et pérenne d'observations. Dix ans après la conférence "OceanObs99" qui s'était tenue à Saint Raphaël, a eu lieu, à Venise cette fois, "OceanObs 2009" (du 21 au 25 septembre).

Loin du tapage médiatique autour de la nouvelle campagne de "Tara", de la Boudeuse, (ou de la construction du Sea Orbiter...), plus de 600 participants venus de 36 pays ont joué à ce jeu cruel qui consiste à choisir les "impasses observationnelles"... que des moyens forcément limités rendent obligatoires !

Les lecteurs familiers de ce site savent que l'océan est un formidable réservoir d'énergie et de matière, (minérale ou organique), et que, depuis peu, les phénomènes dynamiques dont il est le siège peuvent être prévus à des échéances de quelques semaines; (tout comme, depuis plusieurs décennies, les futures conditions météorologiques le sont, pour des échéances de quelques jours).

Cependant les structures tourbillonnaires,cycloniques ou anticycloniques, déterminées par le profil de densité dans la colonne d’eau,ont une extension géographique 10 à 20 fois plus petite que les dépressions ou les anticyclones atmosphériques.

Les observations, (in situ ou depuis l'espace), doivent donc être assez nombreuses pour permettre la description de structures de taille plus restreinte. Même s'il y en a de plus en plus, (plusieurs milliers par heure), les observations demeurent largement insuffisantes, face à l'immensité de l'océan mondial.

Ceci explique pourquoi le Club s'inquiète de la médiatisation excessive d'opérations comme Tara, La Boudeuse, ou Sea Orbiter, qui est de nature à égarer l'opinion, en laissant croire que l’océan est totalement inconnu car inobservé, et que les quelques mesures -actuelles ou futures- qui sont -ou seront- effectuées à bord de ces navires vont révolutionner la science océanique, alors qu’elles ne présentent qu’un intérêt très marginal.

Il n'en a d'ailleurs pas du tout été question à Venise, de même, hélas, que... la conférence OceanObs 2009 a été totalement ignorée par les divers... Magazines de la mer ! Le Club des Argonautes s'efforce, de "lancer des passerelles" entre des professionnels des 2 bords: scientifiques d’un côté, journalistes de l’autre.

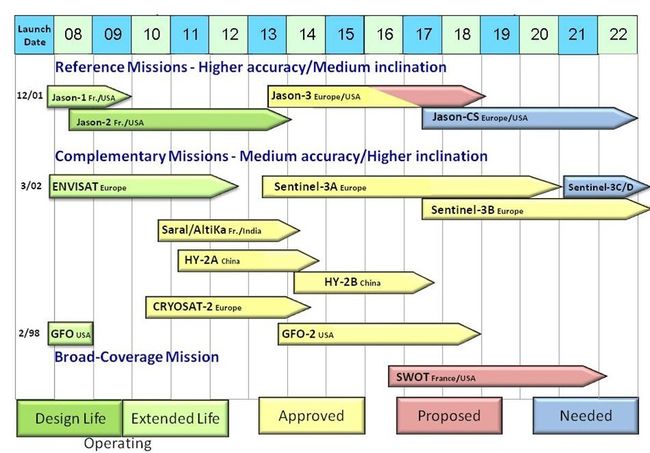

Il existe de nombreux systèmes d’observation de l’océan, in situ ou spatiaux, comme par exemple la constellation d'altimétrie", discutée notamment lors de la réunion OSTST de Seattle :

Leur existence comme la nécessité de les développer, semblent inconnues des médias, du public, et des politiques qui semblent plus séduits par les lettres de mission octroyées à des adeptes du tourisme océanographique. Et pourtant les enjeux sont d’importance et en découlent des conséquences logiques majeures :

- comme en Météo, aucun pays ne peut effectuer seul la totalité des observations nécessaires,

- comme en Météo, la mise en commun en temps réel des mesures faites est de rigueur: une observation qui n'est pas partagée perd rapidement une grande partie de son intérêt (le non partage, c'est du "Perdant-Perdant" !)

- comme en Météo, le coût de la prévision est dominé par celui du réseau d'observations, tandis que les bénéfices qu'elle peut faire naître concernent des secteurs socio-économiques aussi divers que le transport maritime, la protection des zones littorales, (artificialisées ou non), le tourisme, les sciences du climat, la pêche, la Défense, la production d'énergie, ou les activités off shore. Faute de pouvoir recueillir l'ensemble de ces bénéfices, (ou pertes évitées, à court et à moyen terme), aucun acteur économique privé n'est en mesure d' assumer la charge correspondante, de sorte que le financement public du réseau d'observation est une condition nécessaire de son existence.

- à la différence de la Météo... il n'existe aucun tissu d'accords inter-gouvernementaux, comparable à la Veille Météorologique Mondiale (VMM), qui relie des agences nationales chargées explicitement d'assurer la permanence d'observations opérationnelles définies à l'avance, conformes à un cahier des charges adopté par l'Organisation Météorologique Mondiale.

Bien sur, il existe une COI (Commission Océanographique Intergouvernementale), qui fêtera ses 50 ans en 2010. Quoiqu'inter-gouvernementale, elle n'est qu'un programme scientifique de l'Unesco sans vocation opérationnelle. Les projets qu'elle coordonne, (en particulier son programme GOOS: Global Ocean Observing System), se font sur une base non contraignante, selon le bon vouloir de quelques Etats Membres qui ont choisi d'y contribuer. Et, à l'exception de quelques grands pays, (USA et Australie, notamment), il n'existe pas de structures équivalentes aux offices Météo nationaux.

Lorsqu'il s'agit d'assurer la pérennité de plusieurs milliers d'engins autonomes dans l'océan et, très au dessus... de plusieurs filières d'observation multi-satellites un réseau d'agences publiques, (équivalentes àcelles sur lesquelles repose la VMM, dans les différents pays), est... indispensable !

Les grandes espérances pour une "Veille Mondiale Océan et Climat"... (que le Club des Argonautes prône depuis plusieurs années),ont été portées successivement par le CEOS... par IGOS... par GEOSS, et dernière en date... l’Équipe spéciale de haut niveau sur le Cadre mondial pour les services climatologiques (!) qui intervient quelques années après... la mise en place d'une structure commune à la COI et à l'OMM: JComm. (Voir par exemple le point 6 de la 3ieme réunion de la JCOMM).

Ce "tuilage" d'initiatives successives trahit peut être la difficulté d'acquérir une vue d'ensemble de la situation institutionnelle... En outre, on ne connaît guère d'autre moyen de passer de comités purement scientifiques àdes structures inter-gouvernementales, capables de faire naître des engagements internationaux ! La question de la rivalité éventuelle entre organisations internationales était, à juste titre, posée lors de la dernière conférence ministérielle de l'Unesco ("Quel rôle devraient jouer l’UNESCO et la COI, parallèlement au PNUE et autres institutions spécialisées de l’ONU ?").

En attendant de pouvoir un jour démêler cet écheveau institutionnel... chacun peut comprendre le rôle vital des 2 premières conférences OceanObs, tenues à 10 ans d'intervalle: en l'absence d'une "VMOC" (Veille Mondiale Océan et Climat"), ces rencontres permettent de déterminer les systèmes opérationnels d’observation de l’océan qu’il est indispensable de pérenniser pour les diverses applications évoquées ci dessus.

Sans oublier la fragilité que constitue l'absence d'accords inter-gouvernementaux, le Club se réjouit de constater l'efficacité relative de cette démarche. Le programme préconisé à Saint Raphaël il y a 10 ans, est largement réalisé: certains de ses aspects constituent une... véritable "rupture" ! Par exemple:

- La "Révolution Argo": ces 3000 flotteurs de sub-surface qui, tous les 10 jours, échantillonnent l'océan jusqu'à une profondeur de 2 km, renvoient quotidiennement près de 300 profils de température et salinité,

- L'usage, qui se répand rapidement, de marques électroniques sur divers animaux marins, devenus "nouvelle plate-forme pour mesures in situ". (Les anglo-saxons parlent de "Bio-logging" à l'aide de "tags"...)

- L’approche coordonnée pour traiter de problèmes communs, (comme l’absorption du CO2), à 3 sous-disciplines/communautés d'océanographes: Océano Physique, Océano Chimique, et Océano Biologique. Les progrès scientifiques apportés par les observations et la modélisation ont rendu possible cette convergence; il faut saluer, à ce propos, un exposé particulièrement mordant d'Hervé Claustre du Laboratoire d'Océanographie de l'Obervatoire Océanologique de Villefranche sur Mer (L'étude du cycle du carbone va-t-elle enfin pouvoir être abordée... "de manière holistique" ?), ainsi que celui de U. Send, relatif à l'Ocean Observatories Initiative de la NSF des Etats Unis.

- L'exigence de continuité des observations est maintenant bien reprise parles nombreux programmes ou agences concernés(ESA, GMES, COI, GEOSS, OMM, Etc.).En témoigne en particulier l'apparition de nouveaux "mots clé"... à la "World Climate Conference" de début septembre à Genève (WCC3): Ocean Climate Services... et ECV: Essential Climate Variables !

- En même temps se dégage le concept de "constellations virtuelles" qui consiste à associer plusieurs satellites conçus de façon indépendante, dont les observations sont complémentaires, surtout lorsqu'elles peuvent être proches dans l'espace (géographique !) et dans le temps. L'usage fécond d'observations "co-localisées après coup"... (par opposition au tandem Jason1-Jason2, ou au "A Train", qui sont de réelles constellations, mises en orbite à cet effet), est un héritage du projet Pilote GODAE/ GHRSST, lancé à Saint Raphaël, qui a permis de mettre de l'ordre dans les produits historiques, (issus des satellites météo), de température de la surface océanique, produits conçus de façon très hétérogène il y a 30 ans.

- Avec le lancement de SMOS par l'ESA, début novembre (qui sera bientôt suivi par son homologue Nasa), il existe désormais des constellations virtuelles pour chacun des paramètres de la surface océanique que l'on peut mesurer depuis l'espace: température (SST), topographie (SSH), salinité (SSS), coefficient de rétro-diffusion à l'interface océan-atmosphère (un indicateur Vents/Vagues), et Couleur de l'Eau (OC, un indicateur de l'activité biologique).

A noter le lancement réussi, le 23 septembre (pendant la conférence à Venise !), du satellite Indien Oceansat-2, dont le diffusiomètre viendra opportunément prendre le relais de celui de QuikScat: après 10 ans de bons et loyaux services, ce satellite comportant une antenne tournante pour la mesure du vent en surface, commence à donner quelques signes de vieillesse ! A noter que la longévité record de cet engin illustre, (comme celles de TOPEX-Poséidon ou Jason-1), le travail de bénédictin et l'obstination qui ont permis, (de façon totalement indépendante de la COI ou de l'OMM), d'assurer la continuité des observations !

La qualité du travail des agences spatiales doit être saluée et surtout, le relais de leur action doit être pris !

La difficulté de cette transition, de la recherche aux applications, est en quelque sorte "multidimensionnelle": ceux qui, comme les Argonautes, se sont réjouis, il y a quelques années du passage "en opérationnel" du réseau de bouées TAO, ont appris sans plaisir une certaine décrépitude de ce système, depuis qu'il ne bénéficie plus des "bons soins" du NOAA/PMEL (le labo de recherche qui l'a mis en place...), du fait du découpage de taches au sein de la Noaa !

Les "bonnes paroles" de la biologiste Jane Lubchenco (son nouvel Administrateur), dans une vidéo de près de 20 minutes... n'ont guère rasséréné nos collègues américains ! Heureusement que, du coté des satellites, la transition de Jason-1 à Jason-2, (d'un leadership Cnes-Nasa vers un leadership Eumetsat-NOAA), se déroule parfaitement !

Après OceanObs 1999 et 2009, espérons qu’il ne sera pas nécessaire d’attendre 2019 pour que, (Grenelle de la mer aidant ?), les décisions politiques adéquates soient prises pour la mise en œuvre fiable d’une Veille Mondiale Océan et Climat !

2/2 Coup de cœur : la Nouvelle-Calédonie

Dans leurs pérégrinations océanographiques, trois des Argonautes ont jeté, pendant plusieurs années, l’ancre en Nouvelle-Calédonie d’où ils explorèrent le vaste Océan Pacifique.

Océanographes, ils n’en sont pas moins terriens et ils découvrirent avec étonnement une Terre très originale qu’ils parcoururent de l’île Ouen à la fascinante Plaine des Lacs, aux îles Belep, ou encore de Nouméa à Hienghène.

La Grande Terre et son immense lagon, la Grande Terre et sa diversité biologique à nulle autre pareille.

Mais aussi, la Grande Terre et son nickel dont l’exploitation depuis 150 ans se fait hélas au détriment du lagon, réceptacle des sédiments charriés en abondance depuis les zones d’exploitation. La biodiversité terrestre est détruite par la mise à nu et la destruction de toute végétation sur de grandes surfaces.

Ces Océanographes terriens, vous invitent à découvrir cette richesse et les menaces qui pèsent sur elle en prenant connaissance de l’article de Michel Pascal et Bertrand Richer de Forges paru dans le numéro 384 de la revue Pour la Science d’octobre 2009 : La biodiversité de Nouvelle Calédonie menacée.

Mois de Août/Septembre 2009

1/1 Activité solaire et réchauffement climatique. Vers un nouveau cycle de Maunder ?

Pour ce qui est de l'activité solaire :

Depuis des siècles l'homme a observé que le soleil manifestait une activité périodique : sur des périodes successives de 11 ans, le nombre de taches à sa surface croît puis décroît.

Ce cycle d'apparition des taches solaires est couplé à un cycle du champ magnétique solaire de période 22 ans. Un cycle solaire correspond à une alternance de la polarité magnétique hémisphérique du soleil. Le dernier maximum solaire, (nombre maximum de taches solaires), a culminé en 2001 et a produit d'importantes perturbations géomagnétiques, jusqu'à mettre en péril les électroniques et les panneaux solaires des plates-formes spatiales soumises à ces effets.

Mais quelque chose de particulier semble se produire actuellement, comme le signalent dans EOS Transactions (Volume 90 – N° 30) deux chercheurs, W. LIVINGSTON et M. PENN, du National Solar Observatory (NSO) de Tucson- Arizona. Le minimum d'intensité solaire dans lequel on est actuellement, corrélé à l'absence de taches solaires, dure depuis près de 2 ans (670 jours en juin 2009), un événement qui ne s'est pas produit depuis 1933.Ce qui concerne les climatologues dans cette anomalie, c'est le fait que, dans le passé, une très longue période d'absence de taches solaires a déjà été observée, de 1645 à 1715, appelée le «minimum de Maunder». Elle a correspondu à une période de refroidissement généralisé des températures enregistrées en Europe, appelé le «petit âge glaciaire».

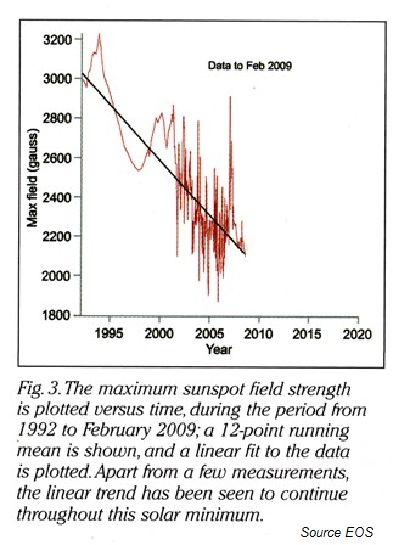

Des modèles et des observations spatiales récentes ont effectivement montré que les périodes d'absence de taches solaires correspondaient à une baisse du rayonnement solaire total reçu par la Terre, et donc à un refroidissement. A partir des observations faites pendant 13 ans par le télescope du «Mc Math-Pierce Observatory» à Kitt Peak et publiées en 2006, M. PENN et W. LIVINGSTON déduisent de l’évolution de l'intensité (la force) du champ magnétique autour des taches solaires... que celles-ci pourraient disparaître complètement à partir de 2015 !

Des modèles et des observations spatiales récentes ont effectivement montré que les périodes d'absence de taches solaires correspondaient à une baisse du rayonnement solaire total reçu par la Terre, et donc à un refroidissement. A partir des observations faites pendant 13 ans par le télescope du «Mc Math-Pierce Observatory» à Kitt Peak et publiées en 2006, M. PENN et W. LIVINGSTON déduisent de l’évolution de l'intensité (la force) du champ magnétique autour des taches solaires... que celles-ci pourraient disparaître complètement à partir de 2015 !

Ces observations ont conduit certains scientifiques à se demander si les taches solaires de ces dernières années étaient différentes de celles des périodes antérieures. Les réponses ne sont pas claires, mais les données du «Mc Math – Pierce Observatory» détiennent probablement des indices pour préciser les relations, encore mal connues, entre taches solaires, rayonnement total et champ magnétique solaire. D’où l’importance de mesurer l’activité magnétique du soleil en cette période apparemment anormale d’activité solaire minimum.Assiste-t-on à une décroissance à long terme des taches et du rayonnement solaires, suggérant l'entrée dans une période équivalente au «minimum de Maunder» ?

C'est une question ouverte, bien que les taches solaires devraient réapparaître, comme l’ont suggéré, en Juin 2009, deux autres chercheurs du NSO, Rachel Howe et Frank Hill, au cours d’une conférence de l’American Astronomical Society à Tucson ; en s’appuyant sur l’observation du champ magnétique qui a changé de polarité, ils montrent que l’on est bien entré dans un nouveau cycle solaire.

Pour ce qui est du réchauffement climatique :

Cependant, même si l’on assistait à une disparition durable des taches solaires pendant plusieurs dizaines d’années, voire un siècle, comme se fut le cas au XVIIème siècle, (ce que certains scientifiques jugent à nouveau possible), bloquant ainsi le rayonnement solaire à son minimum, (estimé à environ 1 365 W/m2), cela ne ferait que lui soustraire environ 1 W/m2 en moyenne.

D'un autre coté, les chiffres du forçage radiatif d'origine anthropique retenus par le Groupe de Travail n°1 du GIEC dans le 4ieme Rapport (janvier 2007) sont les suivants :

- Accroissement de la concentration des gaz à effet de serre: +2,30 W/m2.

- Aérosols d’origine humaine: -0,50 W/m2.

- Variation de l’albédo lié aux nuages: -0,80 W/m2.

- Accroissement de l’ozone du aux activités humaines: +0,35 W/m2.

- Halo carbones: +0,34 W/m2.

- Variation de l’albédo du à la modification de l’usage des sols: -0,20 W/m2.

- Variation de l’albédo du aux retombées des suies sur la neige: +0,10 W/m2.

Pour pouvoir comparer l'hypothèse d'une diminution de 1 W/m2 du rayonnement solaire atteignant l’atmosphère avec le forçage radiatif d'origine anthropique net, (estimé par le GIEC à 1,6 W/m2, comme l'indique un bilan global des valeurs ci dessus), il faut tenir compte de 2 facteurs :

- d'une part, l'albédo de la Terre, qui renvoie dans l'espace 30 % en moyenne du rayonnement solaire incident,

- d'autre part la forme sphérique de la Terre, qui conduit à diviser par 4 la diminution du rayonnement solaire pénétrant effectivement dans notre biosphère (0,7 W/m2 sous l'hypothèse faite, et en tenant compte de l'albédo terrestre). En effet, la surface du disque qui intercepte le rayonnement solaire(un grand cercle de la sphère planétaire : πR2), n'est que le quart de la surface du globe terrestre : 4πR2.

Au total, l'hypothèse d'une diminution de 1 W/m2 du rayonnement solaire atteignant l’atmosphère se traduirait par une réduction d’environ 0,18 W/m2 du forçage radiatif provenant du soleil. Comparé au forçage radiatif d'origine anthropique net, estimé par le GIEC à 1,6 W/m2, cela ne représenterait qu’une baisse voisine de 11%, qui ne serait pas de nature à diminuer de façon substantielle le réchauffement climatique en cours, causé par nos émissions de gaz à effets de serre.

Ce qui ne signifie pas qu’il n’y aurait pas, dans une telle hypothèse, d’impact climatique significatif au niveau régional notamment. En effet si la baisse de la température moyenne globale n’a été que 0,3-0,4°C au plus froid de la période de Maunder (à peine la moitié de ce que l’accroissement de l’effet de serre a déjà provoqué) elle fut comprise entre 1 et 1,5°C en hiver en Europe ce qui n’est pas rien.

Cela résulte de la complexité des relations entre la Terre et le rayonnement solaire dont on ne peut réduire simplement les variations à celles du rayonnement total. Les variations dans le rayonnement ultraviolet sont relativement beaucoup plus importantes que celle du rayonnement global et ont un impact important (température, circulation, couche d’ozone) sur la stratosphère, la couche atmosphérique entre 10 et 50 Km d’altitude au-dessus de la troposphère dans laquelle nous vivons.

Stratosphère et troposphère ne sont pas indépendantes l’une de l’autre. Elles interagissent et les perturbations de la stratosphère ne sont pas sans conséquence sur la circulation atmosphérique dans la troposphère. Ainsi en fut-il pendant la période de Maunder caractérisée par un affaiblissement notable du rayonnement ultraviolet qui via la stratosphère installa durablement la NAO en phase négative. La NAO (North Atlantic Oscillation) est caractérisée par la différence de pression atmosphérique entre le système anticyclonique des Açores et le système cyclonique dépressionnaire d’Islande. Lorsque cette différence est élevée(indice NAO positif) les vents d’ouest qui circulent en hiver sur l’Atlantique sont forts et l’Europe bénéficie d’un climat hivernal doux et humide. A l’inverse si les différences de pression sont faibles (indice NAO négatif), privée de ces afflux d’air maritime l’Europe connaît un hiver froid et sec. C’est ce qu’il advint pendant la période de Maunder de faible activité solaire qui, ironie de l’histoire, correspond très exactement au règne de Louis XIV dit Roi Soleil, peut-être pour conjurer le mauvais sort climatique.

Si nouveau cycle de Maunder il y avait, cela ne compenserait pas, loin de là, la perturbation anthropique de l’effet de serre mais pourrait néanmoins modifier les prévisions régionales que l’on fait de l’inéluctable changement climatique.

Mois de Juillet 2009

1/1 Le Conseil d'Eumetsat ouvre la voie à la réalisation de Jason-3.

Le Club des Argonautes se réjouit de voir réunies les conditions permettant de "boucler le tour de table" relatif à Jason-3 d'ici 2010, ce qui devrait rendre possible un lancement 40 mois après, c'est à dire au début de l'été 2013, juste 5 ans après le lancement parfaitement réussi de Jason-2, en juin 2008.

La fabuleuse moisson d'observations, notamment de cet indicateur essentiel du changement climatique en cours qu'est le niveau moyen des mers, résulte désormais d'une volonté politique clairement exprimée, confortée, il est vrai, par... le "chapelet de miracles" qui se sont succédés, depuis le lancement de TOPEX-Poséïdon, il y a plus de 16 ans !

Avec, entre autres, un passage en mode survie en décembre 1995 qui avait causé quelques frayeurs pour... "retrouver la sortie" ! Avec aussi... des batteries dont on craignait qu'elles ne durent pas 3 ans, et qui ont finalement établi un record de longévité, notamment grâce à la surveillance "TLC" (Tender Loving Care !), définie par les ingénieurs du JPL.

Dés octobre 1997, (4 ans avant le lancement de Jason-1), le CNES avait proposé à la NASA, lors d'une réunion du Joint Steering Committee Jason, en marge du Symposium "GODAE" de Biarritz, de commencer à discuter de la réalisation de Jason-2, en y associant les 2 agences météo-océaniques opérationnelles que sont la NOAA et Eumetsat.

Il valait mieux commencer tôt... puisque "la convergence sur Jason-2" entre ces 4 agences a tout de même demandé... 7 ans de réflexion ! (sachant que chacune des 4 agences a vu arriver à sa tête, au cours de cette période, un nouveau responsable auprès duquel le travail de conviction déjà accompli était recommencer... au moins en partie !)

Au delà des miracles... la coopération internationale a joué un rôle clé dans la transition, en voie de réussite, de ce que nos collègues américains ont comparé, il y a quelques années à "une traversée de la Vallée de la Mort", c à d. le passage du "mode recherche" au statut "opérationnel", (qui implique de justifier, puis faire prendre en compte, l'exigence de continuité des mesures, cruciale en période de changement climatique).

Le couple gagnant que constitue la vision et la volonté, présent depuis le début, a rendu possible la continuité d'une série de mesures de haute précision relative à la topographie dynamique de l'océan, qui, dans un monde idéal, devrait être reconnue par les États membres de l'Unesco comme... un élément du "Patrimoine de l'Humanité"!

Lors de la présidence française de l'UE en 2000, notre pays a proposé à ses 14 partenaires de l'époque le programme GMES (Global Monitoring for Environnement and Security), dont la composante la plus avancée est le "Marine Core Service", qui devrait être mis en place par l'UE d'ici 2013, dans le sillage du projet européen "MY OCEAN", démarré il y a 3 mois et demi.

La série de satellites altimétriques de haute précision que montre l'illustration ci dessous, apporte une contribution éminente à ce projet ainsi qu'a la future Veille Mondiale Océan et Climat ("VMOC"), que le Club juge indispensable, notamment pour le suivi de l'efficacité des engagements "Post Kyoto" qui devraient être pris à Copenhague en décembre.

Avec un peu de chance, la série de mesures de hauteurs dynamiques de l'océan, entamée fin 1992, pourra donc se poursuivre sur plus de 25 ans, jusqu'en 2018 et même au delà.

Les dépenses de notre pays dans cette filière sont importantes: de l'ordre de 20 millions par an en moyenne sur 20 ans, pour la seule part française (dont un peu plus de la moitié sur TOPEX-Poséïdon, un tiers sur Jason-1 et 2, et le reste pour les 16 années de maintien en condition opérationnelle de ces 3 systèmes spatiaux).

Il est regrettable que la nécessaire continuité des investissements de la communauté internationale dans une flottille de satellites à vocation océanique ne soit même pas mentionnée dans les divers rapports du Grenelle de la Mer ! Outre les contributions françaises antérieures aux projets de l'ESA (ERS 1 et 2, Envisat), il convient d'ajouter celles en cours pour Sentinel 3A et 3B, Saral et Jason-3. La capacité de prévision océanique visée, tant pour le domaine hauturier que pour les zones côtières, implique en effet la présence en orbite d'au moins 3 satellites altimétriques, dont au moins un de haute précision.

Les différents "COMOP" (Comité Opérationnel) qui succéderont au Grenelle de la Mer devront prendre en compte les atouts -et les responsabilités- de notre pays dans le domaine émergent de l'océanographie opérationnelle, ainsi qu'en témoigne son rôle leader dans la mise en place du Marine Core Service, dont le GIP Mercator, en voie de transformation en société civile, est le coordonnateur.

Sous réserve que les quelques~0,4 % du budget qui concernent les "long lead items" puissent être engagés sans tarder... (une des raisons qui fondent une loi immanente du secteur spatial: "Tout ce qui n'est pas décidé aujourd'hui ne volera pas dans 4 ans !")

Mois d'Avril 2009

1/1 Grenelle de la Mer : ne pas oublier l'océanographie opérationnelle !

L'océan est un acteur essentiel du fonctionnement de la biosphère terrestre constituée des couches superficielles de la Terre où la vie a pu s'épanouir.

Sa dynamique est à prendre en compte dans le fonctionnement du système climatique dont il contrôle les variations.

Principal accumulateur d'énergie solaire, l'océan fournit à l'atmosphère 50 % de l'énergie qu'elle reçoit, et qui la met en mouvement.

Les courants marins, à égalité avec la circulation atmosphérique, assurent la redistribution de la chaleur des régions équatoriales vers les hautes latitudes.

Les écosystèmes marins sont aussi contrôlés par la dynamique océanique : ce sont les mouvements horizontaux et verticaux de l'océan qui déterminent la fertilité des " prairies marines " et contrôlent les conditions de survie des larves des espèces exploitées au large comme à la côte.

C'est aussi la dynamique océanique qui façonne les littoraux à partir des apports fluviatiles, anciens et récents.

Il n' y a pas de prévision possible de l'évolution du climat, de celle des écosystèmes marins et des espèces exploitées, et de l'évolution des zones côtières, sans connaissance de la dynamique océanique et sans la capacité de la modéliser aux diverses échelles de temps et d'espace concernées.

La prévision opérationnelle de l'état des océans est maintenant possible, comme c'est le cas de l'atmosphère.

A l'instar de ce qui existe, pour les besoins de la prévision météorologique, cela implique des systèmes d'observation continus de l'océan et des centres opérationnels de prévision mettant en œuvre des modèles de circulation océanique alimentés par ces observations.

Les satellites sont la clé des mesure en mer.

D'une part, ils permettent de mesurer directement, sur la totalité de l'océan, les paramètres essentiels que sont la température de surface, la vitesse et la direction du vent, la hauteur du niveau de la mer et d'évaluer les courants marins et leurs variations. On dispose, par exemple, depuis 1992 grâce au satellite TOPEX/Poseidon et à ses successeurs Jason 1 et 2, d'une série ininterrompue de la mesure du niveau de la mer et de la circulation océanique.

D'autre part, grâce aux systèmes de localisation et de transmission des données, ils permettent de déployer des flotteurs dans tout l'océan, équivalents de ce que sont les ballons sonde pour l'atmosphère.

Actuellement, dans le cadre du programme ARGO, ce sont trois mille flotteurs qui explorent les couches océaniques sur deux mille mètres d'épaisseur, en faisant des mesures de température et salinité qu'ils transmettent en temps réel par satellite. L'état de l'océan est ainsi presque complètement déterminé et, en France, le Groupe Mercator-Océan à Toulouse, assimilant toutes ces données dans des modèles de circulation océanique, fait des prévisions de la totalité de l'océan aux échelles globales et régionales.

Dans le cadre du programme européen GMES, Mercator Océan est coordinateur du projet My Ocean qui doit définir d'ici trois ans les contours d'une océanographie opérationnelle (Marine Core Service).

A cela il faut ajouter que les moyens spatiaux permettent de surveiller les écosystèmes marins : mesures depuis l'espace de la chlorophylle de surface et des stocks de grands pélagiques comme les thons qui; équipés de marques " pop up ", deviennent eux-mêmes des plates-formes, de mesures comme les flotteurs ARGO. C'est à court terme la prévision de l'évolution des écosystèmes marins et de leurs ressources qui est aussi en jeu.

Tout semble donc aller pour le mieux dans le meilleur des mondes possibles et l'on pourrait ainsi comprendre que le " Grenelle de la Mer " n'évoque pas cette nécessité d'une océanographie opérationnelle, si ce n'est que justement, pourtant indispensable et nécessaire du point de vue des 4 thématiques du Grenelle de la Mer, elle n'existe pas.

Ou plutôt, elle n'est qu'expérimentale.

Financée sur des crédits de recherche, elle n'est finalement de la responsabilité de personne.

- Rien ne garantit aux plans national et international la continuité des mesures satellites ou in situ;

- Rien ne garantit la pérennité du Groupement Mercator-Océan.

Au plan européen le projet My Ocean concerne 27 pays et mobilise plusieurs dizaines de laboratoires de recherche sans la moindre garantie que le relais sera pris ensuite pour la mise en œuvre du " Marine Core Service ".

Neuf ans après que notre pays eut proposé l'initiative GMES à ses partenaires européens, (pendant la "PFUE 2000"), il serait paradoxal que le Grenelle de la Mer ne fasse pas sienne cette impérieuse nécessité d'une prévision opérationnelle de la mer, pour le climat, la dynamique des écosystèmes marins et de leurs ressources et l'évolution des littoraux.

Sans cela, les objectifs affichés du " Grenelle de la Mer " ne sont pas atteignables. C'est l'outil dont on ne peut se passer pour une gestion intelligente de la mer à toutes les échelles de temps et d'espace ; en effet,exploiter de façon durable un milieu que l'on ne connaît pas, est impossible.Mais ce qui est l'affaire de tous doit maintenant être de la responsabilité de quelqu'un.

Compte tenu de l'existence depuis 2003, de l'initiative GEOSS, le Grenelle de la Mer se doit de recommander la mise en place d'une océanographie opérationnelle, incluant les systèmes d'observation et les centres de prévision océaniques, et d'en confier la charge à des agences nationales travaillant dans le cadre d'une coopération intergouvernementale, comme cela s'est fait pour l'atmosphère dans le cadre de l'Organisation Météorologique Mondiale (Veille Météorologique Mondiale).

Mois de Mars 2009

1/2 - Apocalypse now

Le Danemark sera hôte de la prochaine Conférence des Nations Unies sur le Changement Climatique qui se tiendra à Copenhague en décembre 2009. L’objectif de cette conférence est de décider les mesures à prendre au-delà du protocole de Kyoto en 2012.

Ce protocole adopté lors de la Conférence des Parties à la "Convention Cadre des Nations Unies sur les Changements Climatiques" à Kyoto, en décembre 1997, est entré en vigueur en février 2005, lorsque 55 pays représentant au moins 55% des émissions de CO2 des pays industrialisés l’eurent ratifié. Au 14 janvier 2009, 183 états plus l’Union Européenne avaient procédé à la ratification. Le protocole prévoyait une réduction des émissions de gaz à effet de serre de 5% en 2012 par rapport à 1990.Pour préparer cette conférence l’Université de Copenhague a organisé les 11 et 12 mars 2009 un congrès scientifique international sur le changement climatique. Ce congrès visait expressément à faire prendre conscience par les politiques de l’urgence des décisions à prendre lors de la conférence de décembre :“The main aim of the congress is to provide a synthesis of existing and emerging scientific knowledge necessary in order to make intelligent societal decisions concerning application of mitigation and adaptation strategies in response to climate change.”C’était une mise à jour des connaissances scientifiques utilisées par le GIEC pour son quatrième rapport du GIEC qui, compte tenu des délais de rédaction, dataient de quelques années.La presse s’est d’autant plus intéressée à cet événement que la teneur très alarmiste des communications présentées constituait un espèce de "friandise médiatique" ! Deux mille scientifiques y ont communié dans un bel unanimisme qui, on peut le prévoir, fera grincer les dents de quelques contestataires qui y verront davantage l’expression d’un lobby, qu'une démarche scientifique (qui impliquerait nécessairement, selon eux, une analyse critique laissant plus de place au débat public contradictoire dont se nourrit la recherche).En dépit de ces aspects de "Grand Messe", la réunion de la semaine dernière n’a rien là que de très rationnel et très scientifique.Les simulations de l’évolution du climat en réponse à l’accroissement des gaz à effet de serre faites par le GIEC ont deux sources d’incertitude:

- L’incertitude scientifique d’une part, liée à l'imperfection des modèles, en particulier aux processus qu'ils prennent en compte, et aux données elles mêmes.

- et d’autre part, celle liée aux scénarios d’évolution des émissions des gaz à effet de serre, qui dépendent des évolutions économiques et démographiques.

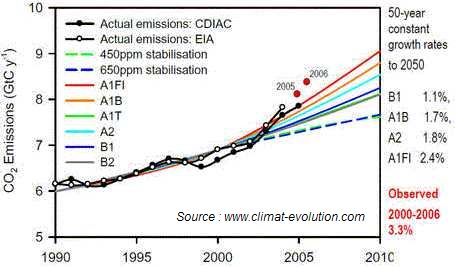

On peut dire que les fourchettes totales pour la décennie 2090-2099 données dans le rapport 2007, tous scénarios pris en compte, reflètent d'abord l’incertitude des scénarios, tant pour les accroissements de la température moyenne (1,1-6,4°C) que pour le niveau moyen des océans (18-59cm) . Tandis que les fourchettes, pour un scénario donné, sont la trace des incertitudes scientifiques. Par exemple, pour le plus mauvais scénario envisagé A1FI (augmentation des émissions de GES au rythme où il était dans les années 90 : +2,4% /an), la fourchette de température est de +2,4 à +6,4°C, et pour le niveau de la mer de +26 à +59 cm. Les scénarios du GIEC pour son dernier rapport datent de 2000, et sont les mêmes que ceux utilisés pour le rapport précédent (2001). La comparaison de ces scénarios avec la réalité, à savoir l’évolution des émissions de gaz à effet de serre effectivement constatée, est sans appel :

le taux d’augmentation des émissions de CO2 n’a pas cessé de croître depuis 2000 passant de moins de 2% à 3,3%. Autrement dit, nous sommes au-delà du scénario le plus pessimiste.

Les objectifs du protocole de Kyoto n’ont pas été atteints et, à ce rythme, les simulations du GIEC les plus noires deviennent obsolètes. Voilà qui justifie le signal d’alarme lancé à Copenhague, et la pression exercée sur les politiques pour qu’ils prennent compte de l’urgence, et dépassent l’horizon des prochaines élections qui est habituellement le leur.D’autant que parallèlement, du côté de la science et des observations de l’évolution du climat, il y a tout lieu de s’alarmer aussi. Le niveau de la mer est le meilleur indicateur que l’on puisse avoir de l’évolution climatique, puisqu’il intègre à la fois la température de l’océan et la fonte des glaciers et calottes polaires. Or, les plus récentes mesures des satellites gravimétriques GRACE, ont montré que depuis 2003, cette contribution à l’élévation du niveau de la mer est passée de 1,5 mm/an à 2,2 mm/an, soit une augmentation de 50%, signe d’une accélération imprévue du processus. Nous étions déjà sortis des limites de l’épure tracée par l’histoire de la variabilité du climat : jamais, dans le dernier million d’années qui a vu l’alternance de périodes glaciaires et interglaciaires, les teneurs en gaz à effet de serre n’ont été aussi élevées qu’actuellement; voilà que maintenant, à peine esquissées, nos prévisions sortent elles aussi de l’épure que nous nous étions nous mêmes fixée. Le pire est peut-être sûr: en cette année ou l'on célèbre le 400ième anniversaire des découvertes de Galilée, comment ne pas songer au propos qu'il aurait lancé aux contestataires mentionnés plus haut : "Et pourtant, elle fond !" Le GIEC, pour son prochain rapport à paraître en 2014, a mis en chantier la définition de nouveaux scénarios et se réunit à Antalya, en Turquie, les 21-23 avril 2009 pour préparer ce rapport et la conférence de Copenhague de décembre 2009, en prenant en compte les avancées scientifiques mises en lumière à la conférence de l’Université de Copenhague.

2/2 - GOCE : quarante après, le dernier rêve de Williamstown.

Le satellite GOCE vient d’être lancé avec succès par l’ESA le 17 mars 2009 à 15h35 UTC à partir du cosmodrome de Plesetsk avec une fusée russe

Rockot. Le cosmodrome est situé dans la région d’Archangel de Russie (62° 54' N et 40° 23' E). Plesetsk est la base spatiale la plus au nord de la Russie utilisée notamment pour lancer des satellites militaires depuis 1963.

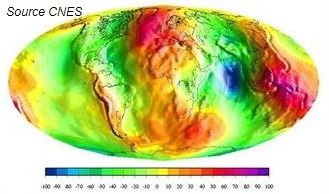

Comme son nom l’indique GOCE a pour objet principal de contribuer à l’étude de la circulation océanique quoique, au demeurant les applications de ce satellite soient en fait beaucoup plus nombreuses et concernent notamment l’étude de la Terre solide d’une manière générale à partir de la connaissance du champ de gravité.

Par ailleurs, la manière de contribuer à l’étude de la circulation océanique n’est pas du tout directe. En effet, la mesure brute de base est la mesure locale du gradient de gravité où orbite le satellite.

Le gradient de gravité est la mesure de la variation spatiale de la gravité autour de tout point. On peut en déduire le champ de gravité au niveau où orbite le satellite et in fine par extrapolation l’équipotentielle du champ de pesanteur au niveau de la mer. Cette équipotentielle s’appelle le géoïde. La verticale locale est perpendiculaire en tout point au géoïde. Or le géoïde qui est une équipotentielle particulière du champ de pesanteur terrestre épouse en première approximation la forme des mers et des océans d’où son intérêt. Connaître le géoïde, c’est donc connaître la forme des océans et des mers et leurs variations temporelles et fournir une référence pour leur connaissance et leur étude.

Le géoïde subit en effet des variations temporelles liées notamment à l’action gravitationnelle de la Lune et du Soleil et aux phénomènes des marées. Les transports de masse d’origine atmosphérique, océanographique, ou géophysique comme le rebond post glaciaire induisent également des variations. L’étude du géoïde est donc quelque chose de très complexe mais aussi de très riche impliquant de nombreuses études multidisciplinaires.

Ainsi la comparaison de ce géoïde avec la forme géométrique de la surface topographique des mers que l’on obtient par altimétrie spatiale (voir l’apport récent du satellite Jason 2 lancé en juin 2008) est une information majeure sur la circulation océanique. On peut en effet montrer que l’écart entre cette surface topographique et le géoïde est une mesure quasi directe des flux transportés par les grands courants océaniques. Les progrès à attendre sur notre connaissance résultent donc de tout un ensemble de missions d’observation de la Terre, ce que se propose de faire l’ESA dans un contexte de coopération internationale.

GOCE est le début d’une nouvelle série de satellites. GOCE est la première mission de base d’exploration de la Terre s’inscrivant dans le programme "Planète vivante", engagé par l’ESA en 1999 « dans le but de faire avancer la recherche sur l’atmosphère terrestre, la biosphère, l’hydrosphère, la cryosphère et l’intérieur du globe ainsi que sur leurs interactions et de mieux comprendre les conséquences des activités humaines sur ces processus naturels » selon les termes mêmes de l’ESA. D’autres satellites comme SMOS, Cryosat-2, SWARM, ADM-Aeolus, sont prévus dans ce cadre.L’originalité de GOCE est la capacité de déterminer le géoïde moyen (les variations temporelles étant en revanche mesurées par d'autres systèmes satellitaires comme GRACE lancé en 2002 et aussi CHAMP lancé en 2000) avec une résolution spatiale de l’ordre de 100 km, résolution encore jamais obtenue par les méthodes spatiales, les méthodes précédentes ne donnant qu’une résolution de plusieurs centaines de km mais donnant également une très bonne précision pour cette résolution. Il y a une complémentarité entre ces missions.

Pour réaliser l’objectif de GOCE, il faut déjà un senseur de très haute précision que l’on n’avait encore jamais réalisé auparavant, le gradiomètre ; il est composé de 6 accéléromètres montés sur 3 axes perpendiculaires dans une structure ultra stable. Il faut aussi faire des mesures partout à des altitudes aussi basses que possibles soit en pratique autour de 250 km d’altitude, avec une orbite quasi-polaire (96°5). Ceci est aussi une très grande performance en raison du freinage atmosphérique qu’il faut compenser tout en garantissant une très bonne trajectographie.

GOCE est un satellite très complexe pesant plus de 1 tonne, de 5 mètres de long, de 1 m2 de section avec un propulseur ionique pour compenser le freinage. La mission GOCE est prévue pour une durée de deux ans environ incluant deux phases de mesures de chacune 6 mois et une phase de calibration. In fine les anomalies du champ de gravité devraient être déterminées avec une exactitude de 1 mGal (mGal = 10–5m.s–2), les ondulations du géoïde moyen avec une exactitude de 1-2 cm et l’ensemble avec une résolution spatiale de l’ordre de 100 km.L'intérêt de caractériser le gradient de pesanteur et sa variation à la surface de la Terre est très ancien ; il date du XIXe siècle. Sa mesure complémente celle de la pesanteur elle-même, puisqu’elle dit en plus comment elle varie localement, tout autour du point de référence considéré. La première de cette mesure fut réalisée sur Terre par un physicien hongrois Roland Eötvös ; pour lui rendre hommage l’unité de mesure du gradient de pesanteur et de gravité adoptée sera l’Eötvös ou E.U. (10-9 s-2) ; du point de vue unité, c’est une accélération divisée par une distance ; il devrait être possible de la mesurer avec une résolution du millième d’Eötvös et une précision de quelques milli Eötvös. Dès le début de l’ère spatiale, cette mesure fut envisagée à partir de satellites, mais c’est seulement vers la fin des années 70, après le succès de l’expérience de micro accélerométrie CASTOR/CACTUS du CNES lancé en 1975 depuis Kourou en Guyane, que des études importantes débutèrent sur ce sujet, avec le concours irremplaçable de l’ONERA. Le premier projet de mesure de gradient de gravite fut présenté par le Groupe de Recherche de Géodésie Spatiale au séminaire des Arcs en 1981, (prospective CNES), en même temps que ce qui allait devenir le projet TOPEX-Poséïdon. Son nom était GRADIO qui devint ensuite le nom de l’appareil de mesure proprement dit.

GOCE est un satellite très complexe pesant plus de 1 tonne, de 5 mètres de long, de 1 m2 de section avec un propulseur ionique pour compenser le freinage. La mission GOCE est prévue pour une durée de deux ans environ incluant deux phases de mesures de chacune 6 mois et une phase de calibration. In fine les anomalies du champ de gravité devraient être déterminées avec une exactitude de 1 mGal (mGal = 10–5m.s–2), les ondulations du géoïde moyen avec une exactitude de 1-2 cm et l’ensemble avec une résolution spatiale de l’ordre de 100 km.L'intérêt de caractériser le gradient de pesanteur et sa variation à la surface de la Terre est très ancien ; il date du XIXe siècle. Sa mesure complémente celle de la pesanteur elle-même, puisqu’elle dit en plus comment elle varie localement, tout autour du point de référence considéré. La première de cette mesure fut réalisée sur Terre par un physicien hongrois Roland Eötvös ; pour lui rendre hommage l’unité de mesure du gradient de pesanteur et de gravité adoptée sera l’Eötvös ou E.U. (10-9 s-2) ; du point de vue unité, c’est une accélération divisée par une distance ; il devrait être possible de la mesurer avec une résolution du millième d’Eötvös et une précision de quelques milli Eötvös. Dès le début de l’ère spatiale, cette mesure fut envisagée à partir de satellites, mais c’est seulement vers la fin des années 70, après le succès de l’expérience de micro accélerométrie CASTOR/CACTUS du CNES lancé en 1975 depuis Kourou en Guyane, que des études importantes débutèrent sur ce sujet, avec le concours irremplaçable de l’ONERA. Le premier projet de mesure de gradient de gravite fut présenté par le Groupe de Recherche de Géodésie Spatiale au séminaire des Arcs en 1981, (prospective CNES), en même temps que ce qui allait devenir le projet TOPEX-Poséïdon. Son nom était GRADIO qui devint ensuite le nom de l’appareil de mesure proprement dit.

Compte tenu du coût du projet, une coopération internationale chercha alors à se mettre en place avec la NASA et l’ESA, et le nom du projet fut ARISTOTELES. Malheureusement ce projet ne put se faire pour diverses raisons, et les opportunités espérées au milieu des années 90 ne purent se concrétiser. Plusieurs Argonautes durent batailler ferme pour que ce projet ne sombre pas définitivement !

Leur idée fut alors de réorienter le projet dans le cadre plus général de l’observation systématique de la planète Terre, et de mettre plus fortement en exergue au niveau européen (ESA), la mesure de la circulation océanique. En effet, cette caractéristique devenait accessible, d'une part grâce à la connaissance globale du géoïde, (avec une résolution encore jamais atteinte, d’où l’acronyme GOCE se rapprochant de WOCE : World Ocean Circulation Experiment), et d'autre part grâce à la mesure ultra précise de la surface topographique de la mer par altimétrie spatiale (série Jason de la coopération franco-américaine, et satellite européen Envisat).

Rappelons qu’en 1969, la NASA organisa un atelier de travail à Williamstown aux États-Unis pour identifier les résultats accessibles avec des mesures spatiales. Plus de 150 chercheurs et ingénieurs participèrent à cette rencontre. Le document final fut appelé « Earth and Ocean applications Physics (EOPAP) » et a constitué pendant près de 40 ans une base solide. qui comportait déjà en exergue les mots « Earth » et « Ocean ». Ce lancement réussi est ainsi un point d’orgue et aussi un point de départ.GOCE a fini par émerger de la compétition extrêmement sévère entre projets spatiaux de qualité, et a été lancé... le 17 mars 2009... 40 ans après les premières réflexions!!! et plus d’un siècle après les travaux d’Eötvös. Souhaitons que les résultats soient à la hauteur de toutes ces années d'efforts. On peut aujourd’hui être optimiste : les consortiums mis en place pour le traitement des données au niveau européen, et au niveau français FROG, sont très bien préparés pour cela.

Mois de Février 2009

1/3 - Réchauffement inexorable ?

Même si l’humanité réussit à maîtriser ses pollutions, en particulier ses émissions de Gaz à Effet de Serre (GES), très probables responsables d’un réchauffement climatique qui affectera les siècles à venir, la chaleur dissipée par la consommation des énergies non renouvelables, nécessaires au maintien d’un mode de vie de nos sociétés proche de l’actuel, conduira inexorablement à un réchauffement de la Terre de plusieurs degrés Celsius à l’échelle de seulement quelques siècles (10 °C dans 450 ans !).

Même si l’humanité réussit à maîtriser ses pollutions, en particulier ses émissions de Gaz à Effet de Serre (GES), très probables responsables d’un réchauffement climatique qui affectera les siècles à venir, la chaleur dissipée par la consommation des énergies non renouvelables, nécessaires au maintien d’un mode de vie de nos sociétés proche de l’actuel, conduira inexorablement à un réchauffement de la Terre de plusieurs degrés Celsius à l’échelle de seulement quelques siècles (10 °C dans 450 ans !).

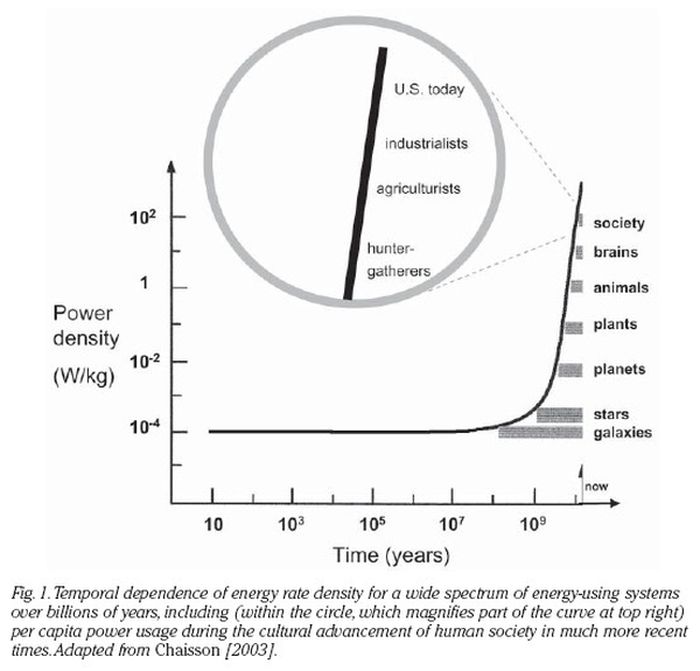

C’est ce qu’affirme, Eric Chaisson, chercheur du Harvard College Observatory (Cambridge, Massachussetts) dans un article publié dans Eos, le bulletin hebdomadaire de l'American Geophysical Union.

Son argumentation est fondée sur les conséquences de l’application du deuxième principe de la thermodynamique qui stipule que toute énergie, quelle que soit son origine, se transforme inéluctablement en chaleur. Or depuis la formation des galaxies et des étoiles jusqu’aux sociétés humaines, pour maintenir ordonnées ces structures inertes ou vivantes de plus en plus complexes il faut consommer de l’énergie et donc à terme produire de la chaleur. Depuis l’apparition de la vie sur Terre il y a quelque milliards d’années et de l’espèce humaine il y a quelques millions d’années, le bilan de l’énergie consommée pour maintenir cette vie et notre espèce, de plus en plus exigeante, croit exponentiellement. Ce bilan peut s’exprimer par une densité d’énergie par kilogramme de matière (Watts par Kilogrammes). Elle était de 102 W.Kg-1 à l’apparition des sociétés humaines de chasseurs-cueilleurs. Actuellement elle est de l’ordre de 250 W.Kg-1 dans les pays développés.

Mais l’énergie totale consommée continuera de croître pour trois raisons :

- la démographie (9 milliards d’habitants en 2050),

- l’émergence des pays en développement qui tendront à atteindre l’équité avec les pays développés en matière de confort,

- et surtout le taux de consommation d’énergie par tête d’habitant qui va probablement continuer de croître, ne serait-ce que pour lutter contre les impacts du changement climatique (déplacement de villes submergées par la montée du niveau de l’océan, climatisation, séquestration des GES,…).

Certes des économies d’énergie sont possibles en améliorant le rendement des différentes machines utilisées (le rendement actuel de la production d’électricité est de 37 %, celui d’un moteur de voiture de 25 % et celui d’une lampe à incandescence de 5 % !). Mais finalement toute cette énergie, quelque soit son origine et l’efficacité de son usage, sera transformée en chaleur et élèvera la température de la Terre.

Actuellement notre mode de vie sur l’ensemble de la surface de la Terre consomme approximativement 18 terawatts dont les deux-tiers sont gaspillés, c’est encore peu comparé au 120 000 terawatts du flux solaire qui domine le bilan d’énergie de la Terre.

Mais la croissance de la consommation humaine d’énergie estimée à 2 % par an, ajoutée à la croissance démographique, conduira, d’après l’auteur de l’article, à une demande de consommation d’énergie de 100 terawatts à la fin du XXIe siècle et elle continuera de croître. L’énergie reçue du soleil sur Terre (hors albedo) est dans sa quasi-totalité déjà transformée en chaleur et l’utilisation d’énergies renouvelables qui en découlent comme le vent, les vagues, les énergies thermiques des mers ne modifient pas ce bilan. En revanche toutes les autres sources d’énergies pour satisfaire les besoins des sociétés humaines (charbon, pétrole – celles-ci sont bien aussi d’origine solaire mais renouvelables à seulement très long terme - nucléaire,…) alourdissent le bilan de chaleur et augmentent la température de la Terre. L’exemple de l’accroissement déjà constaté de la température dans les villes en témoigne.

De ce fait l’équilibre radiatif de la Terre sera modifié même si l’humanité maîtrise ses émissions de GES car il ne dépend pas seulement du rayonnement solaire et de l’effet de serre additionnel. Si l’utilisation globale d’énergies non renouvelables continue de croître au taux actuel de 2 % par an et même si l’on suppose que la totalité des GES qui en résultent est « séquestrée », la température moyenne croîtrait de 3 °C dans les 280 prochaines années. De manière plus réaliste, un scénario plus complexe différentiant les taux de consommation d’énergie non renouvelable des pays développés et en développement, et toujours en l’absence de production supplémentaire de CO2, conduirait à une augmentation de température de 3° C dans 350 ans, voire 10° C dans 450 ans !

Ainsi la Terre pourrait devenir inexorablement invivable pour l’espèce humaine si son mode de développement reste fondé sur les consommations énergétiques qui sont les siennes actuellement, même si elle maîtrise la question de ses émissions de GES avec l’effet de serre additionnel et le changement climatique induit. C’est une conséquence des lois de la thermodynamique, oubliée dans les prévisions des climats futurs basées uniquement sur le changement de la composition chimique de l’atmosphère par émission de GES anthropiques. Une rapide diminution de la consommation d’énergie par l’humanité s’impose pour éviter la surchauffe.

2/3 - Lohafex, polémiques autour de la fertilisation en fer de l’océan Antarctique

Avant de débattre des controverses à propos de la campagne à la mer en cours à bord du navire océanographique allemand Polarstern, il est conseillé de lire l’article mis en ligne en avril 2007 dans la rubrique FAQ de ce site, intitulé :

"La fertilisation des océans? La solution au problème"

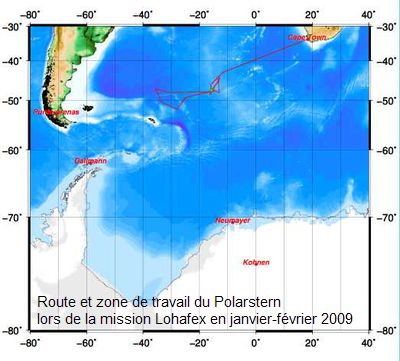

Le navire de recherche polaire Polarstern, qui a quitté Le Cap le 7 janvier, se trouve dans les parages de la Géorgie du Sud (voir figure ci-contre).

Après avoir été suspendue le 14 janvier par le Ministère allemand de l’environnement, la mission vient de recevoir l’autorisation de se poursuivre à la suite de rapports scientifiques et législatifs demandés à quatre instances :

- le British Antarctic Survey,

- l’Institut Leibniz de sciences marines de l’université de Kiel,

- l’Institut Max Planck de droit international public et droit des peuples

- et l’Institut de droit international de l’université de Kiel

Leur conclusion est qu’il n’y a aucune raison écologique ni juridique de bloquer la campagne Lohafex (‘Loha’ en hindi signifie fer et ‘fex’ Fertilization EXperiment) conduite par l’Institut Alfred Wegener de Bremerhaven en partenariat avec l’Institut national d’océanographie indien; l’équipe est composée de 48 scientifiques dont 30 chercheurs indiens.

Le Polarstern vient de répandre 10 tonnes de sulfate de fer sur une surface de 150 km2 à une profondeur moyenne de 15 m. Un traceur, l’hexafluorure de soude, est ajouté pour permettre le suivi de la nappe fertilisée : 500 g de SF6 suffisent pour cette surface, l’hexafluorure étant mesurable à très basse concentration. Selon la réponse du phytoplancton, un second ensemencement de 10 tonnes sera effectué pour compenser les pertes par précipitation et sédimentation du fer qui, s’il n’est pas utilisé par les organismes, est rapidement converti en particules de rouille. Dans les expériences précédentes, ce réensemencement a toujours été nécessaire.

Alertés par des mouvements écologistes, les médias mondiaux ont multipliés les titres alarmistes où fleurissent les termes « incertitudes », « controverses » et « polémiques ». Que faut-il en penser ?

- par la surface concernée et la quantité de fer déversée (équivalente à celle qui est libérée lors de la fonte d’un iceberg), cette expérience ne s’écarte pas de la bonne dizaine de celles qui l’ont précédé dans toutes les aires riches en sels nutritifs et pauvres en chlorophylle de l’océan mondial, notamment dans l’océan Antarctique;

- elle se déroule dans un environnement où les teneurs élevées en silicates favoriseront la croissance des diatomées. Il s’agit d’un point essentiel car, pour être efficace en termes de pompage de CO2, l’élévation de la production primaire doit être due à ces algues siliceuses qui, seules, exportent rapidement en profondeur une part notable du carbone organique photosynthétisé;

- par la durée du suivi, Lohafex devrait permettre d’observer l’effet du rehaussement de la production primaire sur le zooplancton et le micronecton, notamment le krill. Ceci n’a jamais été réalisé durant les expériences précédentes; il s’agit certainement de l’objectif majeur de l’équipe de Victor Smetacek, co-chef de mission.

S’il est possible, à partir d’expériences en flacons, de modéliser le rehaussement de la production primaire, on ne peut simuler l’impact sur le zooplancton ou sur le flux de carbone exporté; des expériences grandeur nature sont nécessaires. Lohafex est un programme de recherche fondamentale indispensable pour combler les lacunes sur l’impact de la fertilisation en fer de l’océan sur le réseau trophique et le « pompage biologique » de CO2.

La polémique autour de Lohafex tient probablement à l’enthousiasme et au travail de lobbying de certains industriels prêts à saupoudrer de fer toutes les zones océaniques propices. Or, jusqu’à maintenant, ces expériences, si elles ont confirmé le rôle limitant du fer, n’ont jamais montré qu’elles permettaient un stockage massif et à long terme du CO2. D’autre part, les processus naturels, comme l’enrichissement en fer, d’eau remontant le long du plateau des Kerguelen, sont bien plus efficaces que la fertilisation artificielle car une bonne partie du sulfate de fer ajouté à l’eau de mer n’est pas utilisée par le phytoplancton. Dans ce bilan, on doit tenir compte d’effets secondaires néfastes; citons-en deux :

- l’oxydation de l’excès de matière organique exportée vers l’océan profond peut conduire à l’épuisement du dioxygène dissous (milieu anoxique); dans l’aire de remontée péruvienne, il disparaît dès 100 m de profondeur. Se met alors en place un changement de système redox et on s’adresse à l’oxygène des nitrates (NO3–) avec la formation de diazote et de protoxyde d’azote (N2O). Quand l’eau est saturée en N2O, celui-ci s’échappe vers l’atmosphère; or, son pouvoir de réchauffement global est 275 fois celui du CO2;

- l’appauvrissement en sels nutritifs des eaux modales et de l’eau antarctique intermédiaire. Cet appauvrissement d’eaux évacuées vers le Nord ne sera pas sans conséquence sur la productivité des systèmes d’upwellings de l’hémisphère Sud, notamment dans la région Pérou-Chili. Plusieurs océanographes comme Jorge Sarmiento et Mark Brzezinski ont illustré les fluctuations de la productivité de ces écosystèmes durant l’holocène. Il semble donc logique de décréter un moratoire avant le lancement de projets industriels et commerciaux à grande échelle en rejoignant la position de Stéphane Blain dans La Recherche (décembre 2007) dont l’article s’intitule « Ne manipulons pas l’océan ».

L’acceptation de la campagne Lohafex nous paraît logique puisque son but est d’améliorer la compréhension de processus physico-chimiques conduisant à une réduction de la teneur en CO2 de l’atmosphère. Cela ne signifie nullement que les Argonautes militent pour une fertilisation à grande échelle et répétée des eaux riches en sels nutritifs et pauvres en chlorophylle. La priorité absolue est de réduire très fortement les émissions de gaz à effet de serre, ce qui implique un changement de notre mode de vie. Quand l’humanité aura effectué cette prise de conscience et sortira de sa logique consumériste, il sera peut-être temps de « donner un coup de pouce » à la planète, ce que ne rejette pas James Lovelock dans « La revanche de Gaïa » où il remet en cause le mythe qu’il avait créée d’une Terre autorégulée. L’homme est un des éléments de l’écosystème terrestre ; sans l’avoir pressenti, il a, par l’accroissement de sa population et des ses activités, bouleversé le fonctionnement planétaire dans des proportions inimaginables il y a quelques décennies. Nous risquons donc de devoir prochainement décider ou refuser des manipulations comme le stockage de CO2 dans des réservoirs terrestres ou dans les eaux océaniques profondes et la fertilisation en fer des océans en tenant compte toutefois d’une certaine réversibilité à moyen terme. Il n’y a en effet rien d’aberrant à ce que, sciemment maintenant, l’homme envisage de manipuler la nature pour l’amener à réagir dans un sens qui limite le réchauffement global.

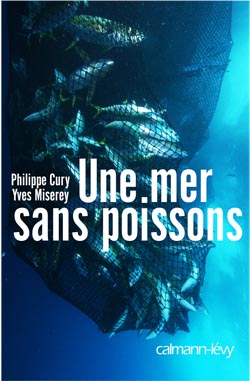

3/3 - Une mer sans poissons ? Philippe Cury et Yves Miserey

Ce livre est un état des lieux de l’exploitation des ressources biologiques des océans d’autant plus alarmant qu’il s’appuie sur une documentation complète et une analyse fine et équilibrée de données parfois méconnues en France.

Une des difficultés des modèles halieutiques tient d’abord à ce que les statistiques de pêche dépendent du bon vouloir des états de communiquer des données fiables. Une autre tient à ce que certains abordent la pêche du seul point de vue économique en se désintéressant des systèmes naturels (une théorie des pêches se résumant à une gestion des hommes plutôt qu’à celle des poissons) ; d’autres chercheurs ont la tendance inverse.

Cet ouvrage, exempt de toute équation, dépourvu du moindre graphique et de la moindre illustration, se lit aisément. Il touchera un public d’autant plus large qu’il est émaillé de récits historiques et que chaque lecteur se plongera avec nostalgie dans le souvenir des terre-neuvas ou des chasseurs de baleines et qu’il met en lumière les conceptions surprenantes de pas mal de grands écrivains qui avaient une vision d’une mer aux ressources illimitées.

Ainsi, dans son Grand dictionnaire de cuisine, Alexandre Dumas écrit : «On a calculé que si aucun accident n’arrêtait l’éclosion de ces œufs et si chaque cabillaud venait à sa grosseur, il ne faudrait que trois ans pour que la mer fut comblée et que l’on put traverser l’Atlantique sur le dos des cabillauds».

Ce livre pourrait illustrer la maxime de François Arago, le premier des grands vulgarisateurs français, qui, à propos de son cours d’astronomie populaire, écrivait : «Le cours sera complet quant au fond et élémentaire seulement pour la forme».

Une des difficultés de l’approche des pêches tient à ce que écologistes et économistes ne travaillent pas fréquemment ensemble, ne publient pas dans les mêmes revues et n’ont pas les mêmes discours ni parfois les mêmes outils alors que leur coopération est indispensable. En pêchant toujours plus loin, toujours plus profond, toujours pus petit avec des techniques de plus en plus performantes, le pillage des océans est systématique et aveugle. Au rythme de cent millions de tonnes de poissons pêchés par an, non seulement la ressources s’épuise mais les écosystèmes sont déstabilisés.

On cherche malheureusement en vain les prémices d’une gouvernance mondiale seule à même de rétablir la productivité des océans. Et la plupart des pays redoutent de se mettre à dos leurs pêcheurs, la France plus que tout autre.

Philippe Cury est docteur es sciences, membre de l’IRD, il dirige le Centre de recherche halieutique méditerranéenne et tropicale de Sète.

Yves Miserey est journaliste scientifique au Figaro.

Le 27 janvier dernier, Philippe Cury donnait une conférence à l'IDDRI sur le thème : "Une mer sans poissons : "Vers une approche écosystémique des pêches"..

Mois de Janvier 2009

1/1 - À propos de la variabilité inter-annuelle, décennale, et multi séculaire du Climat. (Cette inconnue... du grand public !)

Le climat de notre planète comporte de nombreuses composantes périodiques ou quasi périodiques; nos sens permettent, (même si l'on "naît pas" climatologue !), de percevoir l'une d'entre elles : la régularité du retour des saisons nous fait prendre conscience de l'existence d'un "signal"... de période proche de 365 jours.

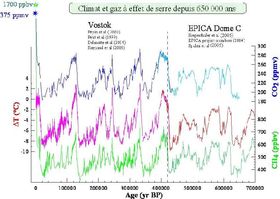

Cependant, la variabilité du climat comporte bien d'autres composantes, dont certaines de période beaucoup plus longue : depuis le sondage de Vostock en Antarctique, et la célèbre courbe de Claude Lorius, on ignore moins l'alternance - tous les 100 000 ans environ - de longues périodes glaciaires, (pendant lesquelles le niveau des mers peut descendre d'une centaine de mètres), avec des périodes plus courtes, que l'on nomme "interglaciaires" (et au cours desquelles le niveau des mers peut dépasser de quelques mètres sa valeur actuelle).

Cependant, la variabilité du climat comporte bien d'autres composantes, dont certaines de période beaucoup plus longue : depuis le sondage de Vostock en Antarctique, et la célèbre courbe de Claude Lorius, on ignore moins l'alternance - tous les 100 000 ans environ - de longues périodes glaciaires, (pendant lesquelles le niveau des mers peut descendre d'une centaine de mètres), avec des périodes plus courtes, que l'on nomme "interglaciaires" (et au cours desquelles le niveau des mers peut dépasser de quelques mètres sa valeur actuelle).

Entre ces 2 extrêmes, (dans le retour de conditions moyennes comparables, tous les ans ou... tous les 100 000 ans !), il existe, entre autres, des variations à une échelle dite "décennale", dont la plus connue est le phénomène "El Niño", (que les climatologues appellent plutôt ENSO : El Niño Southern Oscillation) ; il y a aussi la "PDO" (alias Pacific Decadal Oscillation), et la NAO, qui nous touche de plus près... puisqu'il s'agit de l'Oscillation Nord Atlantique ("North Atlantic Oscillation").

C'est ainsi que la variabilité naturelle du climat croise la formidable question du Changement Climatique induit par les activités humaines.